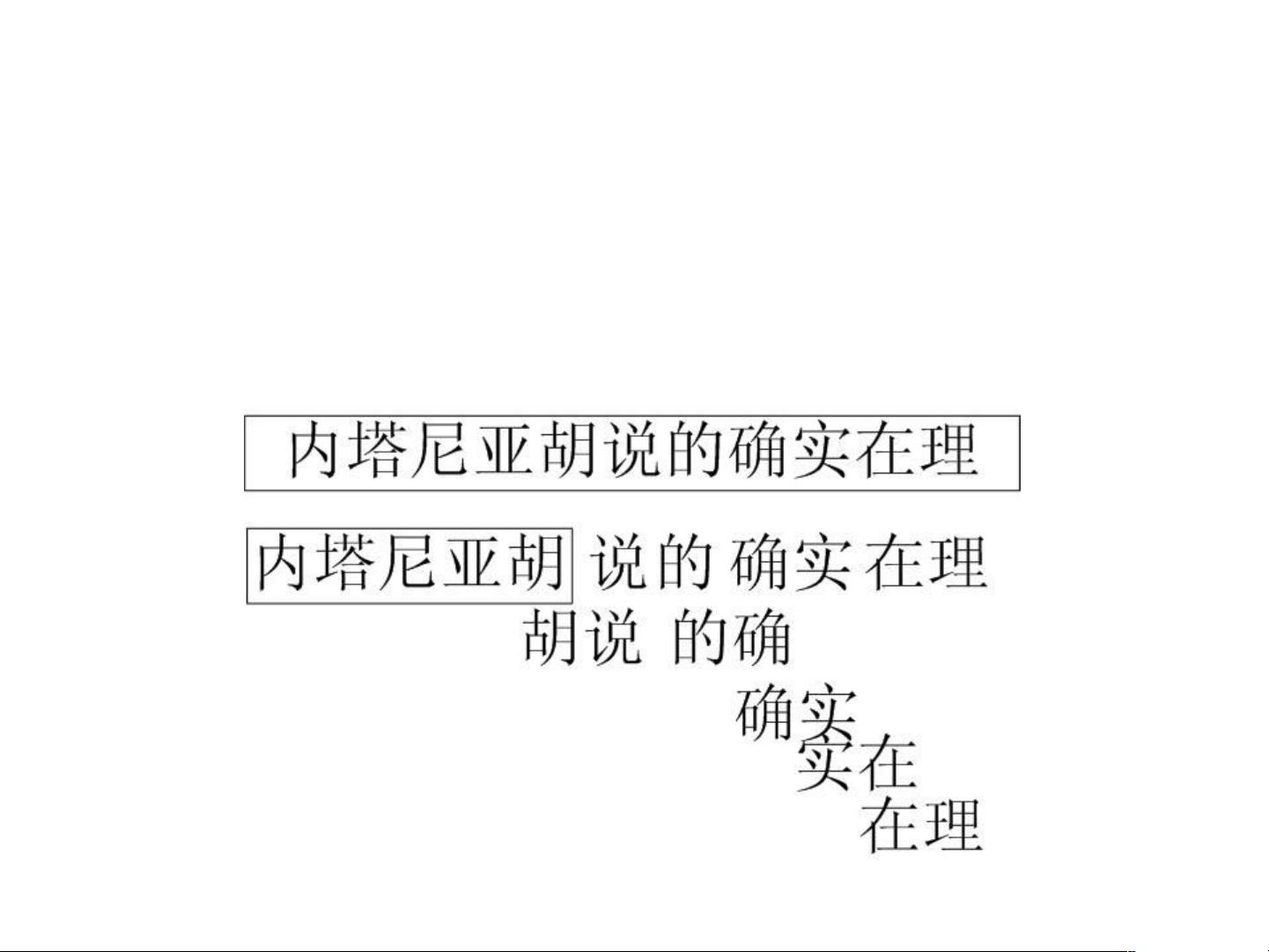

【中文分词】是自然语言处理中的基础环节,其主要目标是将连续的汉字序列划分为具有语义意义的词语序列。例如,句子“内塔尼亚胡说的确实在理”在分词后变为“内塔尼亚胡/说/的/确实/在理”。中文分词在诸多领域都有广泛的应用,如汉字处理、信息检索、内容分析和语音处理等。然而,分词面临着多重挑战,主要包括歧义问题、新词识别和普通词与新词的区分。 歧义问题源于汉字的组合多样性和语境敏感性。交叉歧义是指一个句子可以有多种合理的切分方式,如“内塔内亚胡说的/确实/在理”。组合歧义则指词语组合在不同情境下切分不同,例如“这个人/手上/有痣”或“我们公司/人手”。真歧义则是在某些情况下,几种切分方式都是正确的,如“乒乓球拍/卖/完了”和“乒乓球/拍卖/完了”。 新词的不断涌现也是分词的一大难题,如人名、地名、机构名、网络用语、产品名等。例如,“刘德华”、“谷歌”、“爱国者”等都需要及时识别。此外,普通词与新词的混用和交织增加了分词的复杂性,如“高明表演真好”和“汪洋(人名)到深圳检查工作”。 为了应对这些挑战,分词技术经历了从机械分词到统计分词再到理解分词的发展。机械分词主要依赖词典,如FMM(First-Match Method)和BMM(Best-Match Method),它们通过扫描文本并查找最长匹配词来完成分词。全切分则尝试找出所有可能的切分方案。机械分词的优点在于实现简单、速度快,但对歧义和新词识别能力有限。 统计分词则引入了概率模型,如N-gram模型,通过学习大量语料库中的词频统计信息来提高分词准确率。生成式统计分词基于马尔科夫假设和输出独立性假设,通过最大似然估计(MLE)计算词的概率,并用于分词决策。判别式统计分词进一步引入了特征工程和分类器,如HMM(隐马尔科夫模型)和CRF(条件随机场),以更精准地判断词语边界。 分词技术的评价通常通过国际分词评测来进行,这些评测提供了标准的评估指标,如准确率、召回率和F1值,以衡量不同分词系统的表现。随着深度学习技术的发展,基于神经网络的分词模型也逐渐成为研究热点,例如LSTM(长短期记忆网络)和BERT(双向Transformer编码器)等,它们在处理歧义和新词识别方面表现出了更强的能力。 总结来说,中文分词是一项复杂且关键的自然语言处理任务,涉及到语言学、统计学和计算机科学等多个领域的知识。随着技术的进步,分词系统的准确性和适应性得到了显著提升,为各种自然语言处理应用提供了坚实的基础。

剩余42页未读,继续阅读

- 粉丝: 1

- 资源: 2

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功