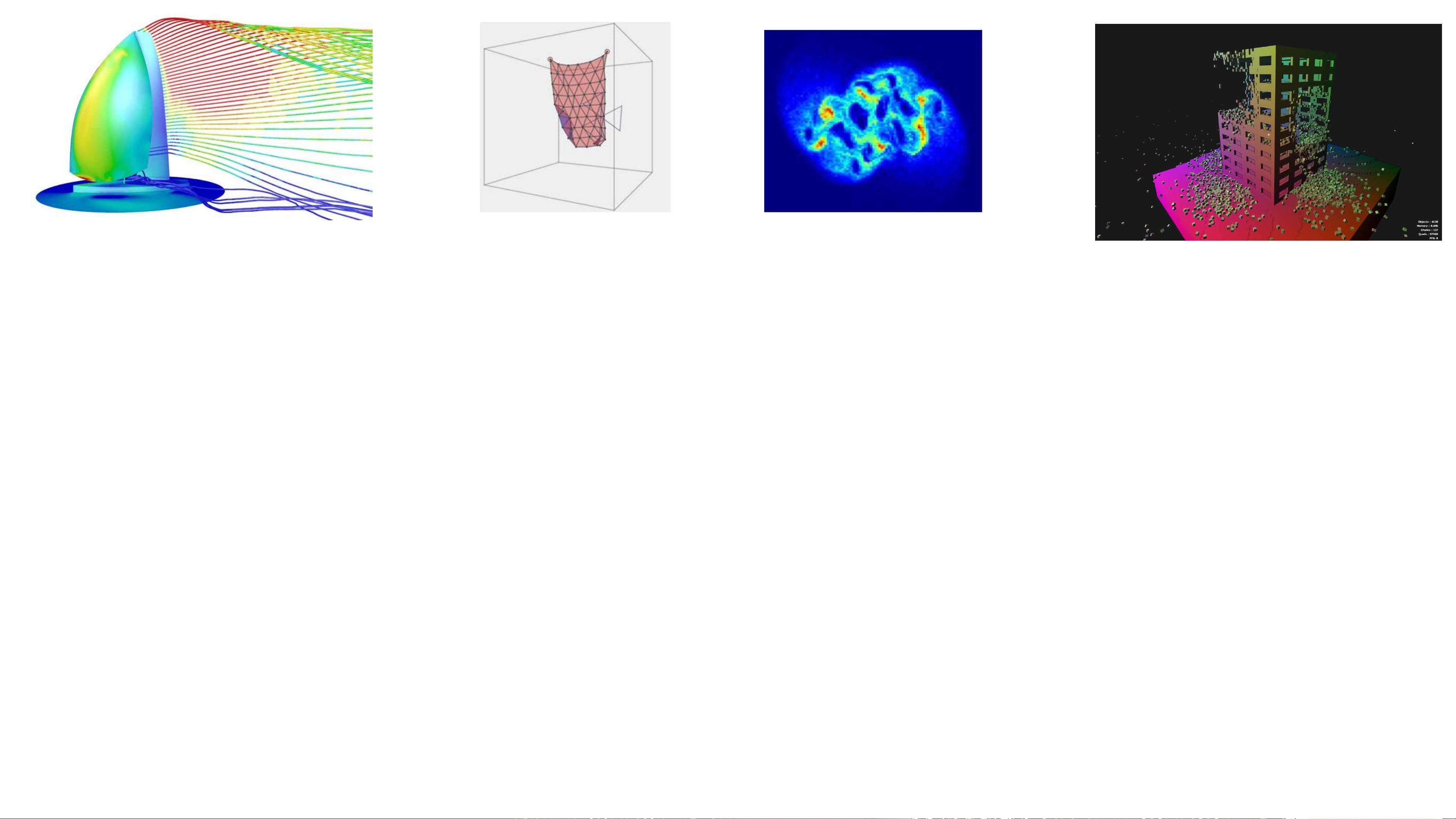

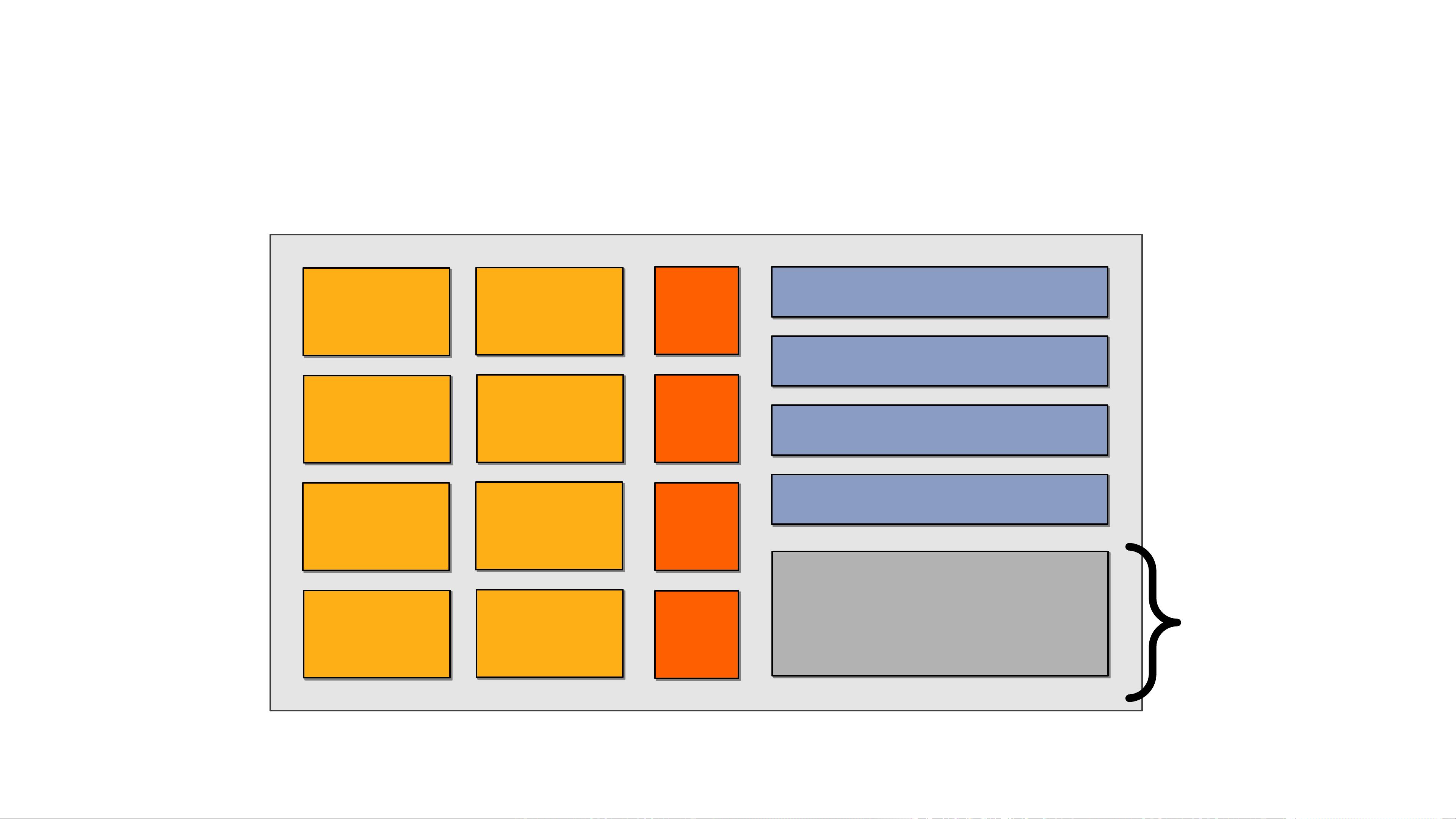

GPU,GPU工作原理;Introduction to GPU Architecture Based on “From Shader Code to a Teraflop: How GPU Shader Cores Work”, By Kayvon Fatahalian, Stanford University GPU,或图形处理器,是现代计算机系统中不可或缺的一部分,尤其在高性能计算、机器学习和并行计算领域。本文将深入介绍GPU的工作原理,基于斯坦福大学Kayvon Fatahalian的文章"From Shader Code to a Teraflop: How GPU Shader Cores Work"。 一、GPU运行快速的三大理念 1. 并行处理:GPU的核心设计围绕着大量并行执行的计算单元,称为Shader Core。这些核心同时处理多个任务,使GPU能够快速地执行大量的简单运算,例如在图形渲染中的像素着色。 2. 专门化硬件:GPU内含特定的硬件加速器,如纹理采样器(Texture Sampler)和浮点运算单元,优化了图形处理和计算密集型任务。这使得GPU在处理特定类型的工作负载时,性能远超传统CPU。 3. 内存层次结构:为了高效地移动数据,GPU具有复杂的内存层次结构,包括高速缓存和全局内存。这种设计减少了数据访问延迟,提高了处理速度。 二、GPU架构剖析 以NVIDIA GTX 580和AMD Radeon 6970为例,这两款GPU都采用了多核心设计,包含多个Shader Core,用于执行各种图形和计算任务。输入组装(Input Assembly)阶段将顶点数据转化为图元,如三角形。光栅化器(Rasterizer)将图元转换为屏幕上的像素。纹理采样器和Shader Core负责执行像素着色器代码,而输出混合器(Output Blend)则处理颜色混合,生成最终的帧缓冲图像。 三、GPU内存层次 理解GPU的内存层次结构至关重要,因为数据移动是性能的关键瓶颈。通常,GPU内存包括寄存器、L1缓存、L2缓存以及全局显存。寄存器是最快速但有限的存储空间,L1缓存提供更快的访问速度,L2缓存则进一步扩展了高速缓存容量。全局显存容量较大,但访问速度相对较慢。优化GPU程序时,应尽量减少全局显存的访问,利用缓存的局部性来提高性能。 四、异构核心:通量处理 GPU通常包含异构核心,部分专为高吞吐量处理设计。这意味着GPU不仅适用于图形处理,还适用于大规模并行计算任务,如机器学习中的神经网络训练。Shader Core的设计允许独立处理大量碎片(Fragments),而无需显式并行编程。编译器会自动将高级语言的着色器代码转换为底层指令,例如Sample、Mul、Madd等,这些指令在GPU硬件上并行执行。 总结,GPU通过其并行处理能力、专门化硬件和内存层次结构优化了图形与计算任务的性能。了解这些基本概念有助于我们优化GPU代码,识别适合GPU架构的工作负载,并有效利用GPU的计算潜力,特别是在机器学习和并行计算领域。理解GPU的工作原理对于开发高效的GPU应用程序至关重要。

剩余69页未读,继续阅读

- 粉丝: 3

- 资源: 5

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功