GT-1612-UB

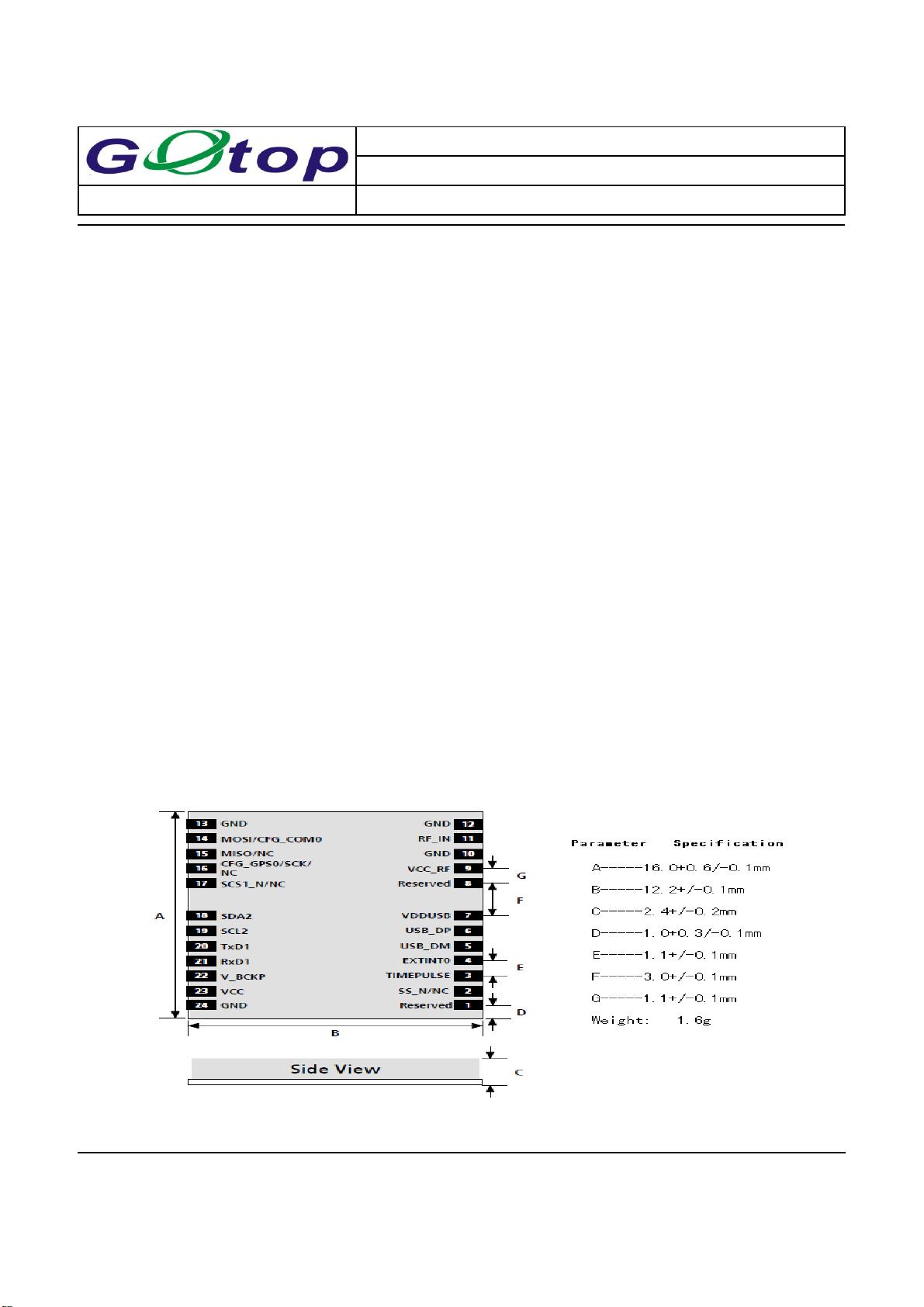

### GT-1612-UB GPS定位模块关键知识点解析 #### 一、产品概述 **GT-1612-UB**是一款采用u-blox 5定位引擎的高度集成GPS接收器模块。该模块以其超高的灵敏度和低功耗特性而著称,非常适合应用于移动设备、便携式导航设备等需要严格控制成本与空间的应用场景。 #### 二、技术特点 1. **u-blox 5 定位引擎:** - **高性能u-blox 5芯片组**构建而成,确保了模块的高效性能和低功耗。 - **极高的灵敏度**:可达-160dBm,能够在弱信号环境下实现稳定定位。 - **极快的首次定位时间(Time To First Fix, TTFF)**:即使在信号较弱的情况下也能迅速完成定位,低于1秒。 - 内置高增益LNA(低噪声放大器),有效提升信号接收质量。 - 最大功耗仅为40mA@3.0V,适合电池供电的移动设备。 - 支持标准的NMEA-0183协议或自定义协议,便于与其他系统集成。 - 工作电压范围宽广,支持2.75V至3.6V。 - 工作温度范围宽,可在-40℃至85℃的环境下稳定运行。 - 小型封装尺寸为16x12.2x2.4mm,节省空间。 - 符合RoHS标准,无铅环保设计。 2. **接收器类型及性能参数:** - 支持L1频段,使用C/A码,具备50个通道。 - 支持多种卫星增强系统,包括WAAS(美国)、EGNOS(欧洲)、MSAS(日本)、GAGAN(印度)等。 - 跟踪灵敏度和捕获灵敏度均为-160dBm,适用于复杂环境下的定位需求。 - 集成了强大的抗干扰技术和多路径效应抑制技术,提高了导航性能。 #### 三、应用场景 1. **基于位置的服务(Location Based Service, LBS)**:如实时定位追踪服务、地理围栏应用等。 2. **便携式导航设备(Portable Navigation Device, PND)**:如车载导航仪、手持GPS等。 3. **车辆导航系统**:用于汽车导航系统中的定位功能。 4. **移动电话**:集成到智能手机中,提供精准的位置服务。 #### 四、结构与接口 - **外观设计**:GT-1612-UB模块采用紧凑的设计,顶部视图如文档中的图1所示。 - **引脚分配**:图2展示了GT-1612-UB的引脚封装情况,具体引脚功能需参考官方数据手册进行详细了解。 - **性能规格**:文档中提供了部分性能参数,包括接收器类型、工作频段、灵敏度等信息,见表1。 #### 五、注意事项 - 该模块不适合用于生命支持或航空领域的产品开发。 - 在使用过程中,应避免任何可能对用户安全、健康或第三方财产造成负面影响的情况。 通过以上分析可以看出,**GT-1612-UB**凭借其出色的性能和紧凑的设计,在众多GPS定位模块中脱颖而出,成为许多移动设备的理想选择。无论是从技术特点还是应用场景来看,它都具有很强的竞争力和广泛的适用性。

剩余19页未读,继续阅读

agndagnd2013-11-28下载了,就是个数据手册而已

agndagnd2013-11-28下载了,就是个数据手册而已

- 粉丝: 0

- 资源: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- php的常用函数总结材料

- 基于Python控制台的精美圣诞树程序设计与实现

- 这个资源包含使用HTML5 Canvas绘制圣诞老人和圣诞树的示例代码,适合开发者在网页中实现节日气氛

- 241840040 李占睿 期末作业.docx

- Google Chrome Chrome 128 macOS Catalina Chrome 128浏览器

- 麦克纳姆轮小车sw2020可编辑全套技术开发资料100%好用.zip

- 苹果连接器Bushing组装自动机sw14可编辑全套技术开发资料100%好用.zip

- CoLoR-Filter: Conditional Loss Reduction Filtering for Targeted Language Model Pre-training

- Microsoft Remote Desktop Beta 10.8.4 支持macOS Catalina的最新版本

- 蓝桥杯编程大赛介绍和心得,分享部分案例题型!

- 红盒子检测27-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- 设施布局优化-粒子群算法

- 工作汇报 ,年终总结, PPT, PPT模板

- js的三种验证码插件,下载即用

- Beyond Compare 4 文件对比 安装、激活

- Deep Bayesian Active Learning for Preference Modeling in Large Language Models

信息提交成功

信息提交成功