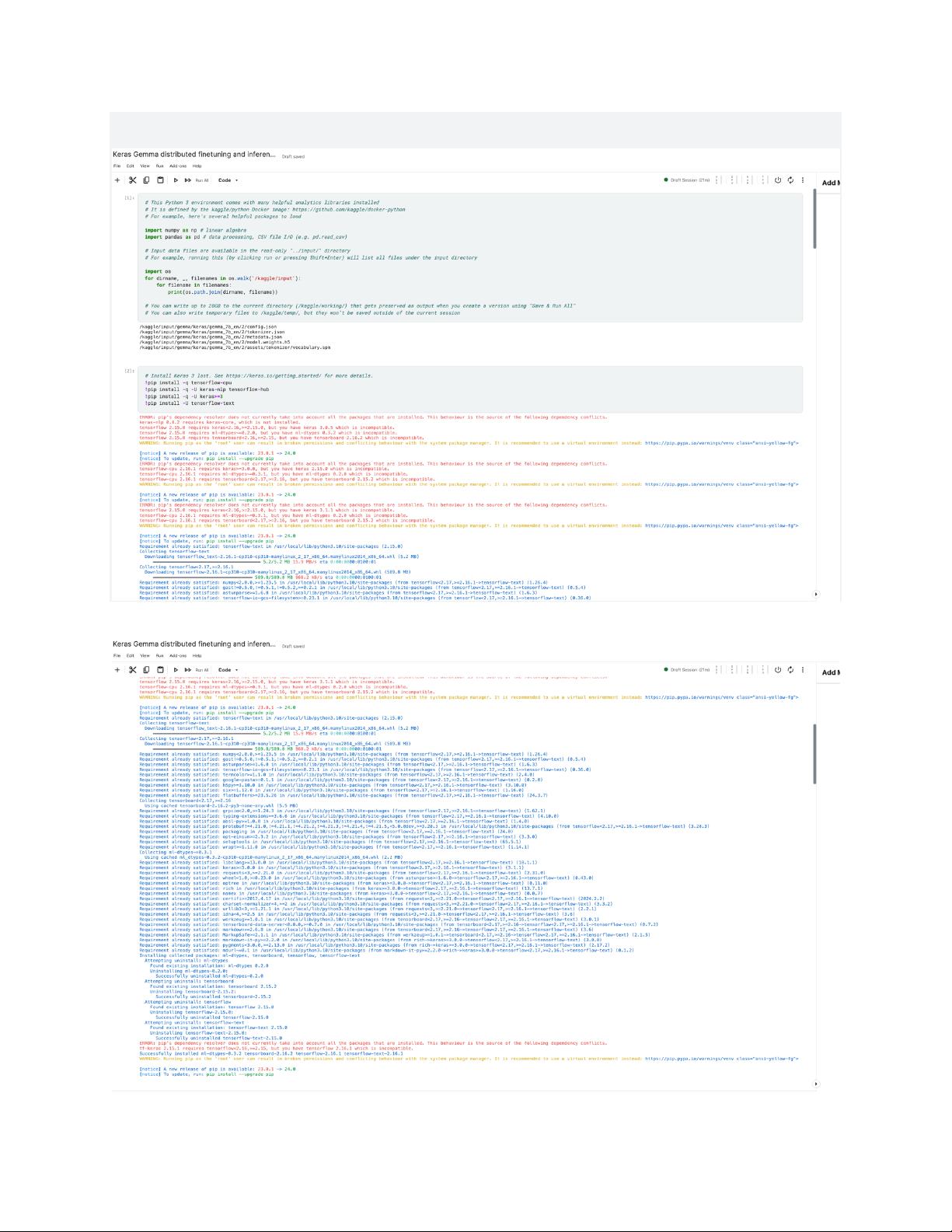

Keras Gemma distributed finetuning and inference.docx

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

根据提供的文件标题、描述以及部分数字序号,我们可以推断出文档主要讨论的是关于使用Keras框架进行Gemma分布式微调(finetuning)和推理(inference)的主题。下面将详细阐述这些概念及其相关知识点。 ### Keras简介 Keras是一个高级神经网络API,可以在TensorFlow等后端上运行。它允许用户快速地搭建和训练深度学习模型,并且提供了易于使用的接口,使得开发人员能够专注于模型的设计与实验,而无需过多关注底层实现细节。Keras因其简洁、模块化和可扩展性等特点,在深度学习领域受到了广泛欢迎。 ### Gemma分布式微调 Gemma分布式微调可能是指在一个分布式计算环境中对预训练模型进行微调的过程。这里的“Gemma”可能是特定的项目名称或者某个特定技术的代称。分布式微调是深度学习模型训练的一种常见策略,尤其适用于大规模数据集。在分布式微调过程中,数据被分割并分布在多个计算节点上,每个节点负责一部分数据的处理。这种方式可以显著提高训练速度,减少训练时间。 #### 分布式微调的关键技术点: 1. **数据分片**:数据被分成多个小块,每个节点处理其中的一部分。 2. **参数同步**:各节点之间的模型参数需要定期同步,以确保所有节点上的模型保持一致。 3. **通信优化**:为了减少节点间通信带来的延迟,通常会采用各种通信优化技术,如异步更新或梯度压缩等。 4. **容错机制**:分布式系统中需要考虑节点故障的可能性,因此需要设计相应的容错机制来保证系统的健壮性。 ### 分布式推理 除了微调之外,文档还提到了分布式推理。推理是指使用已经训练好的模型对新数据进行预测的过程。在分布式环境下,推理也可以通过将任务分散到多个节点上来加速处理过程。 #### 分布式推理的关键技术点: 1. **模型切分**:对于复杂的模型,可以通过将模型的不同层部署在不同的节点上来实现分布式推理。 2. **负载均衡**:确保各个节点的工作量大致相同,避免某些节点过载而影响整体性能。 3. **结果整合**:由于数据和模型可能分布在不同的节点上,因此需要有效的方法来整合来自不同节点的结果。 ### 总结 Keras Gemma分布式微调和推理主要涉及两个方面:一是如何利用分布式计算环境来加速模型的微调过程,二是如何通过分布式系统提高推理的速度。这两个方面都依赖于高效的分布式计算技术和算法设计。通过上述分析,我们不难看出,在处理大规模数据集时,分布式方法不仅可以大大提高模型训练和推理的效率,还可以降低对单个计算资源的要求,从而为企业和个人提供更加灵活和高效的数据处理方案。

- 粉丝: 33w+

- 资源: 554

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功