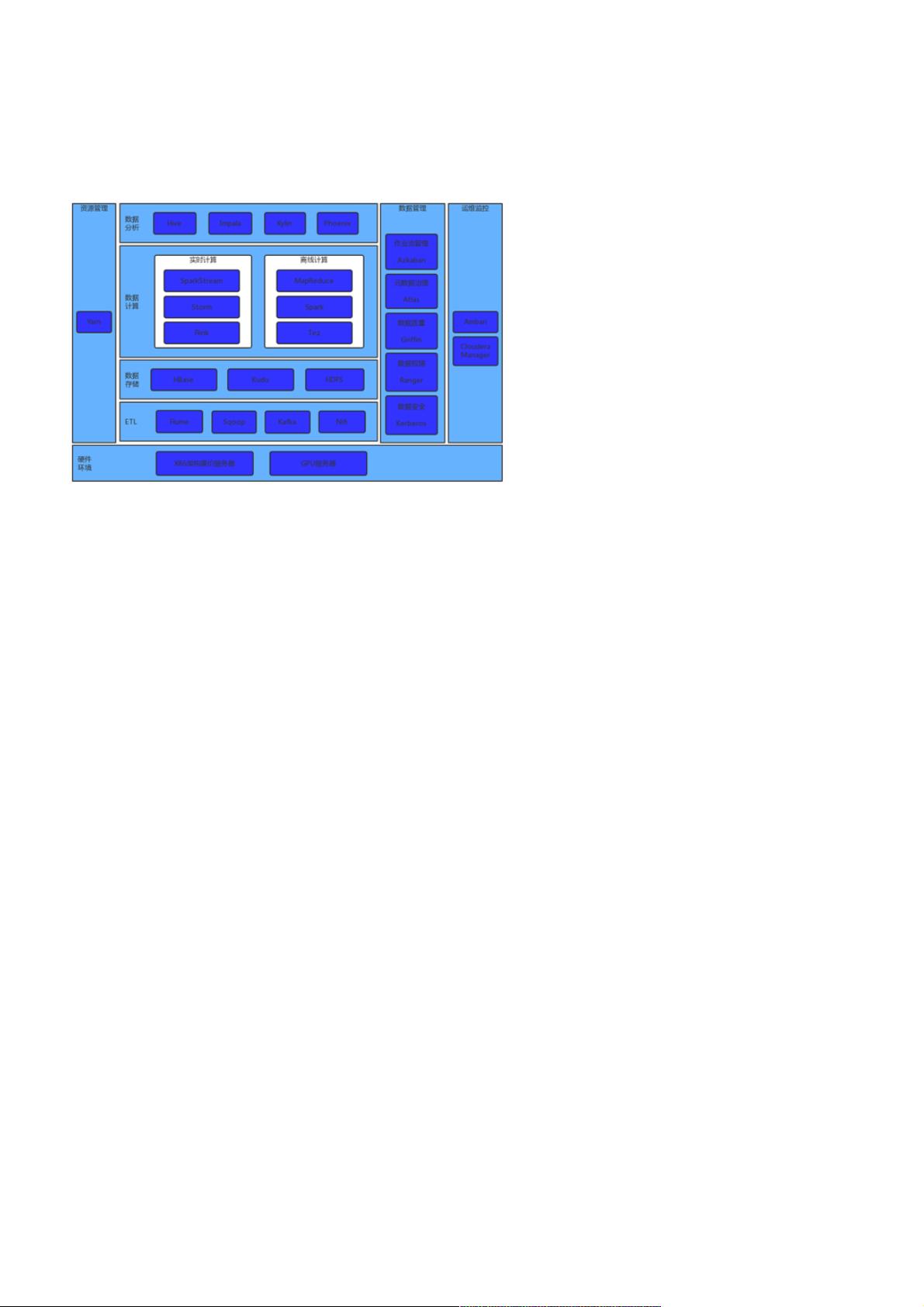

初识⼤数据(五 初识⼤数据(五.⼤数据平台基本架构) ⼤数据平台基本架构) ⼤数据开发,并不仅仅只是⼀两个组件的简单堆砌,⽽是需要按照实际的数据量、数据种类以及实际业务的需要进⾏⼤量的调优和⼆次 开发,构成⼀个有机的整体,这样才能保证⼤数据平台的正常⾼效的运⾏。 ⼀. 以下是⼀个⼤数据平台的基本组成图: 1. 硬件环境: 1) X86架构廉价服务器集群:hadoop技术栈是架构在这种服务器上的,所以价格低,横向可扩展性强。 2) GPU服务器集群:如果需要⽤到机器学习算法,可能使⽤GPU服务器集群。 2. ETL:对各种类型的数据采集与清洗,跟据不同的数据类型选择不同的组件或者数据采集⽅法,⽐如⽤Python编写采集或清洗数据。 3. 数据存储:将采集清洗或处理好的数据存储在⼤数据存储器中。 4. 数据计算: 1) 实时计算:对亿条流数据实时进⾏计算。⽐如志管理、消息队列等。 2) 离线计算:对海量数据进⾏计算,特点是:数据量巨⼤,维度多。 5. 数据分析:对处理好的数据进⾏交互式分析,主要是⽤SQL语⾔进⾏数据的分析。 6. 资源管理:对资源进⾏调度和管理,其中包括:内存、CPU、存储等资源。 7. 数据管理:对数据进⾏安全、质量、权限等的管理以及⼯作流的管理和元数据治理。 8. 运维监控:对hadoop集群、⽣态圈组件进⾏运维、管理和监控。 ⼆.⼤数据开发应具备的基本技能: 1. 精通java、python、scala开发 2. 精通linux使⽤ 3. 精通SQL开发 4. 具有开源代码的阅读能⼒ 5. 熟悉各种组件的使⽤ 大数据平台基本架构是构建高效运行的大数据系统的基石。它涵盖了硬件环境、数据处理流程、资源管理等多个方面,每个环节都至关重要。以下是对这些知识点的详细解释: 硬件环境是大数据平台的基础。X86架构的廉价服务器集群是Hadoop技术栈的常见选择,因为它们成本较低且具有良好的横向扩展性,能够随着数据量的增长而轻松添加更多节点。此外,如果涉及到机器学习任务,可能需要GPU服务器集群,以利用GPU的并行计算能力加速算法的执行。 ETL(Extract, Transform, Load)是数据处理的关键步骤。它包括从不同来源抽取数据、进行清洗和转换,然后加载到数据存储系统中。这个过程可能需要根据数据类型和需求定制解决方案,例如使用Python编写脚本来实现数据采集和清洗。 数据存储环节涉及将清洗和处理后的数据存入大数据存储系统,如HDFS(Hadoop Distributed File System),提供高可用性和容错性,确保数据的安全存储。 数据计算分为实时计算和离线计算。实时计算用于处理大量流数据,如使用Kafka进行消息队列处理,确保数据在产生时即被快速处理。离线计算则针对海量数据,常使用MapReduce或Spark等框架进行批处理,特点是处理的数据量巨大且涉及多维度的分析。 数据分析阶段,通常采用SQL语言对已处理的数据进行交互式分析,以提取有价值的洞察。同时,数据仓库和OLAP(在线分析处理)工具可以提供更高效的数据查询和分析能力。 资源管理是大数据平台的另一个核心部分,负责内存、CPU、存储等资源的分配和调度,确保任务的高效执行。YARN(Yet Another Resource Negotiator)在Hadoop生态系统中扮演了这一角色,为大数据应用程序提供了统一的资源管理和作业调度。 数据管理涵盖了数据的安全性、质量和权限控制,还包括工作流管理和元数据治理,确保数据的完整性和合规性。例如,使用Hive Metastore进行元数据管理,通过Apache Ranger或Kerberos进行安全控制。 运维监控是保障大数据平台稳定运行的关键。这包括对Hadoop集群和生态系统组件的监控和管理,通过工具如Ambari实现报警、性能监控和故障排查。 对于大数据开发人员来说,应具备的技能包括精通Java、Python、Scala等编程语言,熟悉Linux操作系统,掌握SQL语言,有能力阅读和理解开源代码,以及对各种大数据组件的使用有深入的理解和实践经验。这些技能将帮助开发者有效地构建、优化和维护大数据平台。

- 粉丝: 195

- 资源: 3万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功