10年的python开发读取一万行以上的excel文件选择的库.pdf

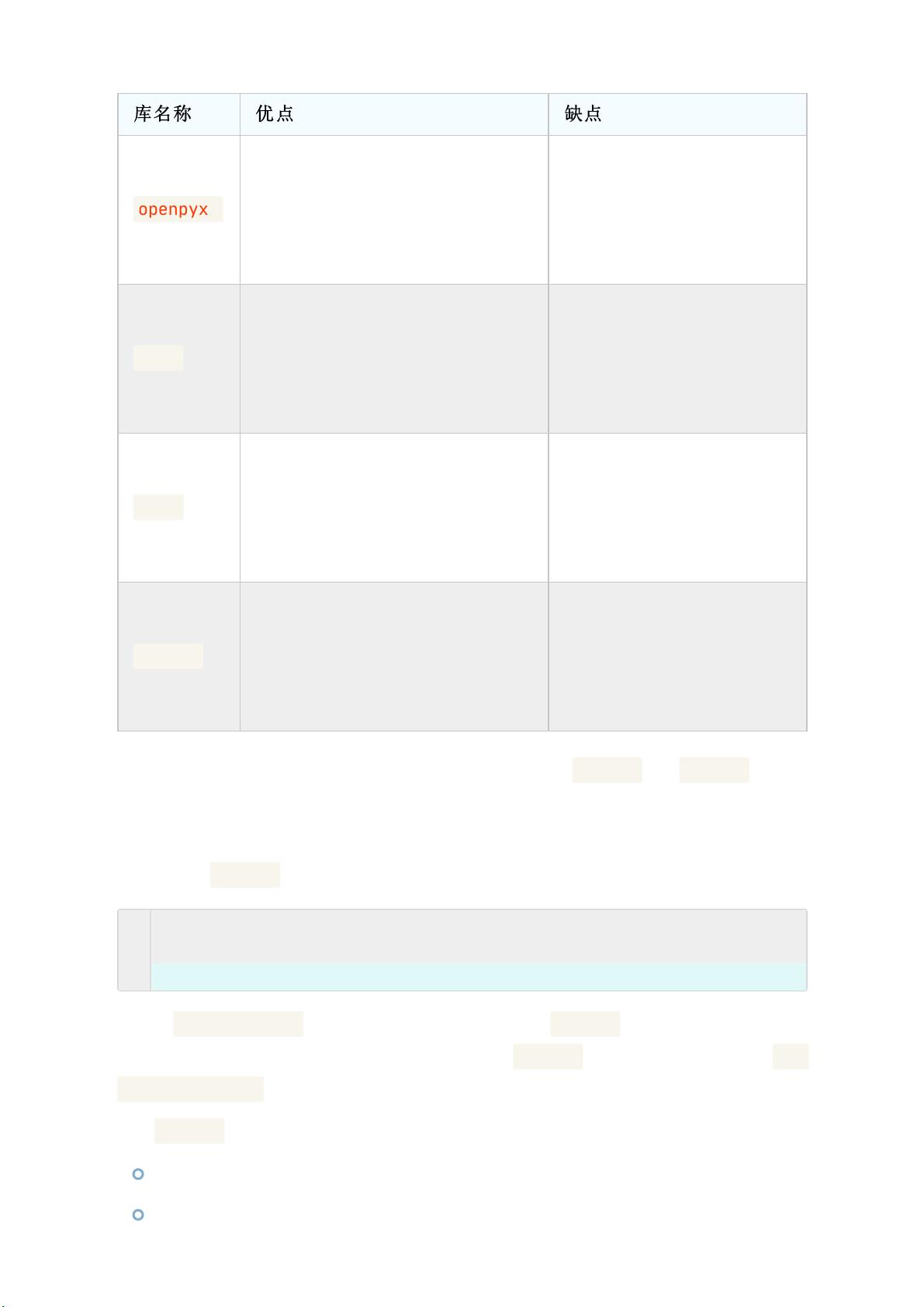

python读取excel数据,python读取大数据excel文件。 本资源是一份关于读取超过一万行Excel文件的Python代码库,适用于中级到高级开发者。该代码库包含了如何快速读取大型Excel文件、如何优化内存占用等技术点。在这个资源中,你将学习到如何使用Python库Pandas和Openpyxl读取大型Excel文件,以及如何使用生成器和多线程等技术优化内存占用。该资源由多个模块组成,包括主模块、辅助模块、测试代码等。你可以在这个资源中学到如何快速高效地读取Excel数据,避免内存占用过多等问题。本资源适用于那些需要读取大型Excel文件的数据分析人员和开发人员。 在Python编程中,读取大型Excel文件是一项常见的任务,尤其对于数据分析和处理而言。当文件行数超过一万行时,传统的读取方法可能会导致内存占用过大,甚至出现内存溢出的问题。在这种情况下,选择合适的库至关重要。在描述中提到了几个常用的Python库,包括Pandas、Openpyxl、xlrd和xlwt,以及如何使用它们来优化内存占用。 Pandas库是Python数据分析领域中最受欢迎的库之一,它提供了一种高效且灵活的方式来读取、操作和分析数据。对于大型Excel文件,Pandas的`read_excel()`函数可以轻松地读取数据。例如: ```python import pandas as pd df = pd.read_excel('data.xlsx') print(df.head()) ``` 上述代码会加载Excel文件中的数据到DataFrame对象,并打印出前五行数据。然而,Pandas并不适合处理非常大的文件,因为它会一次性加载所有数据到内存,可能导致内存消耗过大。为了解决这个问题,可以采用以下策略: 1. **分块读取**:Pandas提供了`chunksize`参数,允许我们按块读取数据,这样可以显著减少内存使用。例如,我们可以每次读取1000行: ```python chunksize = 1000 chunks = [] for chunk in pd.read_excel('data.xlsx', chunksize=chunksize): chunks.append(chunk) df = pd.concat(chunks) ``` 2. **使用生成器**:通过将数据读取转换为生成器,可以在不占用大量内存的情况下逐行处理数据。 3. **并行处理**:利用多线程或多进程,可以同时处理多个数据块,提高读取效率。 Openpyxl库专注于读写Excel 2010及以上版本的XLSX文件,它的优势在于写入性能,尤其是对于大型文件。尽管Openpyxl在读取大型文件时可能不如Pandas方便,但在某些场景下,如需对Excel文件进行逐行写入或修改,它是一个很好的选择。 xlrd和xlwt是两个较老的库,分别用于读取和写入Excel文件。它们支持的文件格式较为广泛,但不支持Excel 2007以上的XLSX格式,并且在处理大型文件或复杂格式时效率较低。 总结一下,如果你需要在Python中读取大量Excel数据,Pandas是一个很好的起点,但要注意其内存管理问题。对于超过一万行的文件,应考虑使用分块读取、生成器或并行处理技术。而Openpyxl、xlrd和xlwt则在特定场景下有其优势,可以根据实际需求选择合适的方法。在学习和使用这些库时,理解它们的特点和限制,以及如何优化内存使用,将有助于提高代码的性能和效率。

- 粉丝: 4071

- 资源: 103

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功