网络爬虫是从web中发现,下载以及存储内容,是搜索引擎的核心部分。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。 参照开放源码分析网络爬虫实现方法,给出设计方案,画出设计流程图。 选择自己熟悉的开发环境,实现网络爬虫抓取页面、从而形成结构化数据的基本功能,界面适当美化。给出软件测试结果。 1. **设计目的** 网络爬虫设计的主要目的是掌握如何利用编程语言,如Python,从互联网上自动搜集和处理大量信息。这有助于理解搜索引擎背后的工作原理,以及如何构建一个能有效抓取和存储网页内容的系统。通过这个项目,学生可以提升对网络数据抓取、数据处理和数据分析能力。 2. **设计任务内容** 任务包括选择合适的开发环境(通常Python开发工具如PyCharm或VSCode),设计并实现一个网络爬虫程序,该程序能从特定的网页出发,按照一定的规则抓取链接,遍历网页结构,下载页面内容,并进行一定程度的解析和存储。此外,还需要对界面进行简单的美化,以提高用户体验,并对软件进行测试以验证其功能的正确性和稳定性。 3. **网络爬虫程序总体设计** 网络爬虫通常由四个主要组件构成:URL管理器、网页下载器、网页解析器和数据输出器。URL管理器负责管理待爬取的网址队列;网页下载器则负责获取这些URL对应的网页内容;网页解析器将下载的HTML或XML内容解析成有意义的数据结构;数据输出器将解析后的数据存储到数据库或文件中。 4. **网络爬虫程序详细设计** - **设计环境和目标分析**:选择Python作为开发语言,因为它有丰富的库支持网络爬虫开发,如requests用于HTTP请求,BeautifulSoup或lxml用于解析HTML。目标是创建一个能够递归地爬取网页、提取有用信息并存储的爬虫。 - **爬虫运行流程分析**:爬虫首先从起始URL开始,获取页面,然后提取页面上的新URL,将它们添加到待爬取的URL队列,重复此过程,直到达到预设的停止条件(如达到特定深度、数量限制或时间限制)。 - **控制模块详细设计**:控制模块协调各个组件的工作,决定何时启动爬虫,何时停止,以及如何处理抓取的网页。 - **爬虫模块详细设计** - **URL管理器**:管理URL的队列,确保没有重复和已访问过的URL。 - **网页下载器**:使用requests库发送HTTP请求,获取网页内容。 - **网页解析器**:通过BeautifulSoup或lxml解析HTML,找到并提取所需数据。 - **数据输出器**:将提取的数据以结构化的形式(如CSV或数据库记录)存储,以便后续分析。 5. **调试与测试** 在调试过程中,可能遇到的问题包括URL解析错误、编码问题、网络连接故障等。测试应覆盖爬虫的各个方面,包括URL管理的有效性、下载器的正确性、解析器的准确性以及数据输出的完整性。测试数据应包含各种情况,如正常页面、重定向、错误页面等,以确保爬虫在不同场景下都能正常工作。 6. **课程设计心得与体会** 通过网络爬虫的设计和实现,学生可以深刻理解网络数据的抓取与处理流程,锻炼解决问题的能力,同时也能学习到如何优雅地处理网络异常和错误,增强软件工程的实践经验。 总结来说,基于Python的网络爬虫课程设计是一次深入理解网络数据抓取技术的实践,涵盖了网络请求、HTML解析、数据存储等多个方面,有助于提升学生的编程技能和数据分析能力。

剩余11页未读,继续阅读

- 粉丝: 805

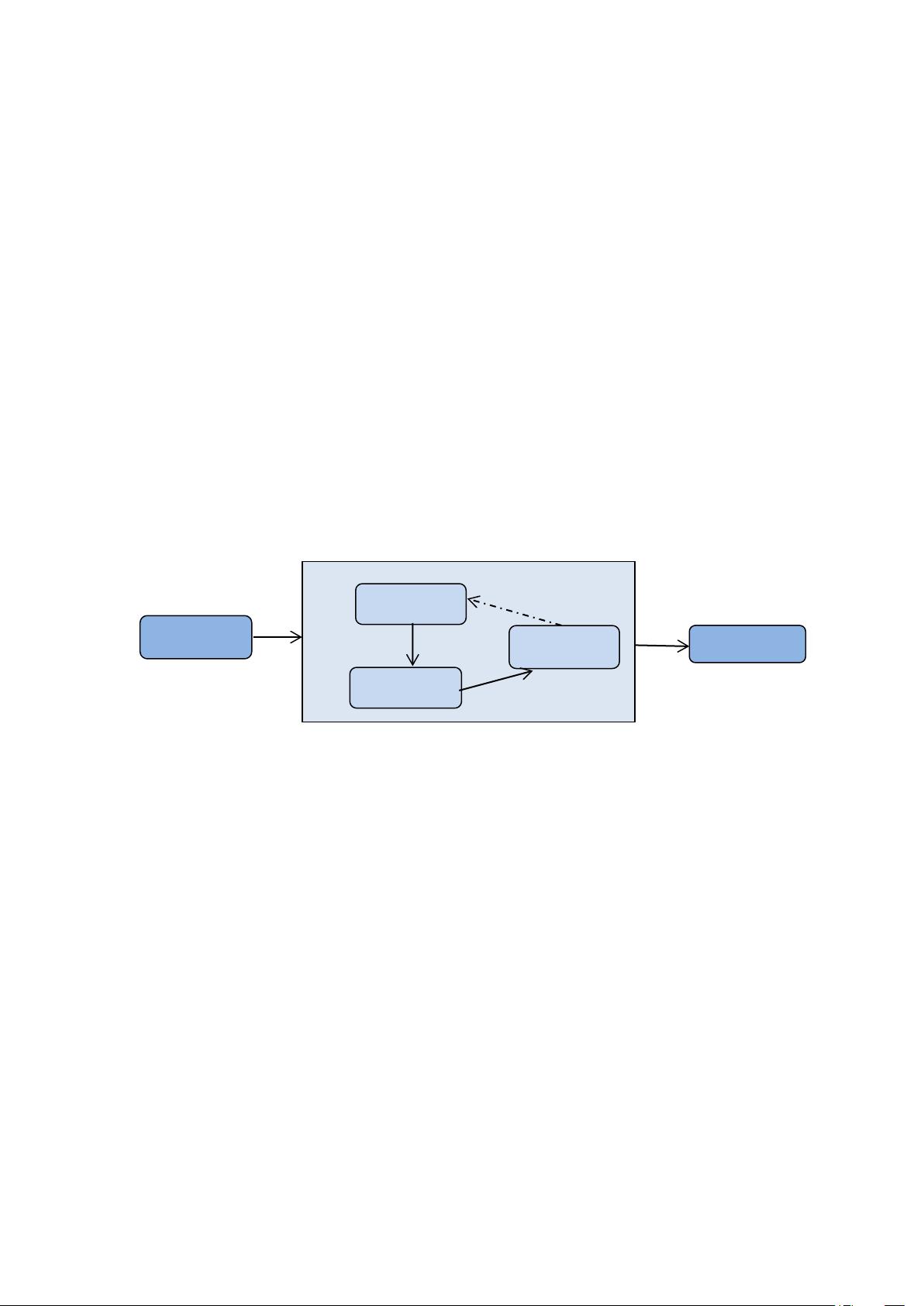

- 资源: 232

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- (178047214)基于springboot图书管理系统.zip

- 张郅奇 的Python学习过程

- (23775420)欧姆龙PLC CP1H-E CP1L-E CJ2M CP1E 以太网通讯.zip

- (174590622)计算机课程设计-IP数据包解析

- (175550824)泛海三江全系调试软件PCSet-All2.0.3 1

- (172742832)实验1 - LC并联谐振回路仿真实验报告1

- 网络搭建练习题.pkt

- 搜索引擎soler的相关介绍 从事搜索行业程序研发、人工智能、存储等技术人员和企业

- 搜索引擎lucen的相关介绍 从事搜索行业程序研发、人工智能、存储等技术人员和企业

- 基于opencv-dnn和一些超过330 FPS的npu

信息提交成功

信息提交成功