网络爬虫-实验手册.docx

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

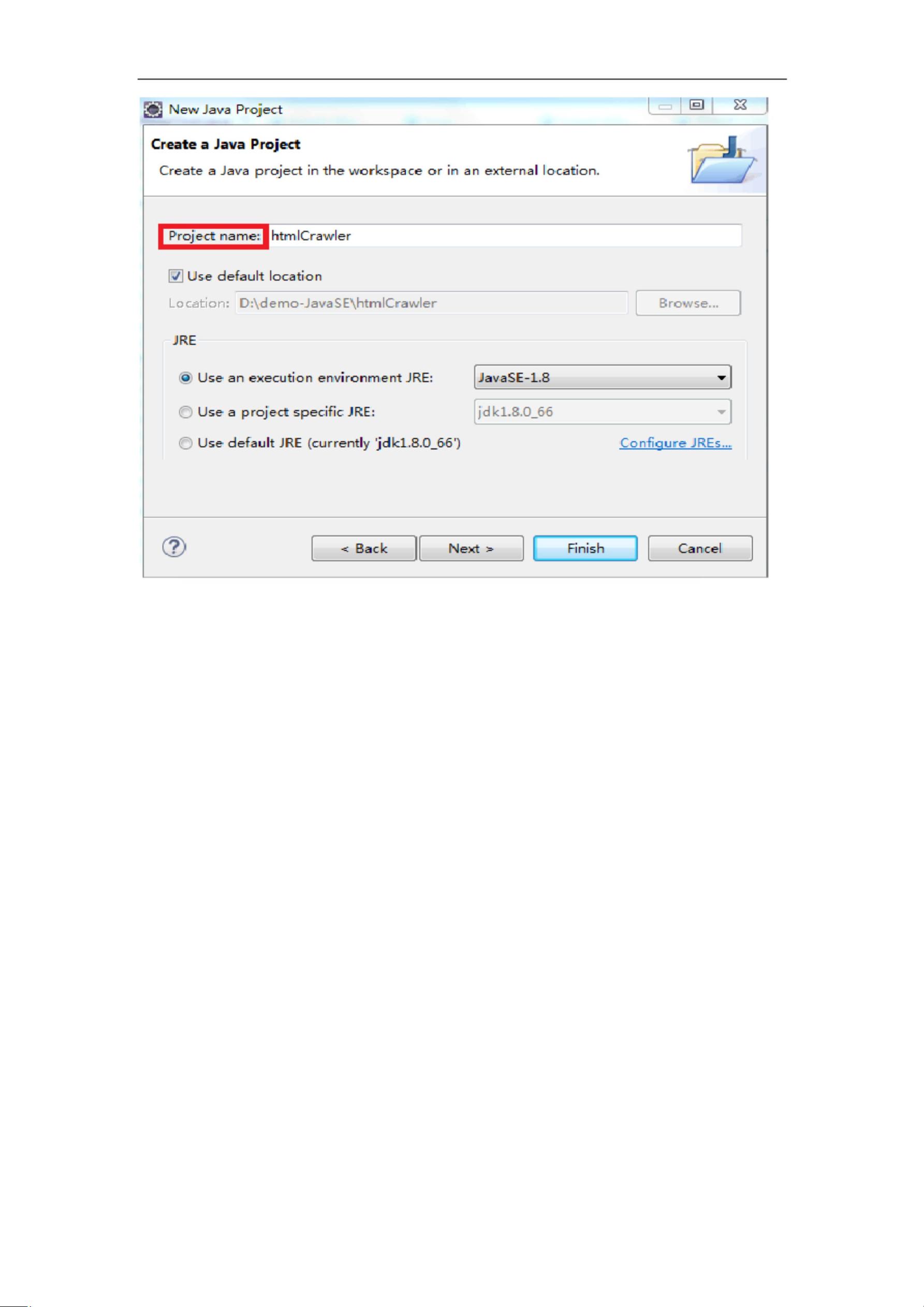

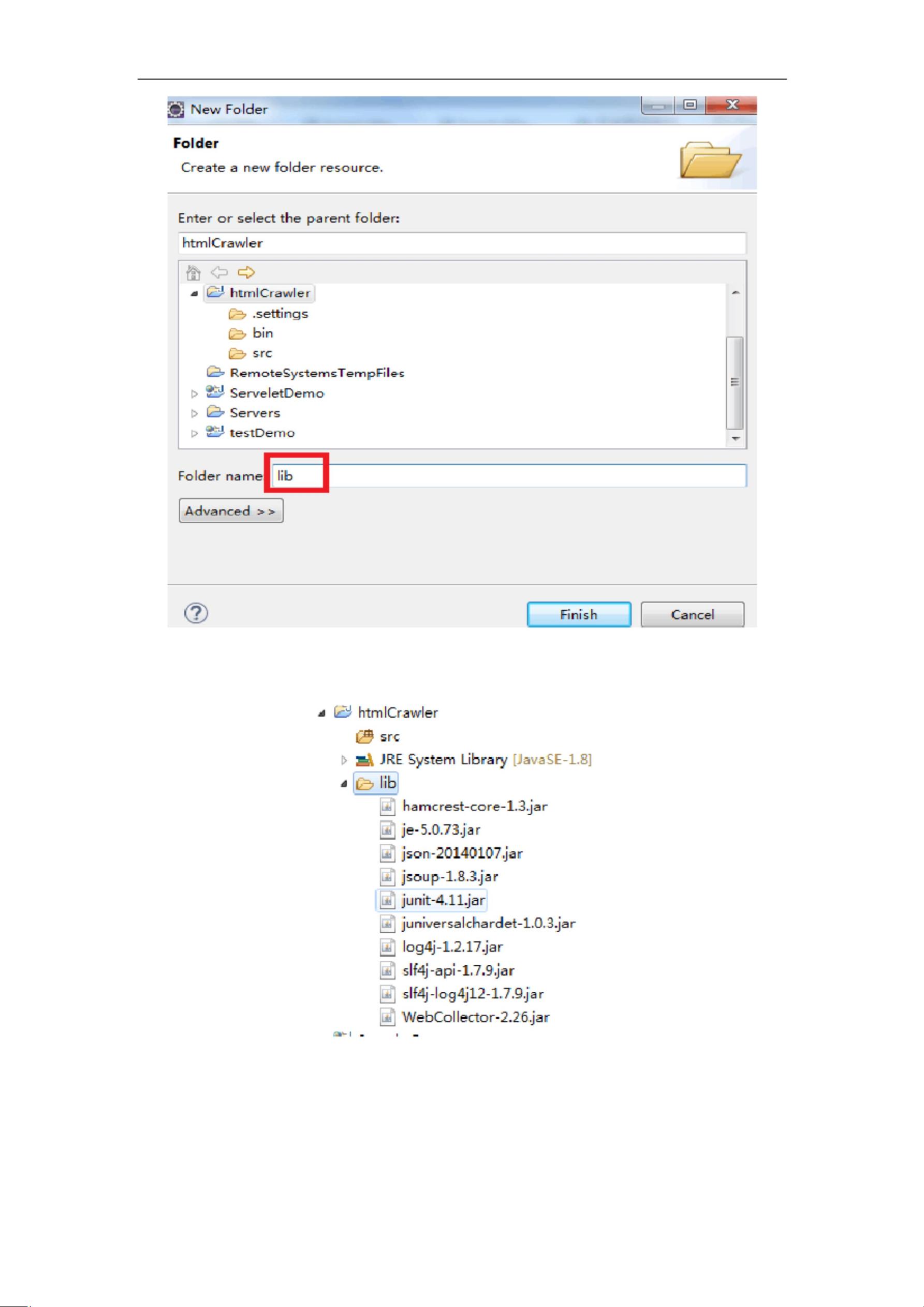

《网络爬虫实践指南——基于WebCollector框架》 网络爬虫是互联网信息挖掘的重要工具,它能够自动遍历网络上的页面,抓取所需信息。本篇文章将深入探讨网络爬虫的相关概念,介绍如何使用WebCollector框架在Eclipse环境中构建一个简单的聚焦网络爬虫。 了解网络爬虫的基础知识至关重要。网络爬虫,又称网页蜘蛛或网络机器人,是通过模拟浏览器行为,遵循HTTP协议,自动化地获取网页信息的程序。它们通常按照预设的规则(如深度优先或广度优先)遍历网页,并通过解析HTML内容来提取所需数据。 WebCollector是一个基于Java的开源网络爬虫框架,设计用于构建高效、可扩展的聚焦爬虫。其基本原理包括以下几个步骤:初始化配置、URL种子的设置、网页抓取、内容解析以及数据存储。WebCollector提供了丰富的API和插件支持,简化了网络爬虫的开发过程。 在Eclipse中配置并使用WebCollector,首先需要确保Java开发环境已正确安装和配置。接着,访问WebCollector官网下载所需的jar包,并将其放入新建项目的lib目录中。创建一个名为"htmlCrawler"的Java项目,然后在项目中创建一个新的Java类"Crawler",继承自BreadthCrawler。 在Crawler类中,我们需要重写visit方法。这个方法是爬虫的核心,它会在每个页面被访问时被调用,用于处理和解析网页内容。例如,以下代码片段展示了如何打印出正在访问的URL: ```java public class Crawler extends BreadthCrawler { public Crawler(String crawlPath, boolean autoParse) { super(crawlPath, autoParse); } @Override public void visit(Page page, CrawlDatums next) { try { System.out.println("正在提取:" + page.getUrl()); } catch (IOException e) { e.printStackTrace(); } } public static void main(String[] args) { Crawler crawler = new Crawler("html_crawler", true); crawler.start(1); // 启动爬虫,参数1表示深度 } } ``` 运行上述代码,WebCollector将开始爬取指定的URL(在本例中为"software.hebtu.edu"),并在控制台输出相关信息,包括正在访问的URL。 实验的扩展内容可能包括对更复杂聚焦爬虫的实现,比如增加URL过滤规则、处理JavaScript动态加载的内容、优化爬取速度、实现多线程爬取、以及将抓取的数据进行存储和分析等。这些高级特性能够帮助学生更好地理解和运用网络爬虫技术,解决实际问题。 掌握网络爬虫的原理与实践,不仅可以提升数据分析能力,也是从事大数据、搜索引擎等相关工作的重要技能。通过WebCollector这样的框架,开发者可以快速构建自己的网络爬虫系统,从而更高效地获取和利用网络上的信息资源。

剩余11页未读,继续阅读

- 粉丝: 1w+

- 资源: 5万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功