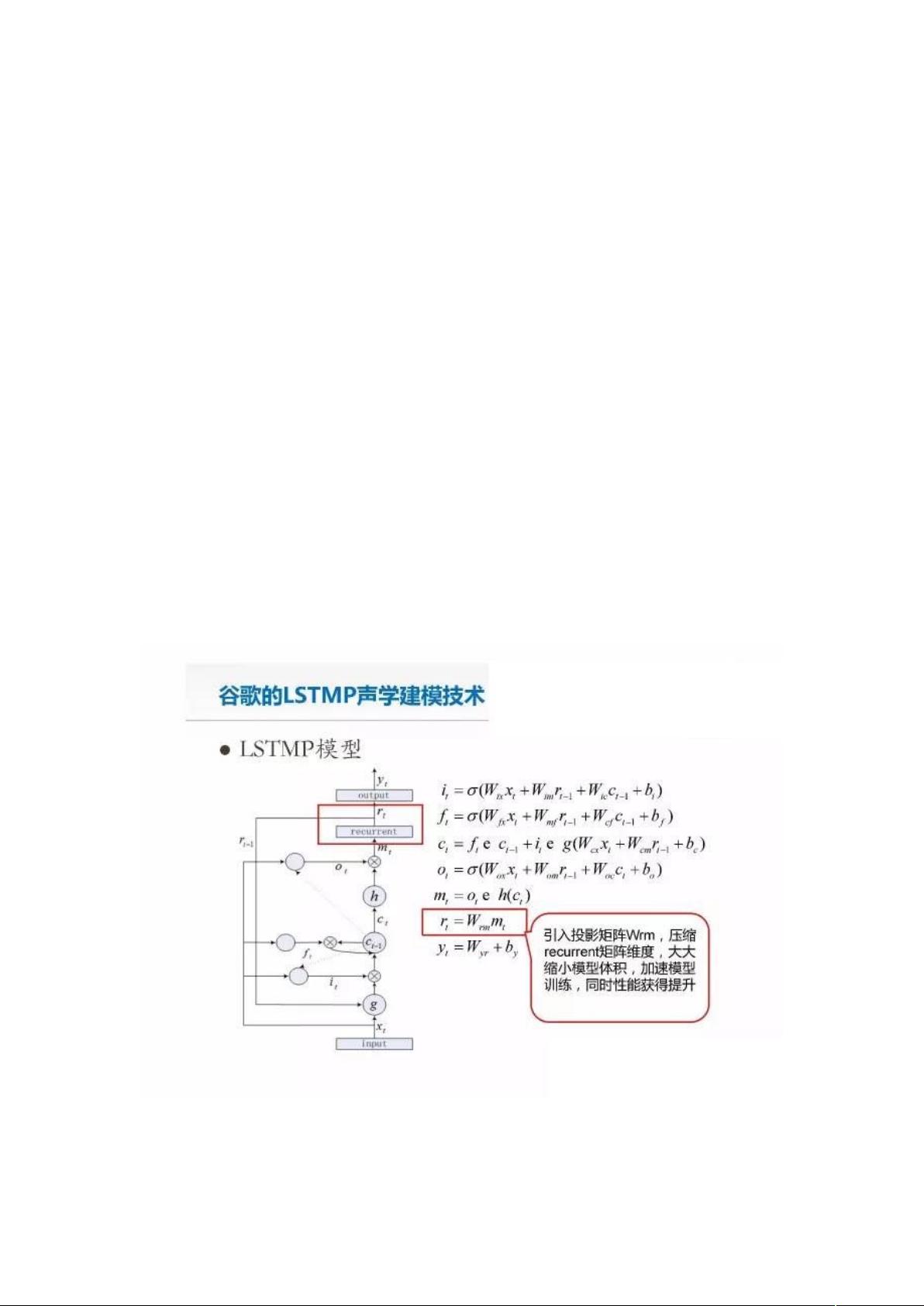

### 关于LSTM+CTC详解 #### 长短时记忆模型(LSTM)与条件随机场(CTC)的结合应用 ##### 引言 近年来,随着人工智能技术的飞速发展,尤其是深度学习技术的不断突破,语音识别领域的研究取得了显著进展。自2011年以来,深度学习被广泛应用于语音识别中,并逐步取代传统的方法成为主流技术之一。其中,长短时记忆模型(Long Short-Term Memory, LSTM)和条件随机场(Connectionist Temporal Classification, CTC)是两个关键的技术组成部分。 ##### 长短时记忆模型(LSTM) LSTM是一种特殊的循环神经网络(Recurrent Neural Network, RNN),旨在解决长期依赖性问题,即在序列数据中捕捉长时间跨度的信息。与传统RNN相比,LSTM通过引入“门”机制(输入门、输出门、遗忘门)来控制信息的流动,有效地克服了梯度消失和梯度爆炸的问题。 - **输入门(Input Gate)**: 控制当前时间步的信息是否加入到单元状态中。 - **输出门(Output Gate)**: 控制单元状态中的信息是否被输出到下一层。 - **遗忘门(Forget Gate)**: 决定保留多少前一时刻的状态信息。 这些门机制使得LSTM能够在长序列中保持信息的同时,选择性地遗忘无用的信息,这对于语音识别至关重要,因为它可以捕捉到语音信号中的长期依赖关系。 ##### LSTM+CTC结构 在实际应用中,将LSTM与CTC相结合可以进一步提高语音识别的准确率。CTC是一种用于端到端语音识别的有效方法,它能够直接从声学特征预测出字符序列,无需手动对齐。具体来说: - **CNN+7DNN+2LSTM结构**:该结构首先利用卷积神经网络(Convolutional Neural Network, CNN)提取音频信号的特征,接着通过多个全连接层(DNN)进行非线性变换,最后使用LSTM层捕捉时序信息。这种组合不仅能够有效提取特征,还能很好地建模语音信号的时间依赖性。 - **LSTMP与反馈层**:为了改善LSTM的训练稳定性并减少计算资源消耗,Google提出了LSTMP模型,该模型在LSTM的基础上增加了反馈层。反馈层的作用在于降低模型的整体计算复杂度,使得模型能够更加稳定高效地训练。特别是在处理大规模数据集时,反馈层的存在大大降低了计算负担,有助于实现更高效的训练过程。 - **BPTT算法**:Backpropagation Through Time (BPTT) 是训练循环神经网络的基本算法,它负责将误差反向传播回网络中的各个时间步。BPTT有两种主要形式:逐帧递推和所有误差同步向前传。前者是按顺序逐个时间步传播误差,后者则是将误差截断,只允许在固定的时间步范围内传播。这两种方法各有优劣,选择哪种取决于具体应用场景的需求。 ##### 实验对比 通过实验对比,可以发现不同结构在不同数据量下的表现差异。例如,当数据量较小(如2000小时)时,双层LSTM模型在性能上可能优于传统的CNN技术;然而,当数据量增大至10000小时或更多时,具有更深CNN层的结构(如10层CNN)则会显示出更好的性能。这是因为深度CNN能够更好地捕获语音信号中的复杂模式,而LSTM层则负责捕捉长期依赖关系,二者结合能够达到最佳的识别效果。 ##### 结论 LSTM+CTC是一种在语音识别领域极具潜力的技术组合。通过合理设计网络结构并采用先进的训练策略,可以在实际应用中实现高性能的语音识别系统。随着深度学习技术的不断发展和完善,相信LSTM+CTC在未来还将继续发挥重要作用,并为推动语音识别技术的进步做出更大的贡献。

剩余37页未读,继续阅读

- 粉丝: 18

- 资源: 2

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 人物检测26-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- 人和箱子检测2-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- 清华大学2022年秋季学期 高等数值分析课程报告

- GEE错误集-Cannot add an object of type <Element> to the map. Might be fixable with an explicit .pdf

- 清华大学2022年秋季学期 高等数值分析课程报告

- 矩阵与线程的对应关系图

- 人体人员检测46-YOLO(v5至v9)、COCO、Darknet、TFRecord数据集合集.rar

- GEMM优化代码实现1

- java实现的堆排序 含代码说明和示例.docx

- 资料阅读器(先下载解压) 5.0.zip

信息提交成功

信息提交成功