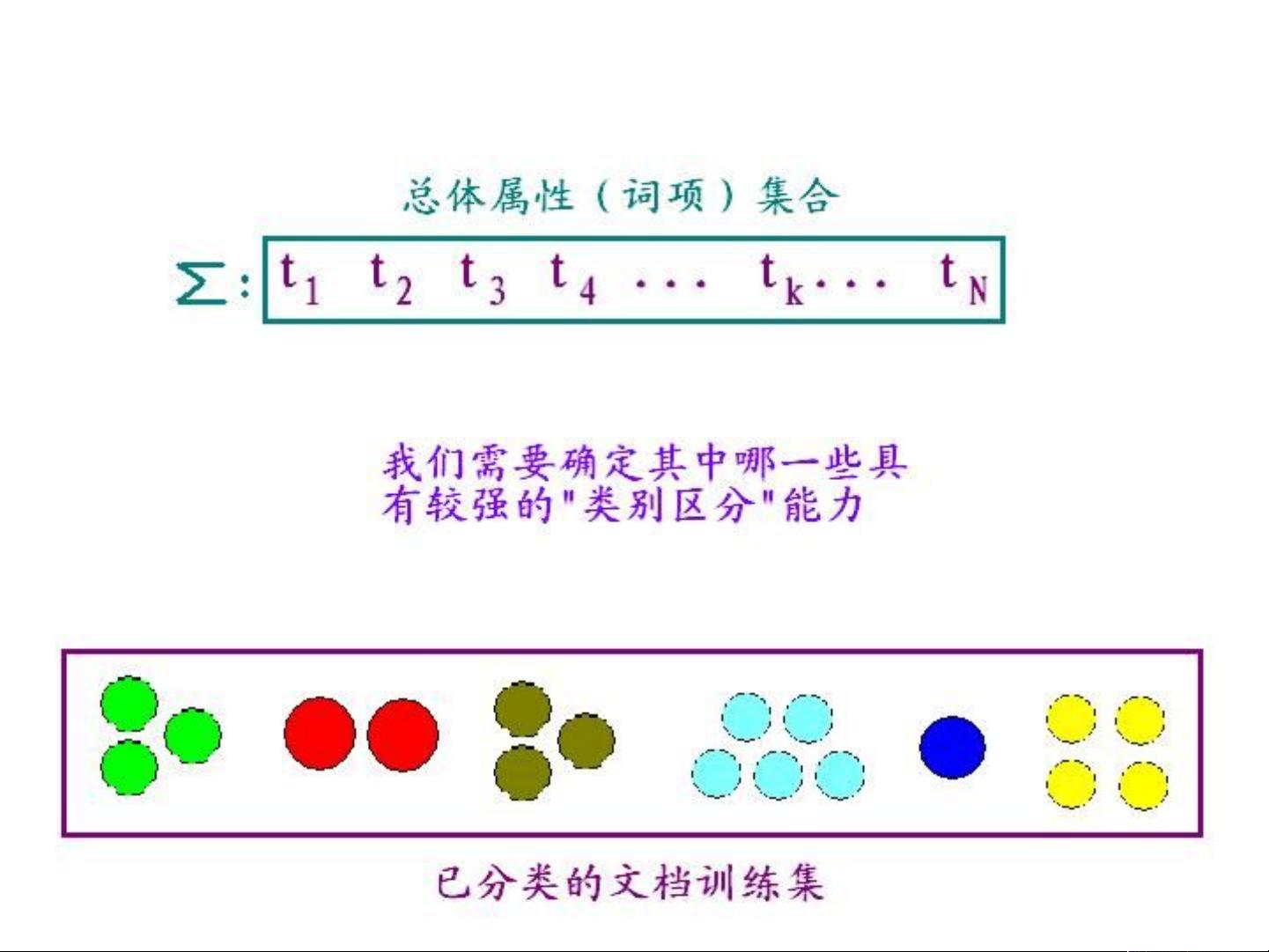

文本分类是自然语言处理领域的重要任务,其目标是根据文本内容将其分配到预定义的类别中。特征提取是文本分类的核心环节,它涉及到如何将原始的文本数据转换为可供机器学习算法使用的数值特征。以下是对特征提取过程的详细阐述: 特征选取是降低数据维度、解决数据稀疏性问题的关键步骤。在文本数据中,由于词汇数量巨大但每个文档仅包含其中一小部分,导致文档向量表示通常是稀疏的。理论上,我们可以基于统计学习理论,假设文档的形成是随机过程的结果,通过大量样本获取词项的分布参数,进而设计文本分析方法。然而,实际中由于训练集大小有限,往往无法直接获取联合概率分布,因此会退而求其次考虑词项的边际概率分布。 过度拟合(Over-fitting problem)是特征选取时需要避免的问题。如果模型在训练集上的表现过于优秀,但在未见过的文档上表现较差,就可能存在过度拟合。理想的模型应该在训练集和未知文档上表现一致。为了防止过度拟合并提高分类准确性,通常需要筛选参与相似性计算的词项,通过降低特征维度来减少计算时间和空间消耗。 特征选取的方法大致分为两类:过滤(filter)和包装(wrapper)。过滤方法独立于学习过程,预先评估每个特征的重要性,如删除停用词和过于频繁或罕见的词项。包装方法则是在学习过程中逐步调整特征集合,以优化分类性能。这两种方法可以结合局部和全局视角,以及词项选择和词项提取的概念来进行。 局部特征选取针对每个类别独立进行,而全局特征选取则考虑所有类别的整体。词项选择侧重于挑选已有的特征,而词项提取则可能涉及到基于训练集和其他知识生成新的特征组合。特征的纳入(inclusion)策略是保留重要的词项,而排除(exclusion)策略则是去除不重要的词项。 贪婪包含算法是一种常用的特征选择策略,它通过计算每个词项的区分度(如互信息、卡方检验等),然后按降序排列并逐步选取前若干个特征。这种方法虽然简单且效率高,但可能会错过一些在更复杂特征组合中才有价值的词项。 在实际应用中,特征提取还会结合文本预处理步骤,如词干化、词形还原和去除噪声词汇。此外,词袋模型(bag-of-words)常被用来表示文本,它忽略了词序但保留了词频信息。TF-IDF(词频-逆文档频率)是一种常用的权重计算方法,用于衡量词项在文档中的重要性。 特征提取还包括使用降维技术,如主成分分析(PCA)、奇异值分解(SVD)或基于核的方法(如LDA主题模型、Word2Vec词嵌入),这些方法可以将高维稀疏特征空间映射到低维连续空间,进一步改善模型的泛化能力和计算效率。 文本分类的特征提取是一个涉及统计学习、信息检索和机器学习的多方面过程,旨在找出对分类最有贡献的特征子集,以实现高效且准确的文本分类。

剩余29页未读,继续阅读

zzz866900932013-07-03内容简洁,不过还可以

zzz866900932013-07-03内容简洁,不过还可以

- 粉丝: 6

- 资源: 13

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功