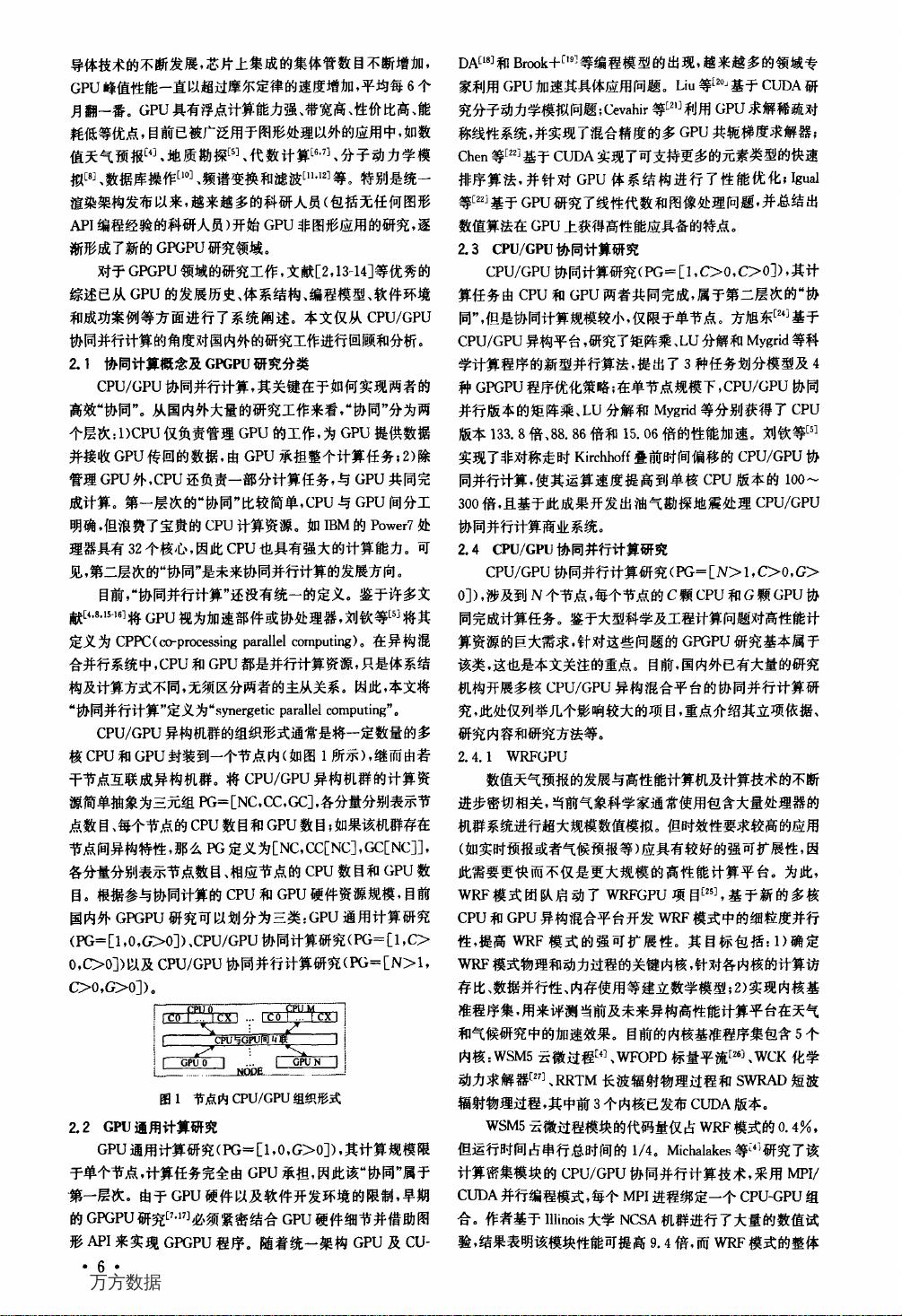

### CPU/GPU协同并行计算研究综述 #### 引言与背景 随着高性能计算技术的飞速发展,异构混合架构,特别是结合了通用中央处理器(CPU)和图形处理器(GPU)的体系结构,成为了构建下一代超级计算平台的关键。这种架构凭借其强大的计算能力、优异的性价比以及相对较低的能源消耗,吸引了业界和学术界的广泛关注。然而,其复杂的设计也带来了并行计算算法设计上的新挑战。CPU/GPU协同并行计算作为一个新兴的研究领域,不仅关注如何充分利用这两种计算资源的特点,还探索如何通过优化算法和软件设计来提高整体系统的性能和效率。 #### CPU与GPU的特性对比 CPU和GPU在设计上有着本质的不同。CPU通常被设计成通用处理器,能够高效执行各种类型的任务,尤其是在处理复杂的控制流和缓存管理方面表现出色。相比之下,GPU最初是为了加速图形渲染任务而设计的,因此在并行计算和大量数据处理方面拥有天然的优势。GPU的核心是大量的简单计算单元,能够同时处理多个线程,这使得它们在处理高计算强度的应用(如科学计算、深度学习和大数据分析)时展现出卓越的性能。 #### CPU/GPU协同并行计算研究现状 近年来,随着GPU在通用计算领域应用的日益广泛,CPU/GPU协同并行计算研究逐渐成为一个热点话题。根据计算资源的规模,这一领域的研究可以大致分为三类: 1. **单节点内CPU与GPU协同**:这一场景主要关注如何在单一计算节点内优化CPU和GPU之间的数据传输和计算负载分配,以实现最佳的并行效率。例如,通过智能调度策略和优化的内存管理技术,确保GPU在执行计算密集型任务时不会因等待数据传输而闲置。 2. **多节点CPU/GPU集群**:在大规模并行计算环境中,如何有效地管理和调度跨节点的CPU和GPU资源变得至关重要。这包括开发新的通信协议、数据分布策略和负载均衡算法,以最大化整个集群的计算能力和效率。 3. **异构云环境下的协同计算**:随着云计算的普及,异构计算资源的动态分配和管理也成为了研究的重点。在这样的环境下,CPU/GPU协同并行计算不仅要考虑计算资源的高效利用,还要解决资源分配、弹性伸缩和安全隔离等问题。 #### 研究项目与案例 多个研究项目和实验已经展示了CPU/GPU协同并行计算的潜力和挑战。例如,“NVIDIA CUDA”和“AMD ROCm”等框架提供了丰富的编程模型和工具,帮助开发者更轻松地利用GPU的强大并行计算能力。此外,诸如“OpenACC”和“OpenMP”等标准接口的出现,也在一定程度上简化了异构编程的复杂性,促进了CPU/GPU协同并行计算的广泛应用。 #### 未来研究方向 尽管CPU/GPU协同并行计算取得了显著进展,但仍有许多未解的问题和潜在的研究方向: 1. **算法优化与自适应**:如何自动识别和优化不同计算模式下的算法,使其能够在CPU和GPU之间无缝切换,是未来研究的一个关键点。 2. **硬件协同设计**:随着摩尔定律的放缓,未来的高性能计算系统可能需要更加紧密的CPU和GPU协同设计,以实现更高的能效比和计算密度。 3. **软件栈与生态系统**:构建一个完整且易于使用的软件栈,支持跨平台、跨语言的异构编程,将是推动CPU/GPU协同并行计算发展的另一个重要因素。 4. **大规模并行计算的可扩展性**:在超大规模集群环境下,如何保持CPU/GPU协同并行计算的效率和可扩展性,仍需深入探索。 CPU/GPU协同并行计算的研究是一个充满机遇和挑战的领域。通过持续的技术创新和跨学科合作,有望在未来几年内看到这一领域取得更多突破性进展,为高性能计算和大数据分析带来革命性的变化。

剩余8页未读,继续阅读

- 粉丝: 0

- 资源: 8

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 6吨级轻型载货汽车驱动桥的设计及虚拟装配 (1)

- Springboot 学生管理系统更删改查

- 九缸星形发动机点火器3D

- 毕业设计-宿舍管理系统设计与实现

- 全面详解Ruby编程语言,从入门到高级实战

- CC2530无线zigbee裸机代码实现红外遥控器接收IRDecod、串口打印UART、12864液晶屏显示例程.zip

- 跨平台的云端爬虫系统项目全套技术资料.zip

- CC2530无线zigbee裸机代码实现红外遥控发送、串口打印、LCD12864液晶屏、按键程序.zip

- Delphi编程语言从基础知识到高级应用全面指南

- Scratch图形化编程语言入门与进阶指南

- 酒店后台管理系统项目全套技术资料.zip

- CC2530无线zigbee裸机代码实现RS485串口通讯.zip

- Day-03 Vue222222222222222222222

- Visual Basic语言入门与进阶教程

- 数据安全治理白皮书6.0-2024年最新版

- 基于pygame的圣诞小游戏

信息提交成功

信息提交成功