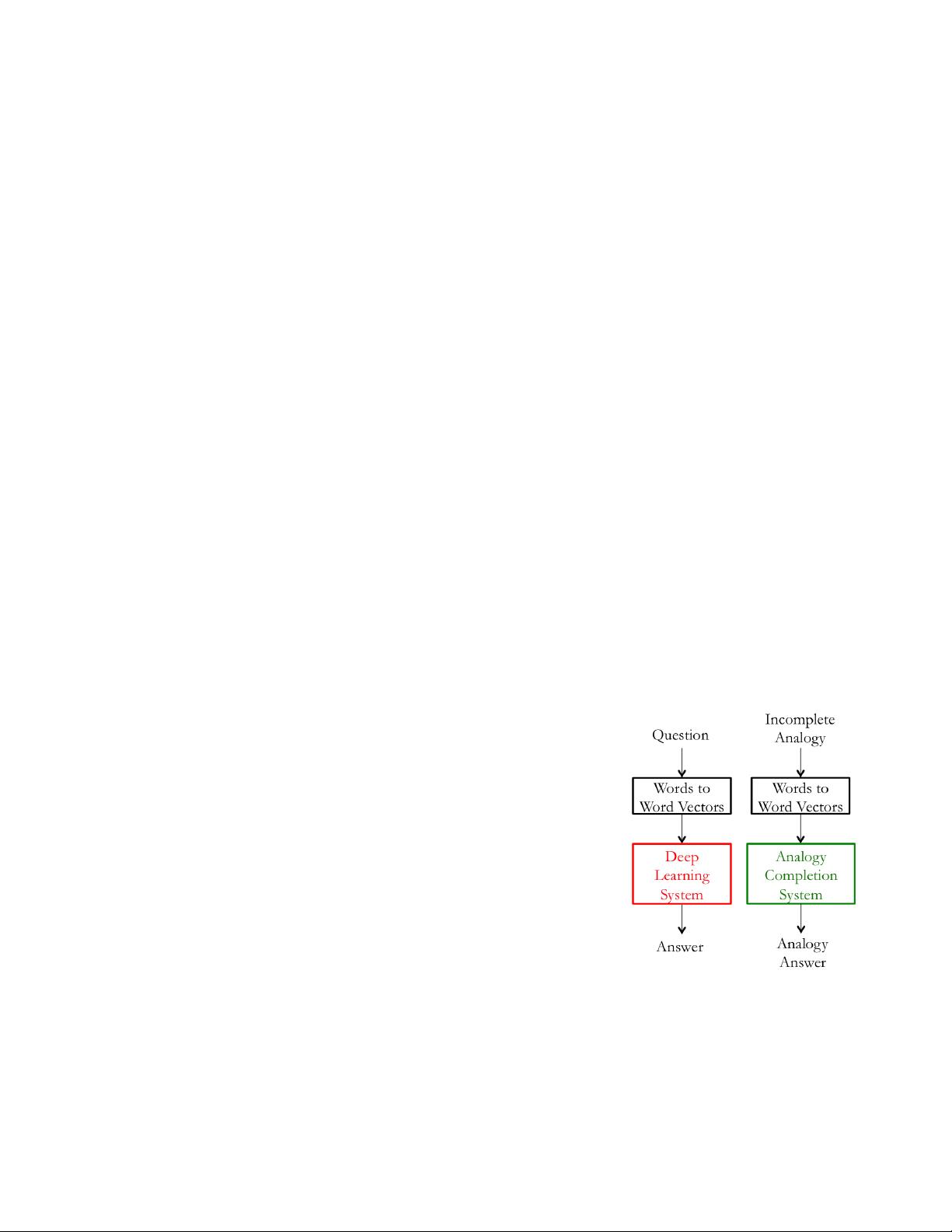

根据提供的文件信息,以下是关于“LectureNote2 for cs224d Lec3”的详细知识点概述: 标题中提到的“cs224d Lec3”指的是斯坦福大学一门非常著名的自然语言处理(Natural Language Processing,简称NLP)课程,课程编号为cs224d,该课程由Richard Socher主讲。该课程内容主要集中在深度学习技术在NLP领域的应用,Lec3是课程的第三个讲座,具体对应“LectureNote2”。 描述中提到的“Note for Socher's deep learning for NLP,斯坦福cs224d”进一步强调了这份讲义的来源和主题。Richard Socher教授是深度学习和自然语言处理领域的知名学者,cs224d课程是他在这两个领域的研究成果和教学经验的集大成者。 在标签“deep learning NLP cs224d”中,所指的知识点十分明确:深度学习(deep learning)是一种让计算机模拟人脑处理信息的方法,是机器学习的一个分支;自然语言处理(NLP)则是计算机科学、人工智能和语言学领域的一个交叉学科,旨在研究计算机与人类语言之间的交互;而cs224d是特定课程的代号,代表了深度学习与NLP相结合的前沿课程内容。 在提供的部分内容中,我们可以看到一系列关于词向量(word vectors)或者称为词嵌入(word embeddings)的讨论,这是NLP领域用于表示词汇意义的技术。这部分内容扩展了词向量的讨论,涵盖了如何通过内蕴评价(intrinsic evaluation)和外在评价(extrinsic evaluation)两种方法来评估词向量的质量。内蕴评价是指对由某种嵌入技术生成的一组词向量,在特定的中间子任务(如词形类比)上进行评价,这类子任务通常计算简单、速度快,便于我们了解词向量生成系统。外在评价则是基于词向量完成具体的外在任务,如机器翻译、情感分析等,它们与真实世界的应用场景紧密相关。 在讨论中,还提到了超参数(hyper-parameters)对类比评价任务(analog evaluation tasks)效果的影响,以及人类判断与词向量距离的相关性。此外,还探讨了如何处理词汇中的歧义问题,以及上下文(context)在使用窗口分类(window classification)时的作用。 讲义还提到了Word2Vec和GloVe这两种流行的词向量训练方法,它们能够在语义空间中发现自然语言词汇的潜在向量表示。Word2Vec是一种通过上下文预测目标词或者根据目标词预测上下文来训练词向量的方法。GloVe则是一种基于全局矩阵分解的技术,通过统计词汇共现信息来学习词向量。 在深度学习模型方面,讲义还提到了人工神经网络(Artificial Neural Networks,简称ANNs)作为自然语言处理任务的一个模型类别。人工神经网络是一种由大量简单单元(神经元)广泛互联而成的计算模型,它在学习和模拟人脑处理信息方面具有优势。 讲义还提到了一种简化训练过程的动机,即通过使用更为简单的子系统来修改训练成本高的系统,以减少成本和提高效率。 这份讲义涉及了深度学习在自然语言处理中的应用、词向量的评价方法、以及机器学习模型在NLP中的训练和优化。这些都是深度学习和NLP领域的重要知识点,对于相关专业的学习者和研究者来说,这些内容都是极为宝贵的资源。

剩余10页未读,继续阅读

- 粉丝: 70

- 资源: 6

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- VMware-Workstation-17.6.2-24409262.x86-64.bundle.tar

- 基于ssm的莲湖小区疫情物资管理系统源码(java毕业设计完整源码).zip

- Screenshot_20241230_124309_com.tencent.tmgp.pubgmhd.jpg

- 不同颜色球体检测10-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- ABB机器人二次开发 C#读取和写入数据,可以获取点位信息及写入点位信息 自己写的ABB机器人类,机器人常规操作功能都有,非常适合进行二次开发

- 基于ssm的面向社区健康服务的医疗平台源码(java毕业设计完整源码+LW).zip

- 基于ssm的明星周边在线购物商城源码(java毕业设计完整源码).zip

- VMware-Workstation-16.2.5-20904516.x86-64.bundle.tar

- 新能源汽车车载双向OBC,PFC,LLC,V2G 双向 充电桩 电动汽车 车载充电机 充放电机 MATLAB仿真模型 : (1)基于V2G技术的双向AC DC、DC DC充放电机MATLAB仿真模型

- 基于ssm的农产品销售系统源码(java毕业设计完整源码+LW).zip

- 固高GTS运动控制卡,C#语言三轴点胶机样本程序源代码,使用 的是固高GTS-800 8轴运动控制卡 资料齐全,3轴点胶机样本程序,还有操作手册及各种C#事例程序,适合自己参照做二次开发,GTS-4

- VMware-Workstation-15.5.7-17171714.x86-64.bundle.tar

- 一种手机电池粘胶机sw18可编辑全套技术资料100%好用.zip

- 基于Python控制台的二手房预测可视化分析

- 高校教材订购系统的数据库设计方案和技术实现要点

- 光伏并网逆变器资料,包含原理图,pcb,源码以及元器件明细表 如下: 1) 功率接口板原理图和pcb,元器件明细表 2) 主控DSP板原理图(pdf);如果有需要,可发mentor版本的原

信息提交成功

信息提交成功