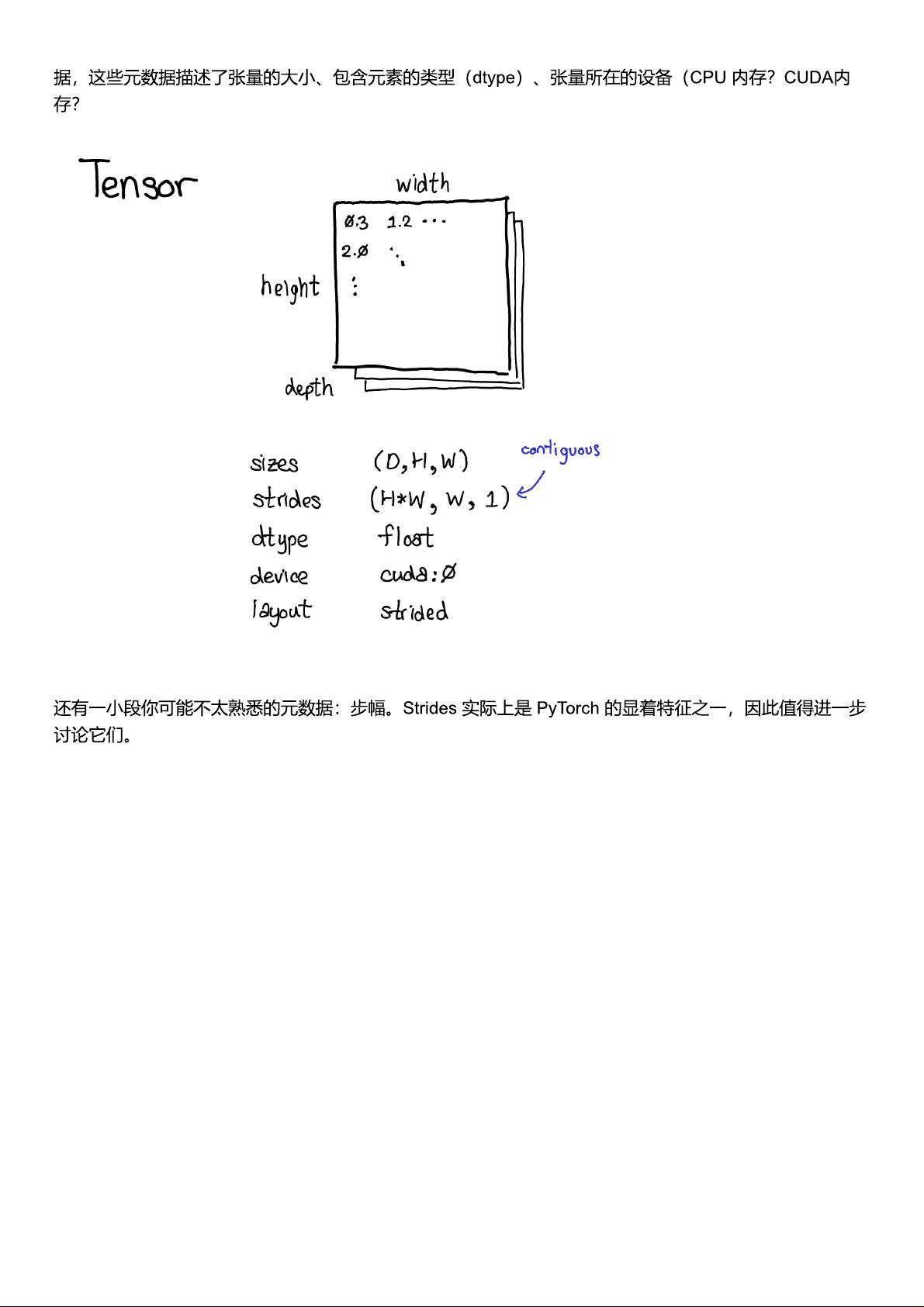

【PyTorch内部结构解析】 PyTorch是一个广泛使用的开源深度学习框架,它以其灵活性、易用性和高效性而受到广大研究者和开发者的青睐。本文将深入探讨PyTorch的内部结构,帮助读者理解其核心组件以及如何利用这些组件进行深度学习模型的构建和训练。 1. **动态计算图(Dynamic Computational Graph)** PyTorch的核心特性之一是其动态计算图,这使得它在处理复杂的模型和动态控制流时表现出色。与静态计算图相比,动态计算图允许在运行时构建和修改计算图,便于调试和实验。 2. **张量(Tensor)** 在PyTorch中,张量是基本的数据结构,用于存储和操作数值数据。张量可以进行各种数学运算,包括加法、乘法、卷积等。它们也可以在CPU和GPU之间无缝移动,以加速计算。 3. **自动梯度(Automatic Gradient)** PyTorch提供了自动梯度机制,即autograd,用于计算模型参数的梯度,这是反向传播算法的基础。每个张量都有一个`.requires_grad`属性,当设置为True时,PyTorch会跟踪对该张量的操作以计算梯度。 4. **模块(Module)** PyTorch中的`nn.Module`是构建神经网络的基本构造块。用户可以通过继承`nn.Module`并定义前向传播函数来创建自定义层或整个网络。这些模块可以堆叠在一起,形成复杂的网络架构。 5. **优化器(Optimizer)** PyTorch提供了一系列优化器,如SGD(随机梯度下降)、Adam、Adagrad等,用于更新模型参数。优化器负责根据损失函数的梯度来调整权重,以最小化损失并优化模型性能。 6. **损失函数(Loss Function)** PyTorch库中包含了多种损失函数,如均方误差(MSE)、交叉熵损失(CrossEntropyLoss)等,这些函数用于量化模型预测与真实值之间的差异,驱动模型学习。 7. **数据加载器(Data Loader)** PyTorch的`DataLoader`类用于处理数据集,它可以对数据进行预处理、批处理和并行加载,以便于模型训练。配合`Dataset`类,用户可以轻松定义自己的数据集格式。 8. **分布式训练(Distributed Training)** 对于大规模数据和模型,PyTorch支持多GPU和分布式训练,通过`torch.distributed`模块,可以在多个设备或机器上并行训练模型,提高训练速度。 9. **模型保存与加载(Model Saving & Loading)** 使用`torch.save`和`torch.load`函数,可以将训练好的模型权重和状态持久化,以便后续复用或在不同环境中加载。 10. **TensorBoard集成(TensorBoard Integration)** PyTorch通过`torch.utils.tensorboard`库支持TensorBoard可视化,帮助开发者监控训练过程中的损失、准确率等指标,以及模型的中间激活图。 理解PyTorch的这些关键概念和组件对于有效利用PyTorch进行深度学习至关重要。无论是在毕业设计还是更复杂的项目中,掌握PyTorch的内部运作原理都能极大地提升开发效率和模型性能。

剩余36页未读,继续阅读

- 粉丝: 7035

- 资源: 1706

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 基于flink的实时数仓详细文档+全部资料.zip

- 基于Flink的数据同步工具详细文档+全部资料.zip

- 基于Flink的数据流业务处理平台详细文档+全部资料.zip

- 基于flink的物流业务数据实时数仓建设详细文档+全部资料.zip

- 外卖时间数据,食品配送时间数据集,外卖影响因素数据集(千条数据)

- 基于flink的异构数据源同步详细文档+全部资料.zip

- 基于flink的营销系统详细文档+全部资料.zip

- 基于Flink对用户行为数据的实时分析详细文档+全部资料.zip

- 基于Flink分析用户行为详细文档+全部资料.zip

- 基于flink可以创建物理表的catalog详细文档+全部资料.zip

- 基于Flink流批一体数据处理快速集成开发框架、快速构建基于Java的Flink流批一体应用程序,实现异构数据库实时同步和ETL,还可以让Flink SQL变得

- 太和-圣德西实施—部门负责人以上宣贯培训大纲.doc

- 太和-圣德西实施—部门负责人非HR的HRM培训.pptx

- 太和-圣德西实施—宣贯培训大纲.docx

- 基于Flink流处理的动态实时亿级全端用户画像系统可视化界面详细文档+全部资料.zip

- 基于Flink全端用户画像商品推荐系统详细文档+全部资料.zip

信息提交成功

信息提交成功