sparse_Autoencoder

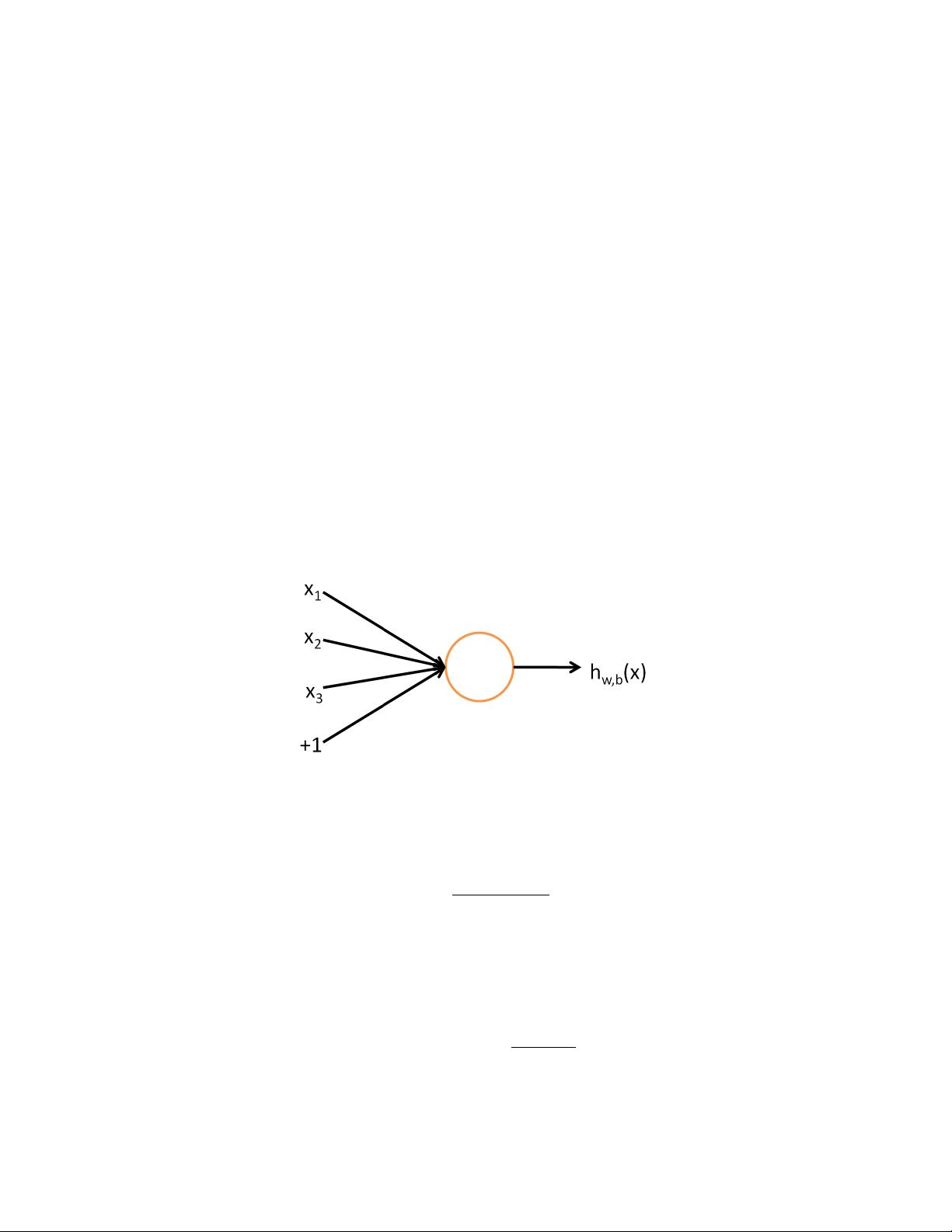

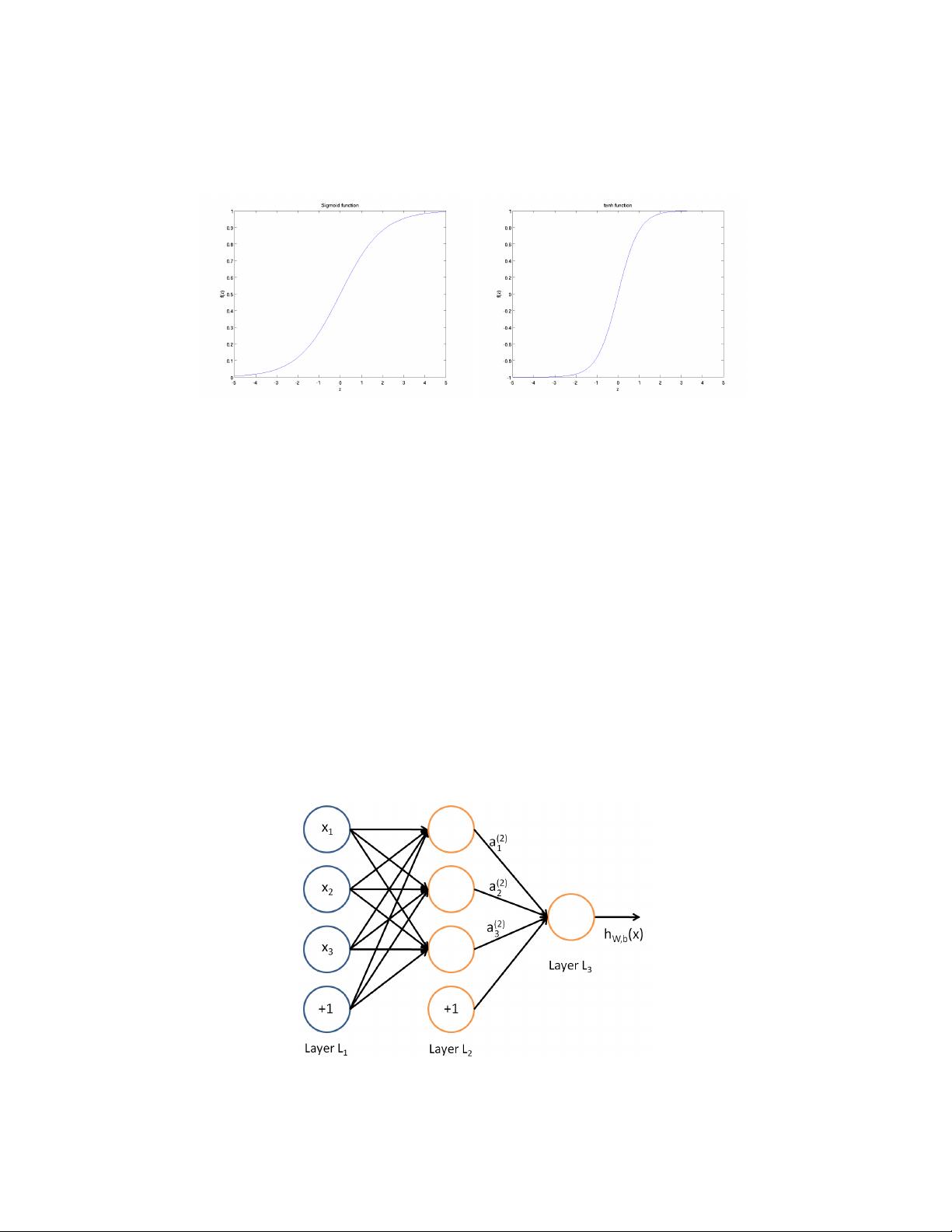

### Sparse Autoencoder:一种自动学习特征的非监督学习方法 #### 一、引言与背景 在《Sparse Autoencoder》这份由Andrew Ng撰写的讲义中,主要探讨了一种能够从无标签数据中自动学习特征表示的方法——稀疏自编码器(Sparse Autoencoder)。在介绍稀疏自编码器之前,我们首先需要了解自编码器的基本概念及其在机器学习中的应用背景。 监督学习是人工智能领域最强大的工具之一,它已经成功应用于自动识别邮政编码、语音识别、自动驾驶汽车以及人类基因组的理解等领域。尽管取得了显著的成功,但监督学习仍然存在一定的局限性。具体来说,在大多数情况下,监督学习的应用仍然需要手动指定输入特征,这通常需要研究人员投入大量的时间和精力来手工设计这些特征,尤其是在计算机视觉、音频处理和自然语言处理等复杂领域。 面对这一挑战,研究者们开始探索能否开发出更高效的算法来自动学习这些特征表示,而不是依赖于人工手动设计。稀疏自编码器正是这样一种算法,它可以自动地从无标签的数据中学习到有用的特征表示。 #### 二、神经网络基础 为了更好地理解稀疏自编码器的工作原理,我们需要先简要回顾一下神经网络的基础知识。神经网络是一种模拟人脑神经元结构的计算模型,通过连接多层非线性处理单元(即神经元)来完成复杂的模式识别任务。在监督学习中,神经网络可以用来分类或回归任务,其中输入数据经过一系列权重调整后的线性和非线性变换,最终得到预测结果。 #### 三、自编码器简介 自编码器是一种无监督学习模型,其目标是通过压缩再解压的方式,将原始数据重构出来,从而学习到数据的内在结构和有用的特征表示。一个典型的自编码器包含两个部分:编码器和解码器。编码器负责将输入数据压缩成一个低维的特征表示,而解码器则尝试根据这个低维表示重构出原始数据。 #### 四、稀疏自编码器 稀疏自编码器是在自编码器的基础上引入了稀疏约束,使得编码器输出的特征表示更加稀疏(即大部分元素接近于零)。这种稀疏性有助于学习到数据中更为重要的特征,并减少冗余信息。具体来说,稀疏自编码器在训练过程中会添加一个额外的惩罚项来鼓励隐藏层节点的激活值接近于零或者非常小。 #### 五、稀疏自编码器的学习过程 稀疏自编码器的学习过程主要包括以下几个步骤: 1. **初始化**:随机初始化自编码器的权重参数。 2. **前向传播**:将输入数据通过编码器进行压缩,并通过解码器进行重构。 3. **计算误差**:比较重构数据与原始数据之间的差异,并计算总误差(包括重构误差和稀疏性惩罚项)。 4. **反向传播**:利用反向传播算法更新权重参数,使误差最小化。 5. **迭代优化**:重复执行前向传播、计算误差和反向传播的过程,直到达到预定的迭代次数或误差收敛为止。 #### 六、稀疏自编码器的应用 稀疏自编码器虽然在某些领域如计算机视觉方面不如最好的手工设计特征那样有效,但它学习到的特征表示对于多种问题(包括音频、文本等)都是有用的。此外,稀疏自编码器还有更高级的变体,这些变体的表现令人惊讶,甚至超过了最佳的手工设计特征。 #### 七、总结 稀疏自编码器作为一种自动学习特征表示的方法,在机器学习领域具有重要意义。通过对原始数据进行自动特征提取,稀疏自编码器不仅减少了对人工特征工程的依赖,还能够发现数据中的潜在结构和规律。尽管目前在某些特定领域它可能不是最优的选择,但在其他领域,尤其是当数据量大且复杂时,稀疏自编码器仍展现出强大的潜力和价值。随着技术的发展,未来稀疏自编码器可能会有更广泛的应用场景和技术改进。

剩余18页未读,继续阅读

wml7601254532017-12-05还不错,学习了,谢谢。。。

wml7601254532017-12-05还不错,学习了,谢谢。。。

- 粉丝: 0

- 资源: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 基于PLC的全自动洗衣机控制系统设计:硬件与软件的完美结合方案,基于PLC的全自动洗衣机控制系统设计详解含硬件和软件设计章节一套完整方案,基于PLC全自动洗衣机控制系统设计 含Word文档一整套 前

- 基于COMSOL的结晶凝固过程仿真:考虑温度场、浓度场、相变及物质偏析的全方位分析,COMSOL仿真模拟结晶过程:涵盖温度场、浓度场、相变及物质偏析等多元因素研究,comsol 仿真结晶,凝固,考虑温

- stm32 OLED显示模块 寄存器方式代码

- 基于Matlab的迁移学习技术用于滚动轴承故障诊断,振动信号转图像处理并高精度分类,基于Matlab的迁移学习滚动轴承故障诊断系统:高准确率,简易操作,Matlab 基于迁移学习的滚动轴承故障诊断 1

- 双缸水平蒸汽机3D 双缸水平蒸汽机

- 基于XAFS数据处理的拟合算法及小波变换应用研究,基于XAFS数据处理的拟合算法及小波变换应用研究,xafs数据处理,拟合,小波变 ,xafs数据处理; 拟合; 小波变换,Xafs数据处理与拟合的小波

- 无线通信Mimo系统中STBC空时编码与MRC最大比合并的性能比较研究(基于Matlab 2016b版本),无线通信MIMO系统中的STBC空时编码与MRC最大比合并技术性能研究,基于Matlab 2

- 基于Python的Django-vue基于Spark的国漫推荐系统实现源码-说明文档-演示视频.zip

- C#实现多协议数据传输:OPC与DCS无DCOM配置读取及高效数据转发方案,C#实现无需DCOM配置的OPC与DCS数据传输:通过Socket转发至其他电脑或MODBUS/UDP协议实现高效数据读取与

- C语言基础入门学习笔记大纲.pdf

- 回溯组合问题_202503061306_54460.hinote

- 火狐判断安装_64位版本 (1).exe

- 基于python+PYQT开发的电子发票管理软件(源码+说明)

- 基于STM32F103C8T6与ATT7022芯片的三相交流电测量RTU-功能丰富、数据准确、稳定可靠的电能监控系统,基于STM32与ATT7022芯片的三相交流电测量RTU系统:集成电压、电流及多

- 回溯组合问题_202503061309_56587.pdf

- 基于python和豆包开发的根据提示词生成脚本 通过视频脚本调用微软tts生成语音功能的软件(源码)

信息提交成功

信息提交成功