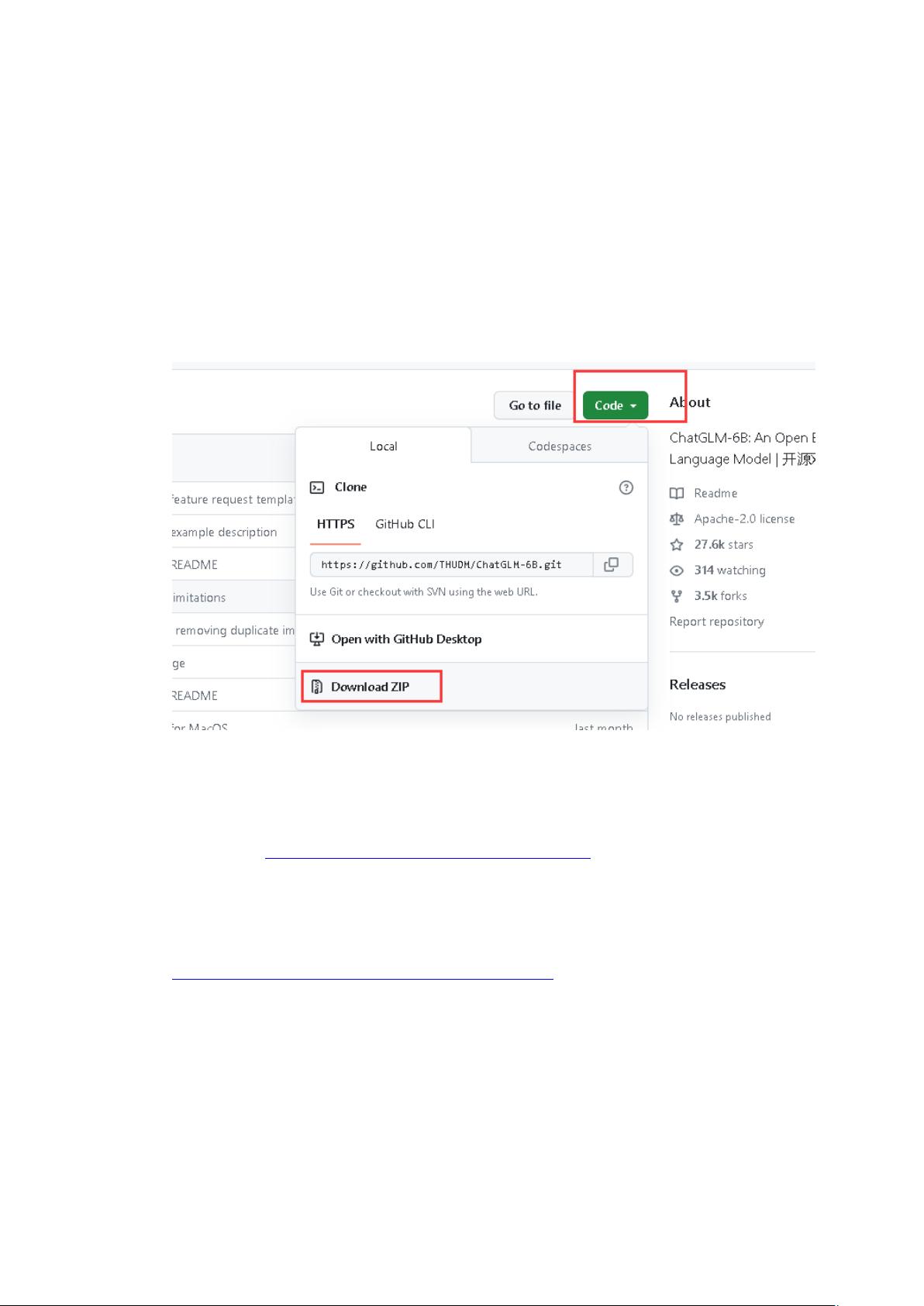

在本文档中,我们将深入探讨如何在Windows操作系统下部署和运行清华大学开发的ChatGLM-6B语言模型。ChatGLM-6B是一款强大的开源对话语言模型,具备中英双语支持和图像理解功能,其基础是General Language Model (GLM)架构,拥有62亿参数。即使在没有高端GPU的环境下,通过量化技术也能在消费级计算机上实现本地部署。 了解ChatGLM-6B的基本功能,它可以进行各种问答任务,提供与用户的交互式对话体验。对于那些没有GPU资源的用户,该模型提供了不同级别的量化选项,以适应不同的硬件配置。例如,INT4量化级别在推理阶段只需要6GB显存,适合低配电脑。 部署ChatGLM-6B的第一步是获取源代码。你可以直接从GitHub仓库下载ZIP文件,或者如果你已经安装了Git,可以通过命令行使用`git clone`命令来克隆项目。在某些情况下,可能需要配置网络代理以解决访问GitHub的问题。 接下来,检查你的硬件环境。在这个例子中,我们有一个CPU为3.4GHz、内存16GB、运行Windows 10的系统,没有GPU。由于没有GPU,我们将使用INT4量化模型,这是对CPU最友好的选择。 在获取源代码后,进入项目目录并安装所有必要的Python依赖库。这些依赖库的列表存储在`requirements.txt`文件中,可以通过`pip install -r requirements.txt`命令一次性安装。这包括8个核心库,确保模型能够正常运行。 为了运行INT4量化模型,需要下载相应的模型文件,并将其保存到指定的文件夹。接着,需要安装C/C++编译环境,特别是OpenMP库,以便编译模型中包含的`quantization_kernels.c`和`quantization_kernels_parallel.c`文件。可以从指定的链接下载TDM-GCC编译器,按照安装向导的步骤操作,确保在安装过程中选中OpenMP选项。 安装完成后,使用命令行进入INT4模型文件夹,并运行`gcc`命令编译这两个C文件,生成`.so`动态链接库文件。这一步骤是确保模型能够在CPU上正确运行的关键。 运行ChatGLM-6B模型有两种主要方式:在Python程序中直接调用,或者通过命令行接口。在Python环境中,可以导入`transformers`库的`AutoTokenizer`和`AutoModel`,设置模型路径,然后创建实例以进行交互。此外,还可以编写自定义脚本来实现特定的功能或接口,以适应不同的应用场景。 部署ChatGLM-6B在Windows系统下需要安装和配置一系列软件,包括Git、Python依赖库、C/C++编译环境以及模型文件。尽管过程可能相对复杂,但对于那些希望在本地运行大型语言模型且硬件资源有限的用户来说,这是一个非常实用的解决方案。通过量化技术,ChatGLM-6B能够在不牺牲太多性能的情况下,实现在普通PC上的高效运行。

剩余9页未读,继续阅读

- 粉丝: 1w+

- 资源: 73

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

- 1

- 2

- 3

- 4

- 5

- 6

前往页