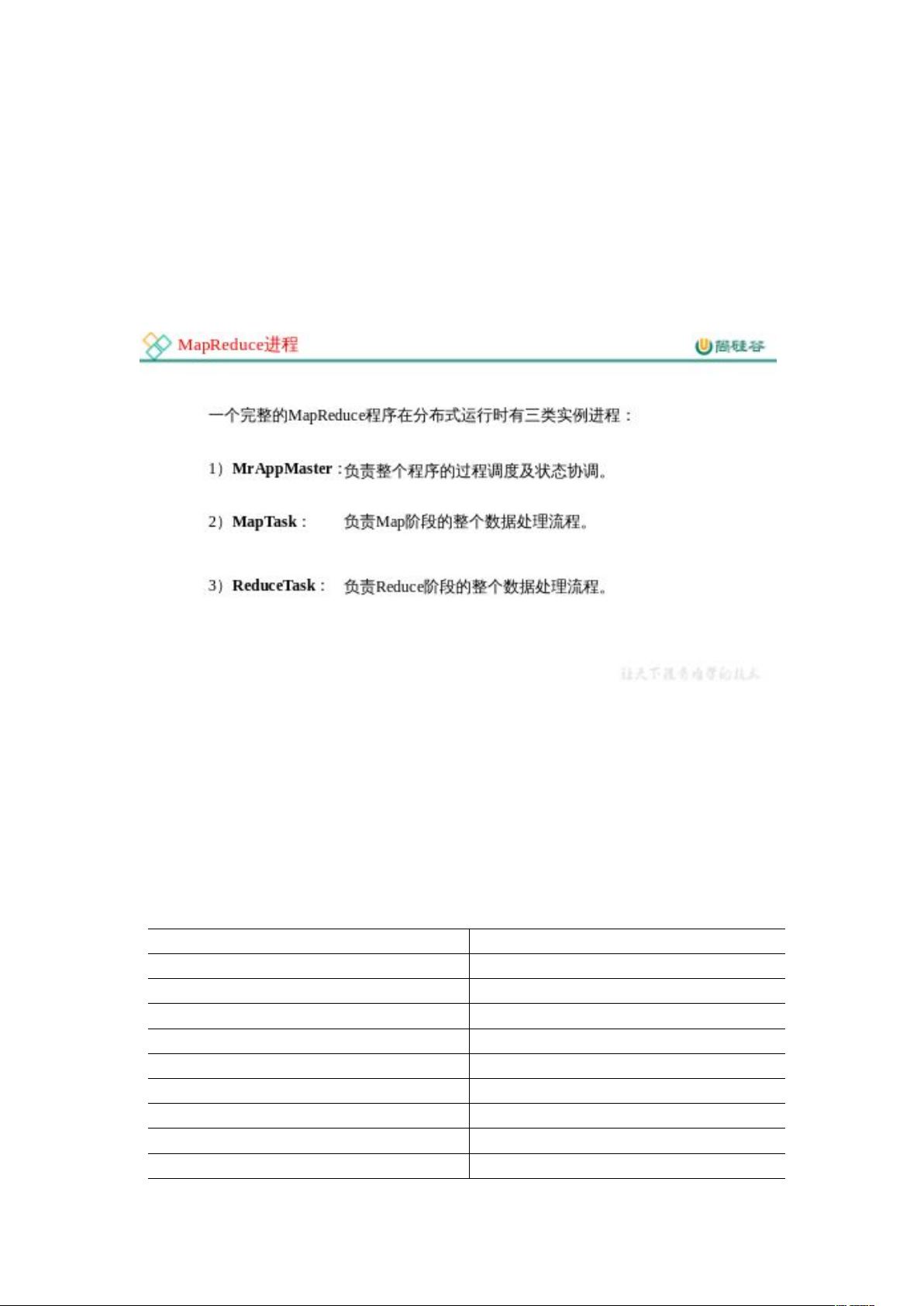

MapReduce是Hadoop生态系统中的核心组件之一,主要用于处理和生成大规模数据集。它的设计目标是简化分布式计算,使得开发者能够专注于编写业务逻辑,而无需过多关注底层分布式系统的复杂性。 **1. MapReduce定义** MapReduce是一种编程模型,用于处理和生成大规模数据集。它将大规模数据处理任务分解为两个主要阶段:Map阶段和Reduce阶段,这两个阶段通过中间结果进行通信。 **1.1 优点** - **可扩展性**:MapReduce能够轻松地扩展到数千台服务器,处理PB级别的数据。 - **容错性**:系统能够自动处理节点故障,保证任务的完整性。 - **并行处理**:Map和Reduce任务可以并行执行,极大地提高了处理速度。 - **易编程**:使用简单的编程模型,适合处理结构化的和非结构化的数据。 **1.2 缺点** - **延迟高**:MapReduce不适合实时或低延迟的查询需求。 - **不适合细粒度更新**:对已处理数据的修改或更新操作效率低下。 - **资源利用率**:由于数据划分和通信开销,MapReduce可能无法充分利用所有计算资源。 **1.3 核心思想** MapReduce的核心思想包括: 1. Map阶段:将输入数据分割成多个键值对,然后应用用户定义的Map函数,生成中间键值对。 2. Shuffle阶段:对中间键值对进行排序和分区,为Reduce阶段做准备。 3. Reduce阶段:根据相同的键将中间键值对分组,并应用用户定义的Reduce函数,生成最终结果。 **1.4 MapReduce进程** MapReduce工作流程包括JobTracker(在Hadoop 2.x中被ResourceManager替代)、TaskTracker(被NodeManager替代)以及MapTask和ReduceTask。JobTracker负责任务调度,TaskTracker执行实际的任务。 **1.5 WordCount源码** WordCount是MapReduce的典型示例,它包括Map类、Reduce类和Driver类。数据类型通常使用Hadoop的序列化类型,如Text和IntWritable。 **1.6 数据序列化类型** Hadoop提供了一系列的Writable接口实现,用于不同数据类型的序列化和反序列化,如BooleanWritable、IntWritable等。 **1.7 编程规范** 用户需要编写Mapper、Reducer和Driver三个部分。Mapper处理输入数据,Reducer聚合Mapper的结果,Driver则是整个Job的入口点,负责提交任务到集群。 **1.8 WordCount案例实操** 在WordCount案例中,用户需按照需求分析编写Mapper、Reducer和Driver,并配置相应的依赖。Mapper将输入文本拆分成单词,Reducer则统计每个单词的总数。 在实际操作中,首先创建Maven工程,然后在pom.xml文件中添加Hadoop相关依赖。同时,配置log4j.properties文件以控制日志输出。 总结,MapReduce是Hadoop处理大数据的核心工具,通过简单的编程模型实现了大规模数据的高效并行处理。了解并掌握MapReduce的工作原理、优缺点以及编程规范,对于大数据开发人员来说至关重要。在实际项目中,可以通过编写WordCount这样的简单应用来加深对MapReduce的理解。

剩余63页未读,继续阅读

- 粉丝: 12

- 资源: 4

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功