基于tensorflow serving的模型部署方案以及代码.zip

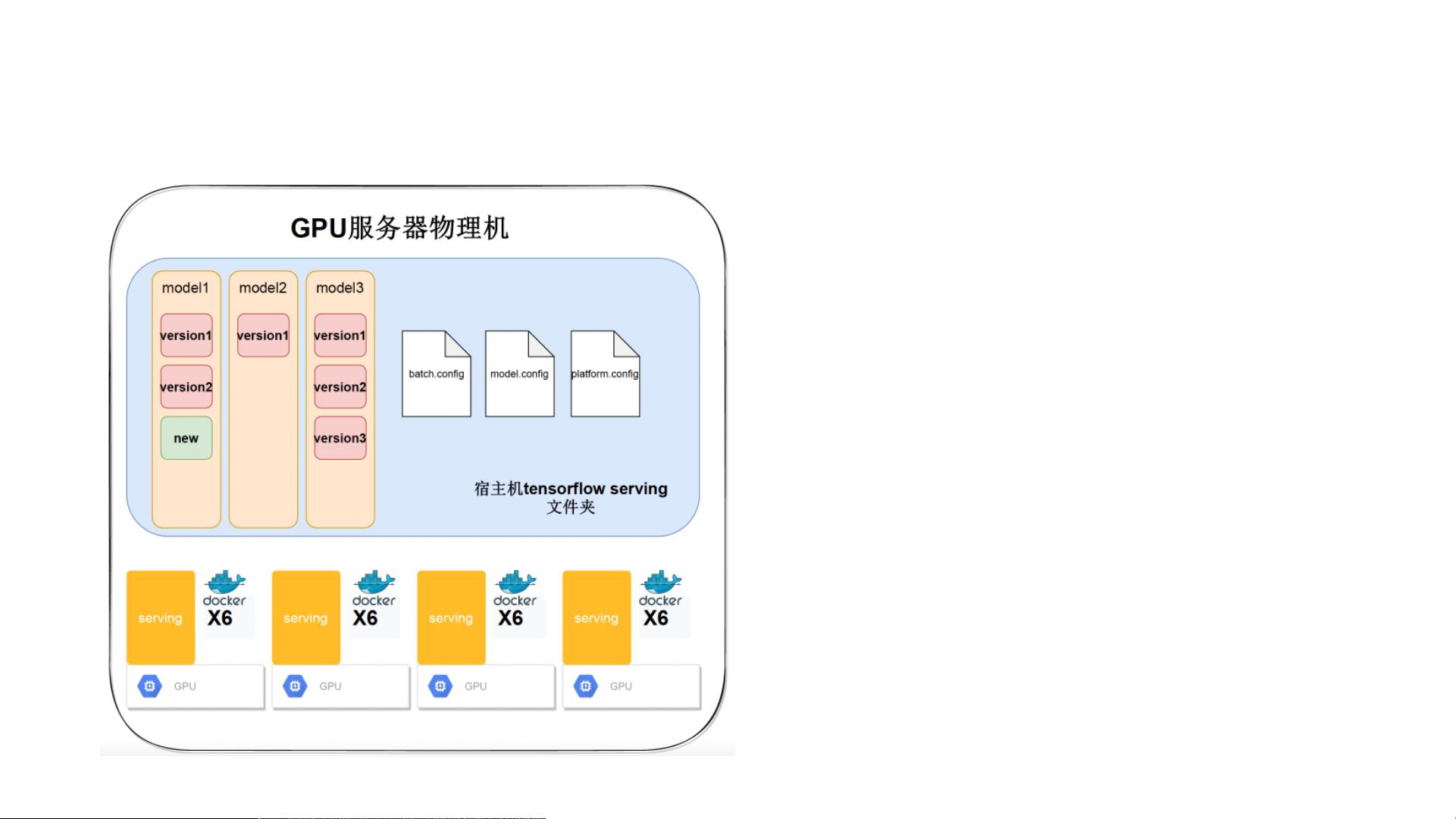

在当前的IT行业中,深度学习已经成为了人工智能领域的重要支柱,而TensorFlow则是一个广泛使用的开源框架,用于构建和训练复杂的神经网络模型。本教程将详细阐述如何利用TensorFlow Serving进行模型部署,以便在生产环境中有效地服务于实时预测需求。 **一、TensorFlow Serving简介** TensorFlow Serving 是一个高性能、灵活且可扩展的模型服务系统,它允许开发人员在生产环境中快速地部署新模型,并且可以无缝地更新模型版本,确保服务的稳定性和连续性。TensorFlow Serving 提供了一个标准的接口,使得客户端可以通过简单的API请求来访问模型,而无需了解模型内部的实现细节。 **二、TensorFlow Serving的组成部分** 1. **ModelServer**:核心组件,负责加载、管理和执行模型。 2. **Model Manager**:用于管理模型版本,包括加载、卸载、查询等操作。 3. **Predictor**:实际执行推理任务的组件,根据接收到的请求调用模型进行预测。 4. **RESTful API 和 gRPC API**:提供与ModelServer通信的接口,客户端可以通过这些接口发送预测请求。 **三、模型部署步骤** 1. **构建模型**: 使用TensorFlow构建并训练好模型,保存为 SavedModel 格式。SavedModel 是TensorFlow推荐的模型保存格式,包含了模型的结构、变量和元数据。 2. **准备模型服务器**: 配置TensorFlow Serving的环境,包括安装必要的依赖和设置服务器配置文件。 3. **部署模型**: 将保存的SavedModel目录复制到ModelServer的工作目录下,指定模型的名字和版本号。 4. **启动ModelServer**: 运行ModelServer,它会自动检测新添加的模型并加载。 5. **发送预测请求**: 客户端通过RESTful API或gRPC API向ModelServer发送预测请求,包括模型名称、版本和输入数据。 **四、TensorFlow Serving的灵活性** 1. **多版本支持**:在同一时间,TensorFlow Serving可以同时服务多个版本的同一模型,方便A/B测试和回滚。 2. **动态资源分配**:可以根据负载情况动态调整资源分配,提高服务效率。 3. **可扩展性**:可以集成到现有的微服务架构中,支持集群部署和负载均衡。 **五、实战演练** 在提供的`Tensorflow_Serving-master`文件中,你将找到一个实例化的TensorFlow Serving部署教程。这个项目包含以下部分: 1. **预训练模型**:可能包括一个已经训练好的TensorFlow模型。 2. **模型保存脚本**:用于将训练好的模型保存为SavedModel格式。 3. **ModelServer配置文件**:配置ModelServer的启动参数。 4. **客户端示例**:展示如何编写客户端代码,通过RESTful API或gRPC API向ModelServer发送请求。 通过这个压缩包,你可以亲身体验从模型训练到部署的全过程,理解TensorFlow Serving如何在实际应用中发挥关键作用。学习并掌握这些知识,将有助于你在深度学习和人工智能领域的实践和创新。

基于tensorflow serving的模型部署方案以及代码.zip (14个子文件)

基于tensorflow serving的模型部署方案以及代码.zip (14个子文件)  Tensorflow_Serving-master

Tensorflow_Serving-master  latency_test_model

latency_test_model  1

1  saved_model.pb 15.5MB

saved_model.pb 15.5MB variables

variables  variables.index 144B

variables.index 144B variables.data-00000-of-00001 111B

variables.data-00000-of-00001 111B batch.config 131B

batch.config 131B model.config 165B

model.config 165B start_tfserving.sh 312B

start_tfserving.sh 312B start_tfserving_gpu.sh 348B

start_tfserving_gpu.sh 348B nohup.out 13KB

nohup.out 13KB tensorflow serving的调研和部署方案的制定.pptx 4.25MB

tensorflow serving的调研和部署方案的制定.pptx 4.25MB Tensorflow Serving调研总结.md 7KB

Tensorflow Serving调研总结.md 7KB start_tfserving_multi_gpu.sh 9KB

start_tfserving_multi_gpu.sh 9KB stop_tfserving.sh 384B

stop_tfserving.sh 384B test.py 863B

test.py 863B platform.config 328B

platform.config 328B- 1

- 粉丝: 2381

- 资源: 5995

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功