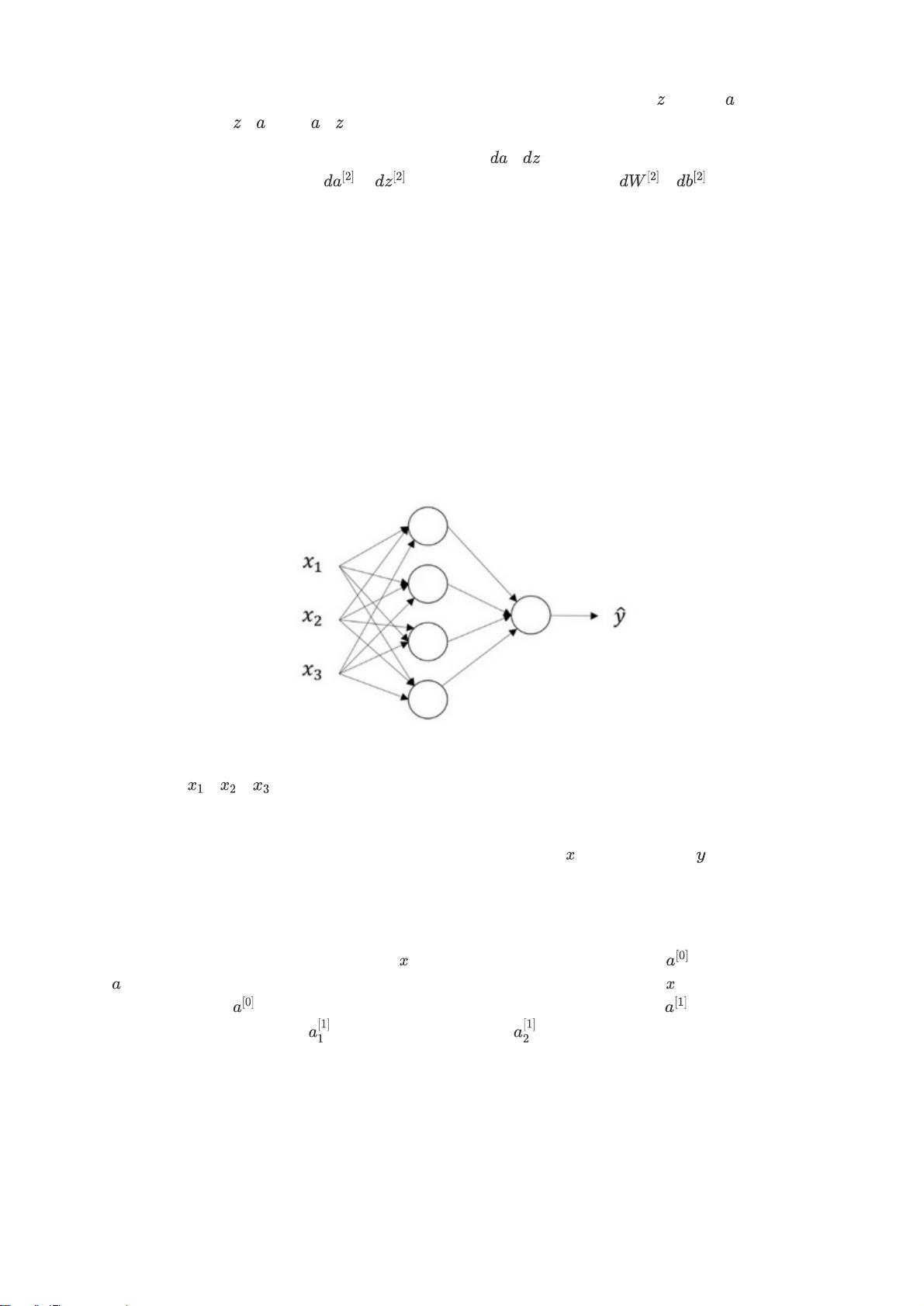

在吴恩达的深度学习与神经网络课程笔记中,第三周的内容专注于浅层神经网络。这一周的学习内容涵盖了从神经网络的基本概念,到具体实现神经网络的步骤,再到激活函数的使用、向量化运算以及梯度下降的原理等重要知识点。 浅层神经网络概述(Neural Network Overview)部分,讲解者吴恩达介绍了神经网络的概念,并指出它们是由多个sigmoid单元堆叠而成的。神经网络由输入层、隐藏层和输出层组成,每一层都包含若干节点(或称为神经元)。输入层负责接收数据,隐藏层负责处理数据,而输出层则产生最终的预测值。神经网络能够从输入数据中学习到复杂的函数映射,这使其在图像识别、语音识别等领域具有广泛应用。 在神经网络的表示(Neural Network Representation)中,讲解者着重于如何用数学模型来表达神经网络,包括参数和激活函数的选择。以一个包含一个隐藏层的简单神经网络为例,输入层接收输入数据,隐藏层通过前向传播(Forward Propagation)计算各层的输出值。每个节点的输出是上一层所有节点输出的加权和,再加上一个偏置项,然后通过非线性激活函数得到。 计算一个神经网络的输出(Computing a Neural Network's Output)中,涉及了如何通过矩阵运算来快速计算多个样本的输出值。通过向量化(Vectorization),可以将对单个样本的计算扩展到对一个样本集的计算,这可以极大地提升计算效率。 多样本向量化(Vectorizing Across Multiple Examples)和向量化实现的解释(Justification for Vectorized Implementation)两部分讨论了向量化的优点和实现的必要性。向量化能够减少计算资源的消耗,并提高算法的执行速度,这对于处理大规模数据集尤为重要。 激活函数(Activation Functions)和为什么需要非线性激活函数(Why Need a Nonlinear Activation Function?)两部分介绍了神经网络中非线性的重要性。非线性激活函数使神经网络能够学习到非线性复杂度的数据表示,如Sigmoid函数和ReLU函数。 激活函数的导数(Derivatives of Activation Functions)讨论了激活函数导数的计算方法,这对于理解后向传播(Backpropagation)中梯度的计算至关重要。梯度下降(Gradient Descent for Neural Networks)则解释了如何通过梯度下降算法来优化神经网络的参数,以减少损失函数的值。 在随机初始化(Random Initialization)部分,讲解者指出,为了打破对称性并使网络更好地训练,我们需要对神经网络的参数进行随机初始化。 (选修)直观理解反向传播(Backpropagation Intuition)部分,为理解反向传播提供了直观的解释。反向传播是神经网络中权重更新的核心算法,它通过链式法则反向传播损失函数关于权重的梯度,用于更新网络中每个权重,以最小化损失函数。 以上这些知识点是构建和理解浅层神经网络的基础。学习这些内容能够为构建更复杂的深度学习模型奠定坚实的基础。这些知识点不仅适用于浅层神经网络,对于理解深层次的卷积神经网络(CNN)、循环神经网络(RNN)等也有极大的帮助。在学习了这些基础知识后,学习者可以进一步深入学习反向传播的细节,以及如何通过梯度下降来优化神经网络。

剩余17页未读,继续阅读

- 粉丝: 4

- 资源: 5

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- FM9919E:高性能副边同步整流驱动芯片的技术解析

- (源码)基于Spring Security和Redis的单点登录系统.zip

- (源码)基于Arduino实现的CRC硬件校验系统.zip

- 半桥电路的开环仿真PSIM

- (源码)基于C++的RucBase数据库管理系统.zip

- 美国华盛顿州电动汽车保有量数据集(21W+记录)CSV+XML+JSON+RDF格式

- 低功耗原边反馈开关电源芯片TC2526HA/TC2526HB的技术解析

- (源码)基于PyTorch框架的图像识别系统.zip

- Java项目:图书管理系统(基于Java+Springboot+Maven+MyBatisPlus+Vue+Mysql)

- 使用C语言实现字符串逆序输出实现方式.docx

信息提交成功

信息提交成功