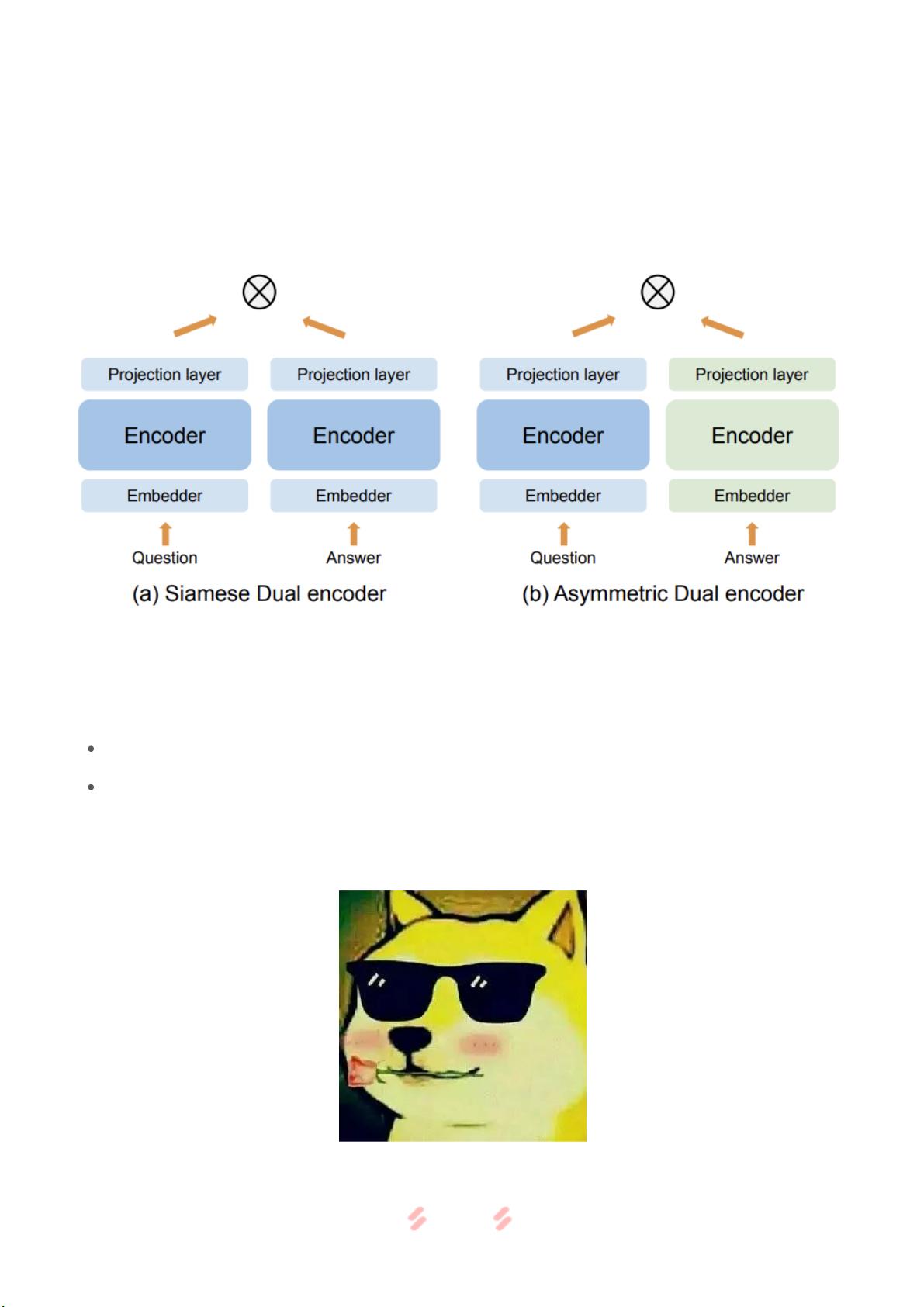

标题中的“双塔模型的最强出装,谷歌又开始玩起“老古董”了?”暗示了一个关于谷歌可能重新利用或改进旧有技术——双塔模型的讨论。双塔模型通常指的是在自然语言处理(NLP)领域中,用于解决如语义匹配、问答对检索等问题的一种深度学习架构。它由两个独立的神经网络组成,每个网络(即一个“塔”)分别对输入数据的不同部分进行编码,然后通过比较两个编码向量来评估它们的相关性。 在AI、计算机视觉(CV)、人工智能(AI)、自然语言处理(NLP)以及深度学习这些标签中,我们可以看到这一话题涵盖了多个关键领域。双塔模型最初可能在NLP任务中被广泛采用,但随着时间的推移,随着AI技术的进步,各种新型的模型如BERT、GPT等已经超越了传统的双塔结构。然而,谷歌可能发现,在某些特定场景下,双塔模型依然具有其优势,或者能通过新的优化策略焕发新生。 双塔模型的出装可能指的是在构建和训练模型时采用的具体技术组合,例如: 1. **预训练与微调**:双塔模型可能先在大规模无标注文本上进行预训练,然后再针对特定任务进行微调,以提高性能。 2. **注意力机制**:结合自注意力或Transformer架构,增强模型对输入序列不同部分的权重分配能力。 3. **负样本采样**:在训练过程中,合理选择负样本,提高模型区分正负样本的能力。 4. **损失函数**:可能采用了如余弦相似度、对数似然等不同的损失函数,以适应不同的匹配任务。 5. **优化器与学习率策略**:比如使用Adam优化器,配合学习率衰减策略,确保模型在训练过程中的收敛性。 谷歌再次关注“老古董”,可能是因为: 1. **效率**:相比于更复杂的模型,双塔模型可能在计算资源和推理速度上有优势,对于某些实时或资源受限的应用场景是理想的。 2. **可解释性**:双塔模型的结构相对简单,其决策过程可能更容易理解和解释,这对于满足日益增长的AI透明度需求很重要。 3. **鲁棒性**:经过时间考验的技术往往具有较好的泛化能力和鲁棒性,能够应对各种未知挑战。 尽管新的模型和算法不断涌现,但旧有技术的重新挖掘和优化仍然是AI领域的一个重要方向。谷歌作为行业领导者,其对双塔模型的研究可能会带来新的见解和突破,使得“老古董”焕发新的生命力。通过深入研究和理解这些技术,我们可以更好地推动AI技术的发展,同时也可以在实际应用中找到更适合的解决方案。

双塔模型的最强出装,谷歌又开始玩起“老古董”了?.rar (1个子文件)

双塔模型的最强出装,谷歌又开始玩起“老古董”了?.rar (1个子文件)  双塔模型的最强出装,谷歌又开始玩起“老古董”了?.pdf 1.46MB

双塔模型的最强出装,谷歌又开始玩起“老古董”了?.pdf 1.46MB- 1

- 粉丝: 2w+

- 资源: 635

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功