AI绘画教程 Stable Diffusion中如何控制人像的姿势?

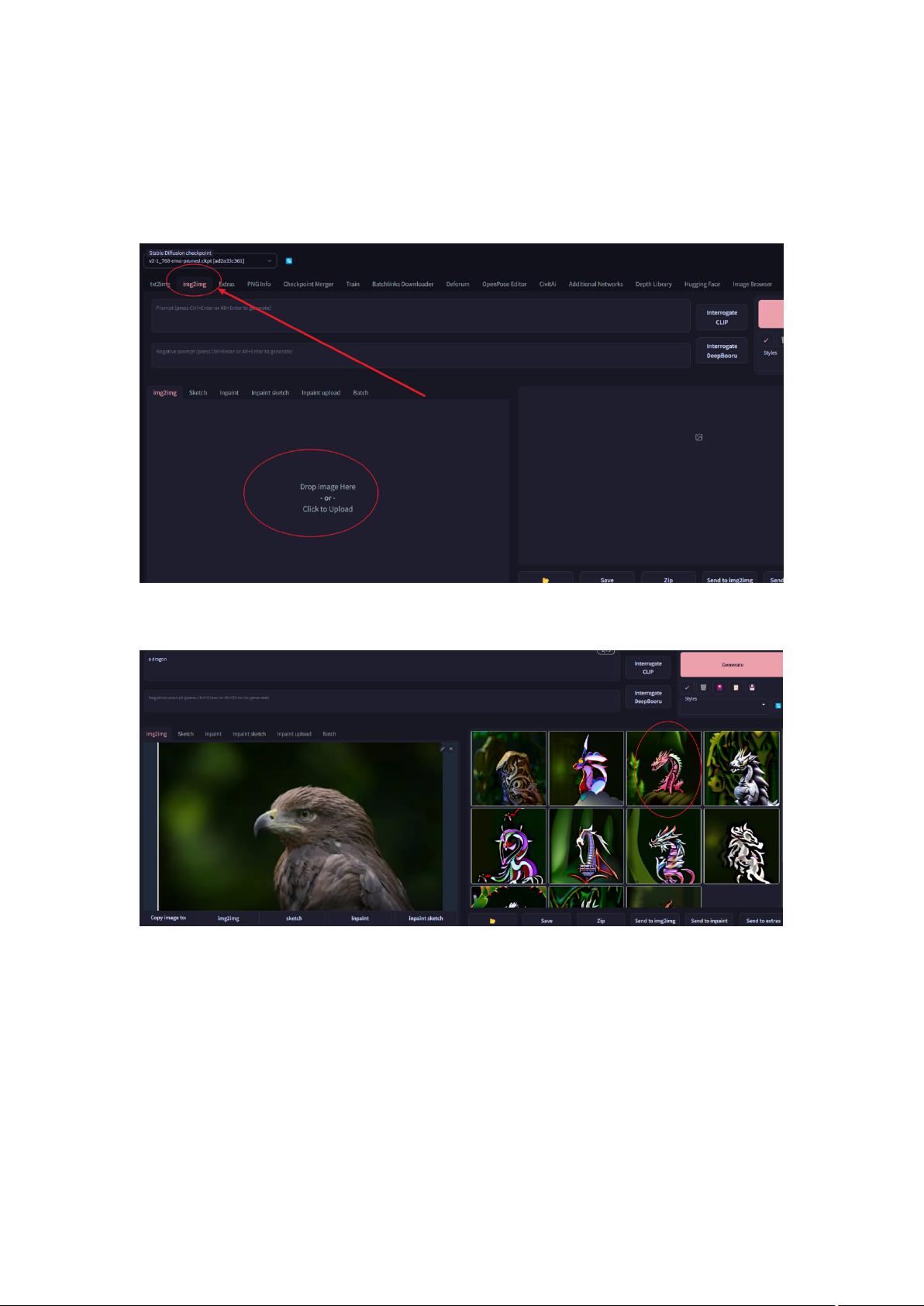

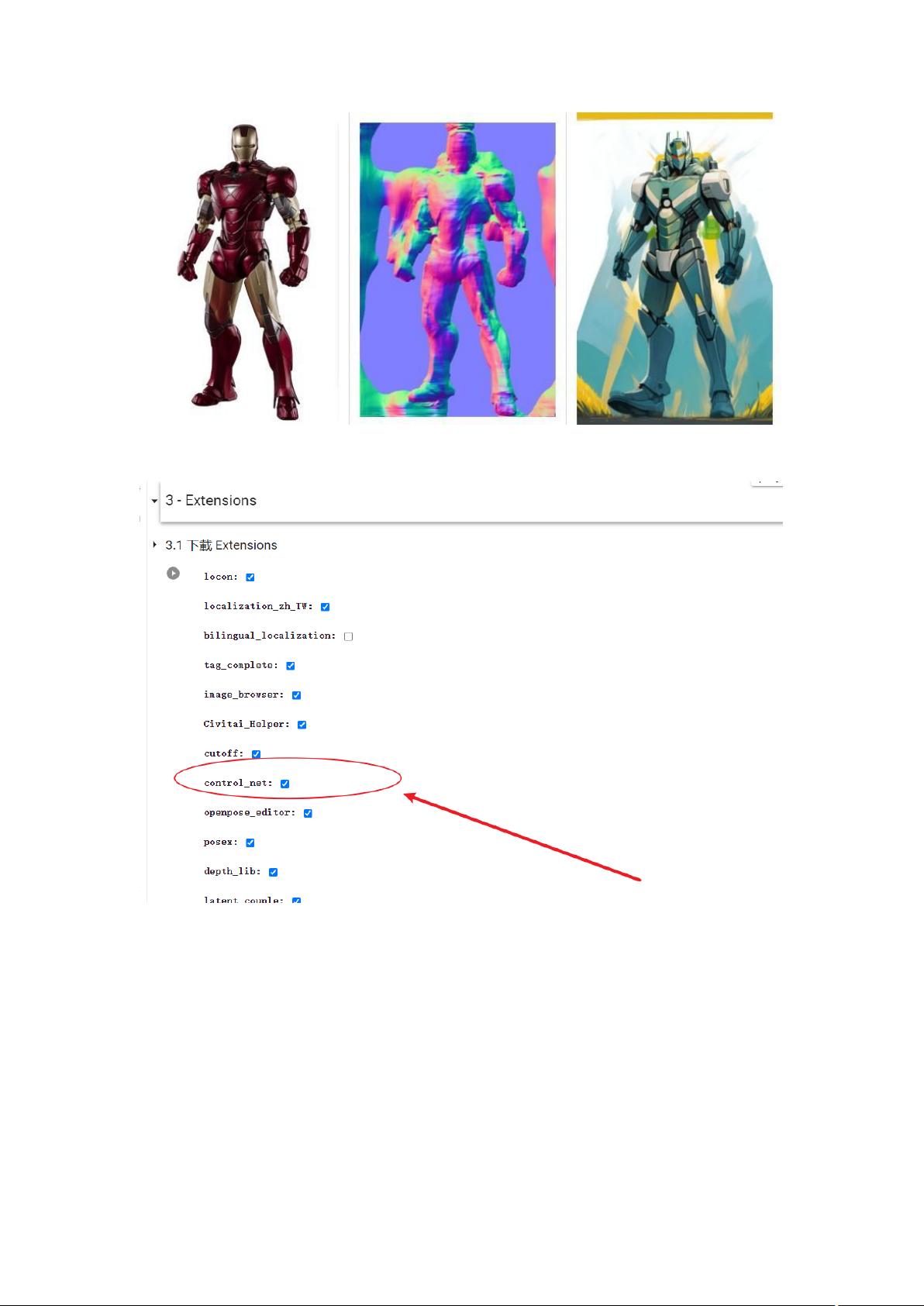

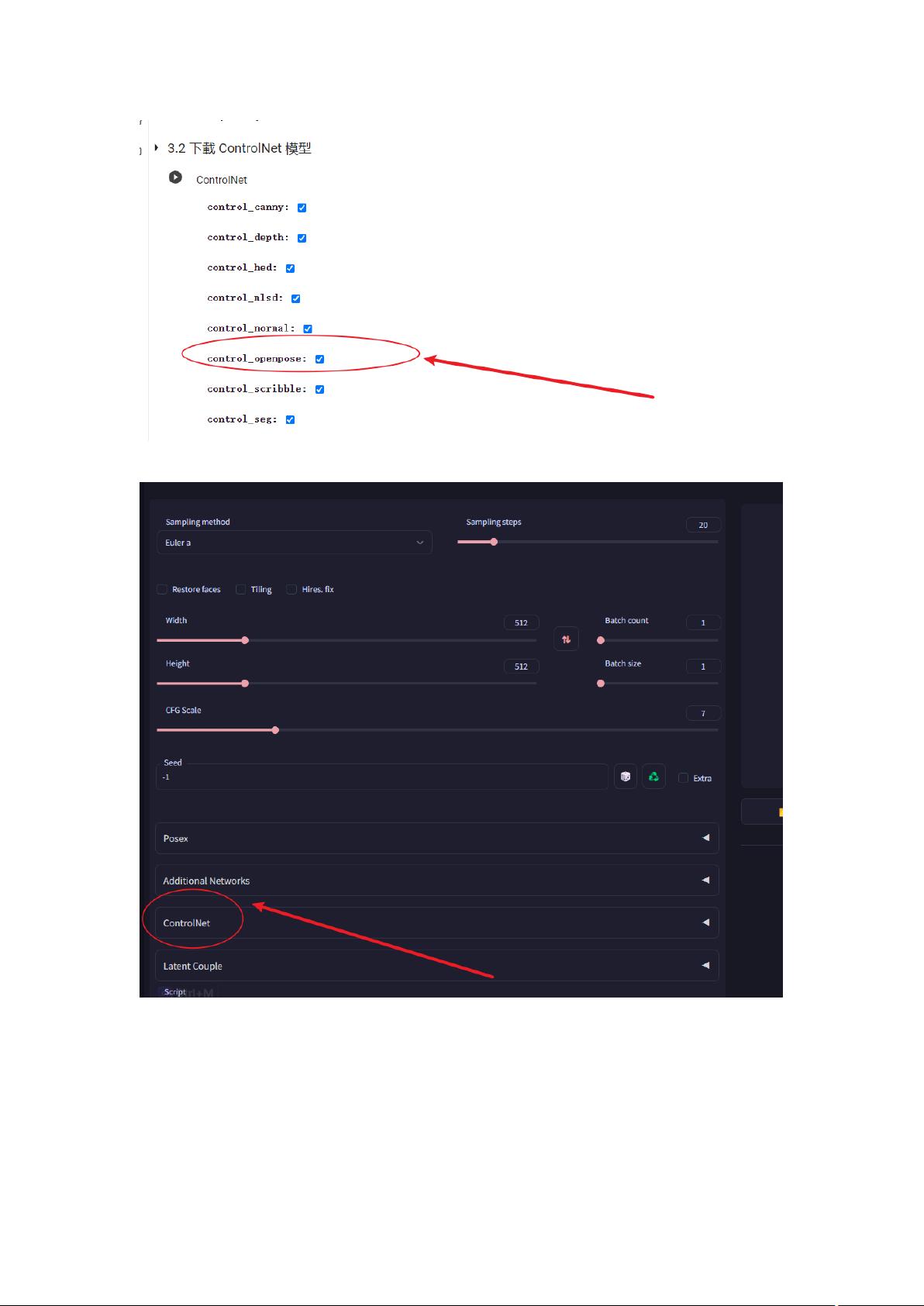

AI绘画教程 Stable Diffusion 中控制人像姿势的方法 在 AI 绘画中,有时候我们需要主角(人物或动物)摆出特定的姿势,该怎么做呢?本文将介绍 Stable Diffusion 中控制人像姿势的两种方法。 方法一:使用提示词和图片 第一种方法是使用提示词和图片。在 Stable Diffusion 界面,点击 imag2img 下面的“drop image here or click to upload”方框,从网上找一张你希望呈现的姿势图片,然后拖拽到方框,或者从本地电脑上传。接着在提示词框里输入提示词,比如:a dragon,然后点击 generate 生成图像。但是这样生成的图像,姿势不好控制,有些会比较像,有些差很远。 方法二:使用 ControlNet 第二种方法是使用 ControlNet。这是一个很强大的 Stable Diffusion 插件,可以精准的控制 AI 绘画中的人物或动物的姿势,从而生成很多好玩有创意的图片。ControlNet 可以精准的控制姿势,因为它可以采取图片中的人物骨架做为参考,以生成图片。 ControlNet 的 Preprocessor 模型 ControlNet 的 Preprocessor 模型有很多种,包括: * OpenPose:最常用的模型,采取图片中的人物骨架做为参考,以生成图片。用于人物动作。 * Canny:撷取图片中的边缘线做为参考,以生成图片。 * Depth:提取深度检测信息,可以生成具有同样深度结构的图。 * Normal:模型识别,跟深度图有点类似,但对于细节的保留更加的精确。 * Pidinet:检测图像中的曲线和直线条,然后生成图片。 * Scribbles:手稿模型 撷取使用者提供的线条做为参考,以生成图片。 * Segmentation:将图片化为大略的色块作为参考,以生成图片。 * Fake Scribble:从成品图中提取出草图,并生成图片。 选择合适的 Preprocessor 模型 这些不同的模型采用的不同方法来控制姿势,并没有谁更好谁更差,而是需要根据需要和图像特征来选择对应的合适模型。通常来说,对于人像,HED 模型可以最精准的复制人物动作。Canny、Depth、Normal 也不错,但是有时可能会有一些变形。 在实际应用中,我们可以根据需要选择合适的 Preprocessor 模型,以达到最好的效果。例如,如果我们想要生成一个人物站在某个位置的图片,我们可以选择 OpenPose 模型;如果我们想要生成一个建筑物的图片,我们可以选择 Depth 模型。

剩余13页未读,继续阅读

- 粉丝: 2345

- 资源: 22

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功