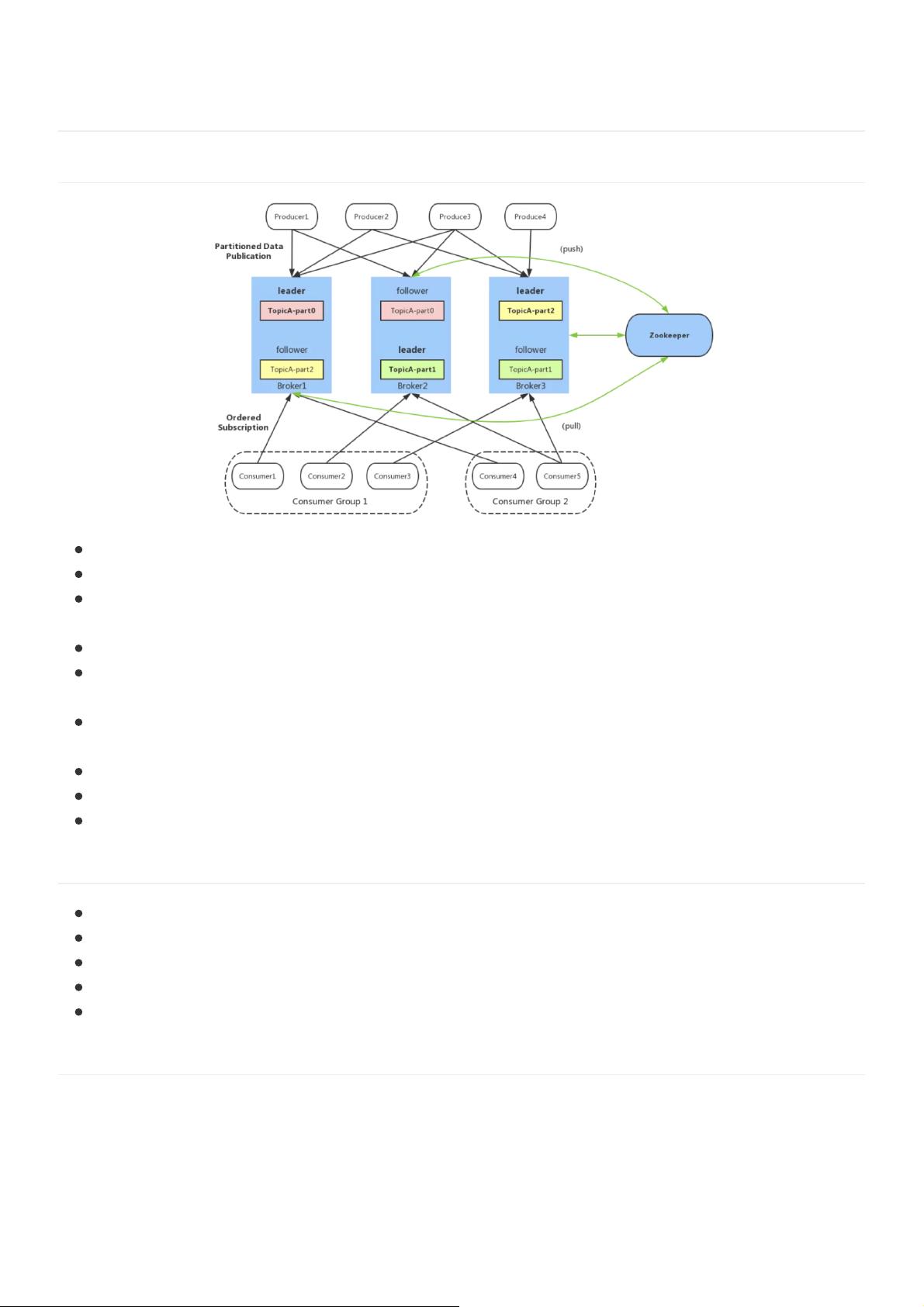

《Kafka大厂面试题解析》 Kafka作为一款分布式消息中间件,广泛应用于大数据处理、日志聚合、系统解耦、流量削峰和异步处理等场景。其架构包括Producer、Consumer、Consumer Group、Broker、Topic、Partition、Replica和Controller等核心组件。Producer负责创建消息并发送至Kafka;Consumer接收并处理消息;Consumer Group确保消息的唯一消费;Broker是Kafka的节点,构成集群;Topic将消息划分为多个Partition;Replica提供高可用性;Controller处理选举和故障转移;而Zookeeper则用于集群管理和元数据存储。 Kafka的使用场景包括: 1. 系统解耦:通过消息传递,让不同系统间的工作独立进行,提高系统的灵活性。 2. 流量削峰:在高并发事件中,如秒杀活动,Kafka可缓解瞬时流量压力。 3. 异步处理:消息放入队列,按需处理,提高系统响应速度。 4. 日志聚合:收集各类服务日志,便于存储和分析。 5. 大数据实时计算:Kafka的流处理能力使其在大数据领域备受青睐。 相比其他消息队列,Kafka具有以下优势: 1. 极致性能:采用Pull模式,批量处理,异步操作,达到千万级别消息处理速度。 2. 生态系统兼容性:与大数据和流计算生态高度融合,如Spark、Flink等。 Kafka与RocketMQ在选型时,需要考虑应用场景、性能需求、社区支持、生态系统等因素。Kafka在高吞吐量、低延迟、生态兼容性方面表现出色,而RocketMQ可能在稳定性、管理工具等方面有一定优势。 Kafka的高效性能源于多方面: 1. 页面缓存:利用操作系统页面缓存,提高写入速度。 2. 磁盘顺序写:数据追加至文件末尾,减少磁盘I/O操作。 3. 零拷贝:减少数据在内核空间和用户空间之间的拷贝。 4. 分区与索引:分区分段存储,建立索引,提升读取效率,支持并行处理。 5. 批量读写:批量处理数据,降低网络往返开销。 6. 批量压缩:压缩消息,减少网络传输时间。 Kafka的零拷贝过程: 1. 数据从磁盘加载至内核空间的页缓存。 2. 数据通过内核空间的描述符传输至Socket Buffer,不涉及实际数据拷贝。 3. 操作系统仅将数据描述符拷贝到Socket Buffer,然后通过网卡发送。 Zookeeper在Kafka中的作用: 1. 成员管理:协调Broker的生命周期,实现负载均衡。 2. 元数据存储:保存主题和分区信息,确保数据一致性。 3. 消费进度跟踪:记录Consumer的Offset,确保消费状态持久化。 了解这些核心概念和技术细节,对于理解和应对Kafka相关的面试题至关重要,同时也为实际项目中的应用提供了理论基础。

- 粉丝: 2w+

- 资源: 15

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 3dmmods_倾城系列月白_by_白嫖萌新.zip

- springboot-教务管理系统(编号:62528147).zip

- Linux下的cursor安装包

- 五相电机双闭环矢量控制模型-采用邻近四矢量SVPWM-MATLAB-Simulink仿真模型包括: (1)原理说明文档(重要):包括扇区判断、矢量作用时间计算、矢量作用顺序及切时间计算、PWM波的生成

- 基于JavaScript的在线考试系统(编号:65965158)(1).zip

- 指针扫描和内存遍历二合一工具

- 青龙燕铁衣-数据集.zip

- 组播报文转发原理的及图解实例

- Java答题期末考试必须考

- 量化交易-RSI策略(vectorbt实现)

- install_dmt.apk

- 1_烽火HG680-KA-mv310(四川湖北湖南新疆河北山东甘肃等)免拆固件.zip

- typora免费正版安装包

- GZ036 区块链技术应用赛项赛题第1套附件.zip

- 用Excel表体验梯度下降法

- 用Excel表体验梯度下降法,附带标识版本

信息提交成功

信息提交成功