基于Python的网络爬虫程序设计 开题报告.docx

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

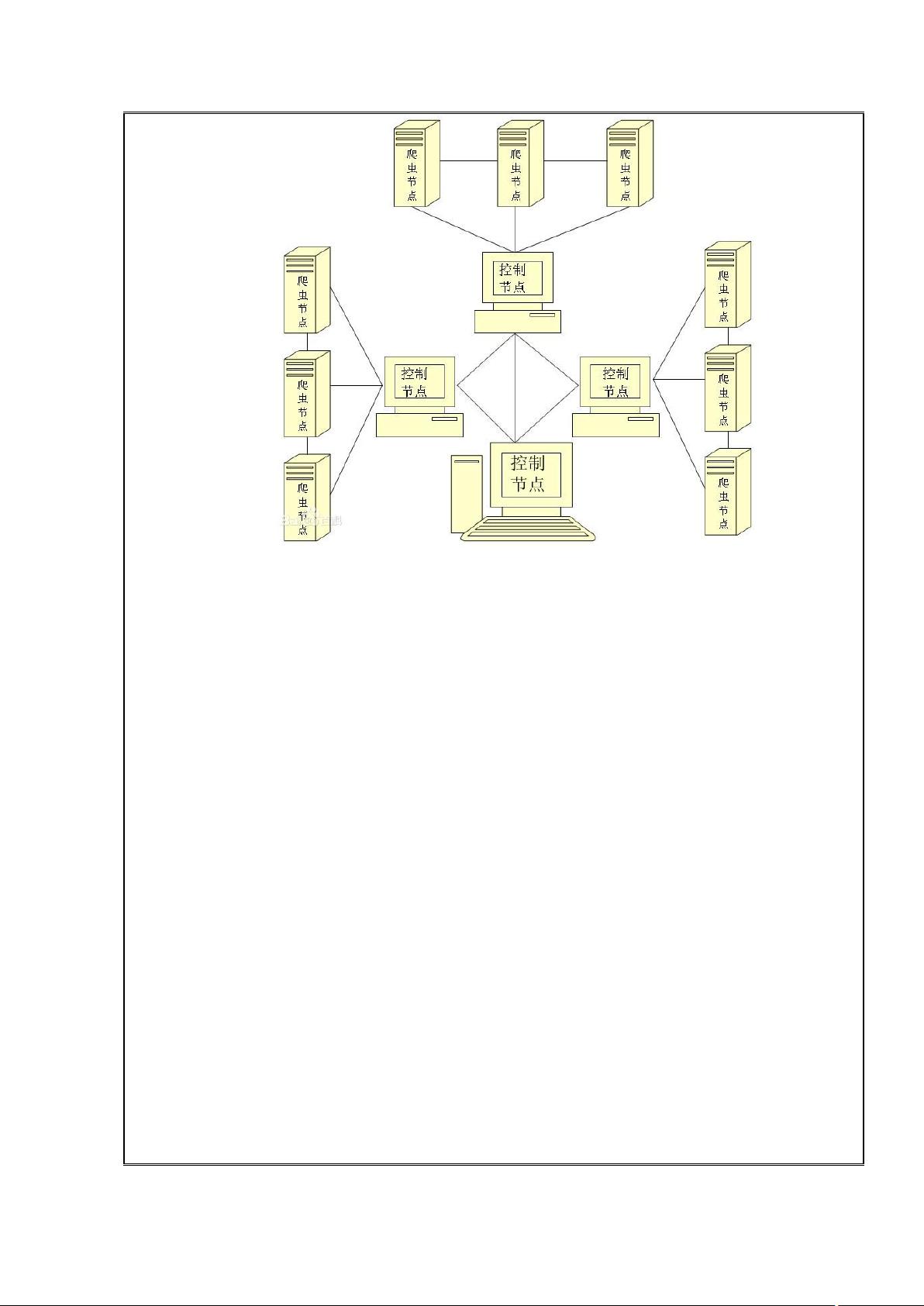

基于Python的网络爬虫程序设计开题报告.docx 本文档是关于基于Python的网络爬虫程序设计的开题报告,主要介绍了网络爬虫的背景、爬虫简介、Python概述和Scrapy概述等内容。 一、研究背景 在大数据时代,掌握更多的数据变得非常重要。网络爬虫是一种常用的从网上爬取数据的手段。它可以按照一定的规则,自动地抓取万维网信息的程序或者脚本。 二、爬虫简介 网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。爬虫的工作流程包括抓取网页、分析网页、提取数据、存储数据等步骤。 三、Python概述 Python是一个高层次的结合了解释性、编译性、互动性和面向对象的脚本语言。它具有很强的可读性,具有比其他语言更有特色语法结构。Python的设计具有很强的可读性,相比其他语言经常使用英文关键字,其他语言的一些标点符号。 四、Scrapy概述 Scrapy是一个用纯Python实现的爬虫框架,用于爬取网站数据、提取结构性数据。使用Scrapy,用户只需要定制开发几个模块就可以轻松地实现一个爬虫,用来抓取网页内容以及各种图片。 五、爬虫架构介绍 爬虫架构主要包括Scrapy Engine、Scheduler、Downloader、Spider、Item Pipeline等组件。Scrapy Engine负责 Spider、ItemPipeline、Downloader、Scheduler 中间的通讯,信号、数据传递等。Scheduler负责接受引擎发送过来的Request请求,并按照一定的方式进行整理排列,入队,当引擎需要时,交还给引擎。Downloader负责下载Scrapy Engine发送的所有Requests请求,并将其获取到的Responses交还给Scrapy Engine,由引擎交给Spider来处理。Spider负责处理所有Responses,从中分析提取数据,获取Item字段需要的数据,并将需要跟进的URL提交给引擎,再次进入Scheduler。Item Pipeline负责处理Spider中获取到的Item,并进行进行后期处理(详细分析、过滤、存储等)的地方。 本文档为基于Python的网络爬虫程序设计开题报告,提供了网络爬虫的背景、爬虫简介、Python概述和Scrapy概述等内容,为读者提供了一个较为详细的python爬虫设计指南。

剩余10页未读,继续阅读

- 粉丝: 7917

- 资源: 3890

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 基于Flask框架的JavaScript、HTML、CSS、Python整合的天气系统设计源码

- ad7606_drv.h

- 基于YOLOv5的工地安全帽识别及危险区域禁入系统设计源码

- 基于Alberto Abadie理论的Penalized Synthetic Control方法设计源码

- Reality安全下载.apk

- 基于Java语言的ape-club程序员社区交流平台设计源码

- 12864yejin.OBJ

- AirportItlwm-v2.3.0-stable-Sonoma14.0.kext.zip

- BOOT-00001前后端分离个人财务管理系统源码+数据库.rar

- Python自动化管理文件技术指南:读写操作、文件夹管理与压缩功能

信息提交成功

信息提交成功