“大数据技术原理与应用”课程实验报告

题目:实验二:熟悉

常用的 HDFS 操作

姓名:朱小凡

日期:2022/3/25

1、实验环境:

设备名称 LAPTOP-9KJS8HO6

处理器 Intel(R) Core(TM) i5-10300H CPU @ 2.50GHz 2.50 GHz

机带 RAM16.0 GB (15.8 GB 可用)

主机操作系统 Windows 10 家庭中文版

虚拟机操作系统 ubuntukylin-16.04

Hadoop 版本 3.1.3

JDK 版本 1.8

Java IDE:Eclipse

系统类型 64 位操作系统, 基于 x64 的处理器

笔和触控 没有可用于此显示器的笔或触控输入

2、实验内容与完成情况:

1、编程实现以下功能,并利用 Hadoop 提供的 shell 命令完成相同任务

(1)向 HDFS 中上传任意文本文件,如果指定的文件在 HDFS 中已经存在,则由

用户来指定是追加到原有文件末尾还是覆盖原有的文件。

本地/usr/local/hadoop/文件夹下新建两个文本文件用于实验

文件一:word.txt 文本内容:1212

文件二:local_text.txt 文本内容:123456789

图 1.创建两个实验文本

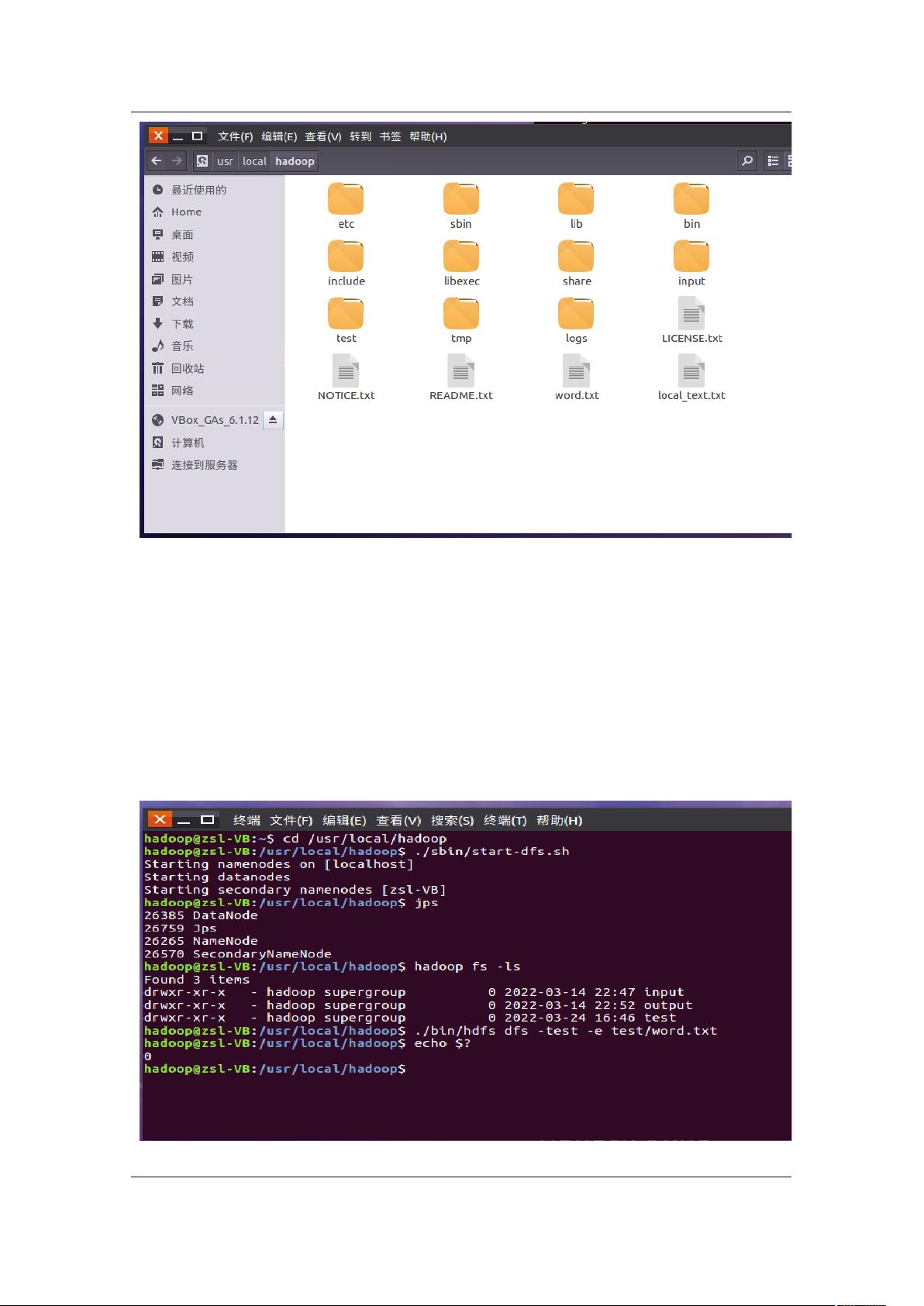

a. Shell 命令

首先向 HDFS 上传 word.txt 文件到 test 文件夹下

./bin/hdfs dfs -put /usr/local/hadoop/word.txt test

检查文件是否存在,可以使用如下命令

cd /usr/local/hadoop

./bin/hdfs dfs -test -e test/word.txt

echo $?

图 2.上传并检查 HDFS 文件

执行完 echo $?返回 0,意味着查询成功,word.txt 文件已存在

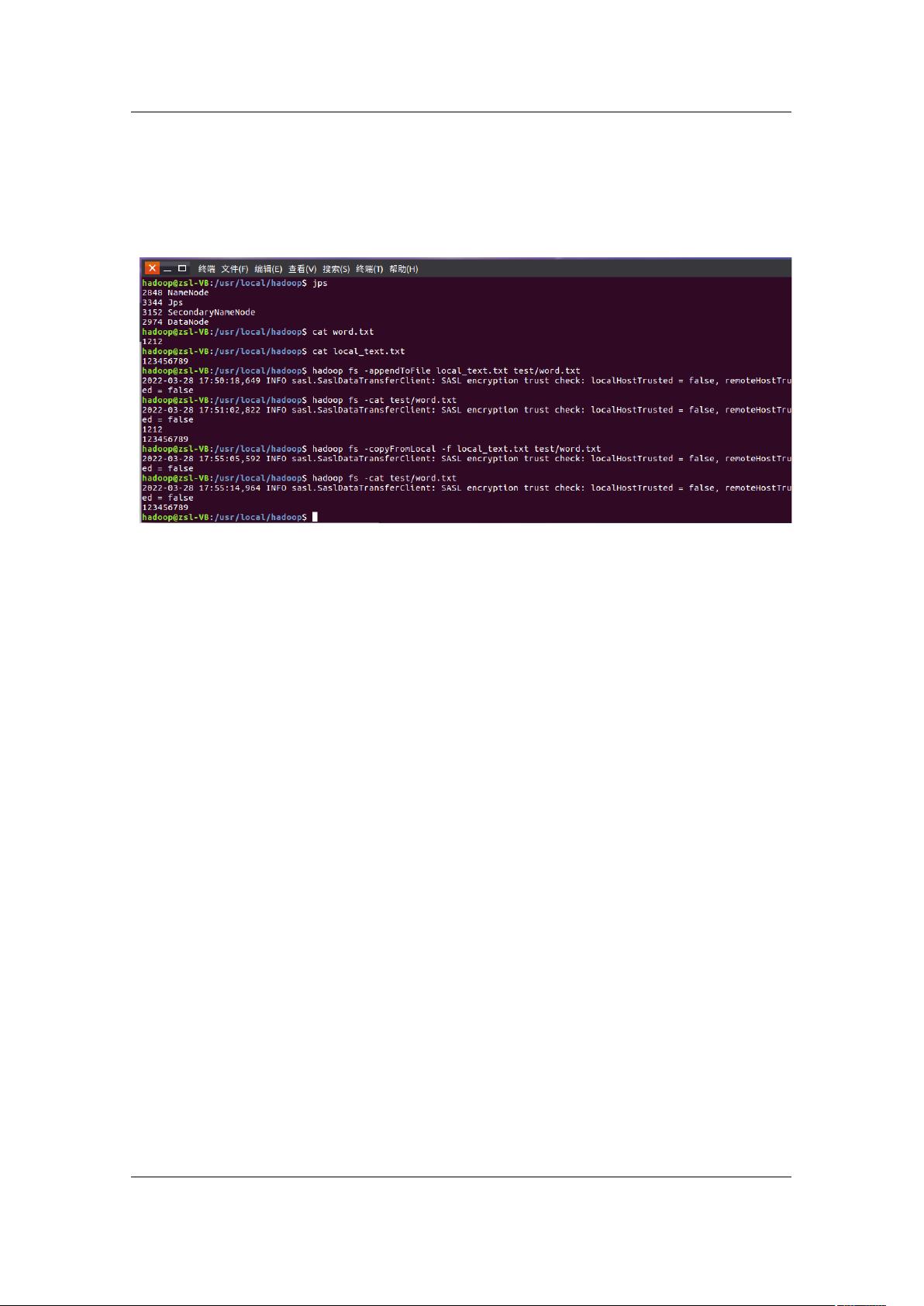

再将 local_text.txt 文件追加到 word.txt 文件末尾

hadoop fs -appendToFile local_text.txt test/word.txt

用 local_text.txt 文件内容覆盖原来的 word.txt 文件

hadoop fs -copyFromLocal -f local_text.txt test/word.txt

图 3.追加文本或者覆盖原文本

b.java 代码

import java.io.FileInputStream;

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class CopyFromLocalFile {

/**

* 判断路径是否存在

*/

public static boolean test(Configuration conf, String path) {

try (FileSystem fs = FileSystem.get(conf)) {

return fs.exists(new Path(path));

} catch (IOException e) {

e.printStackTrace();

return false;

}

}

/**

* 复制文件到指定路径 若路径已存在,则进行覆盖

*/

public static void copyFromLocalFile(Configuration conf,

String localFilePath, String remoteFilePath) {

Path localPath = new Path(localFilePath);

Path remotePath = new Path(remoteFilePath);

try (FileSystem fs = FileSystem.get(conf)) {

/* fs.copyFromLocalFile 第一个参数表示是否删除源文件,第二个参

数表示是否覆盖 */

fs.copyFromLocalFile(false, true, localPath, remotePath);

} catch (IOException e) {

e.printStackTrace();

}

}

/**

* 追加文件内容

*/

public static void appendToFile(Configuration conf, String localFilePath,

String remoteFilePath) {

Path remotePath = new Path(remoteFilePath);

try (FileSystem fs = FileSystem.get(conf);

FileInputStream in = new FileInputStream(localFilePath);) {

FSDataOutputStream out = fs.append(remotePath);

byte[] data = new byte[1024];

int read = -1;

while ((read = in.read(data)) > 0) {

out.write(data, 0, read);

}

out.close();

} catch (IOException e) {

e.printStackTrace();

}

}

/**

* 主函数

*/

public static void main(String[] args) {

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://localhost:9000");

String localFilePath = "/usr/local/hadoop/word.txt"; // 本地路径

String remoteFilePath = "/user/hadoop/test/word.txt"; // HDFS 路径

String choice = "append"; // 若文件存在则追加到文件末尾

// String choice = "overwrite"; // 若文件存在则覆盖

try {

/* 判断文件是否存在 */

boolean fileExists = false;

if (CopyFromLocalFile.test(conf, remoteFilePath)) {

fileExists = true;

System.out.println(remoteFilePath + " 已存在.");

} else {

System.out.println(remoteFilePath + " 不存在.");

}

/* 进行处理 */

if (!fileExists) { // 文件不存在,则上传

CopyFromLocalFile.copyFromLocalFile(conf, localFilePath,

remoteFilePath);

System.out.println(localFilePath + " 已上传至 " + remoteFilePath);

} else if (choice.equals("overwrite")) { // 选择覆盖

CopyFromLocalFile.copyFromLocalFile(conf, localFilePath,

remoteFilePath);

System.out.println(localFilePath + " 已覆盖 " + remoteFilePath);

} else if (choice.equals("append")) { // 选择追加

CopyFromLocalFile.appendToFile(conf, localFilePath,

remoteFilePath);

System.out.println(localFilePath + " 已追加至 " + remoteFilePath);

}

} catch (Exception e) {

e.printStackTrace();

}

}

}