apache hadoop HDFS append design

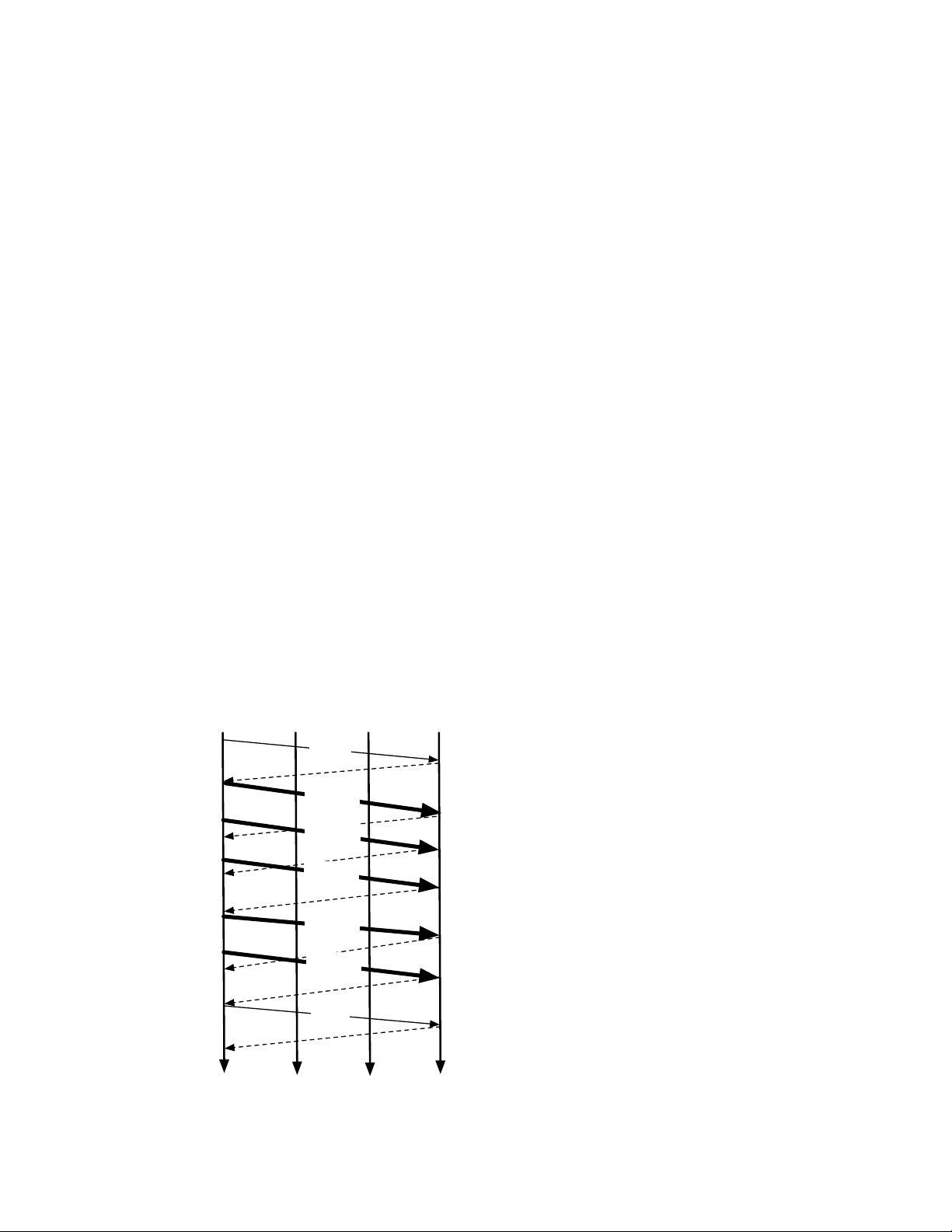

### Apache Hadoop HDFS Append Design #### 设计挑战与解决方案 **1.1 设计挑战** 随着`hflush`功能的引入,Hadoop HDFS(HDFS)面临着一个全新的挑战:如何使未关闭文件的最后一个块对读者可见。这一需求带来了两个主要问题: 1. **读一致性**:在某一时间点上,同一个块的不同副本可能包含不同数量的数据。HDFS应当提供何种程度的一致性保障,并且在发生故障的情况下如何确保这种一致性。 2. **数据持久性**:当任何错误发生时,恢复过程不能简单地丢弃最后一个块。相反,恢复过程必须至少保留已经被`hflush`处理的数据,同时保持读一致性。 **1.2 解决方案概述** 为了应对这些挑战,HDFS设计中引入了新的块状态管理机制以及一系列协议来确保读取一致性和数据持久性。 #### 块副本状态 **2.1 新状态的需求** 在`append/hflush`功能出现之前,一个节点上的块要么是最终状态(finalized),要么是临时状态(temporary)。当创建一个新的块时,它会在节点上处于临时状态;当客户端请求关闭时,如果不再有新的数据写入,则该临时状态的块会变成最终状态。在节点重启时,所有临时状态的块都会被删除,这在没有`append/hflush`功能时是可以接受的,因为HDFS仅提供了对于构建中的块的最佳努力持久性保证。 但是,在支持`append/hflush`之后,HDFS需要为包含预追加数据的构建中块提供强持久性,并为`hflush`后的数据提供最佳努力持久性。因此,一些临时状态的块需要在节点重启后得以保存。 **2.2 块状态(数据节点)** 在数据节点层面,本设计引入了一个“正在写入”(rbw)的状态和其他用于处理错误的状态。具体而言,数据节点内存中的一个块可能处于以下几种状态之一: - **最终状态(Finalized)**:一个最终状态的块已经固定了其数据长度。除非重新打开以进行追加,否则不会再向这个块写入新的数据。其数据和元数据相匹配。 - **正在写入(rbw)**:表示一个正在进行写操作的块,其中包含`hflush`后已确认的数据。当新的数据写入到一个块时,该块会处于此状态。 - **临时状态(Temporary)**:一个块在初次创建时的状态。在客户端完成写入并请求关闭前,该块将保持此状态。 - **损坏状态(Corrupted)**:当检测到块损坏时进入此状态,例如数据校验失败或存储异常。 - **恢复状态(Recovering)**:当一个块正在进行恢复时所处的状态,例如由于节点故障或数据损坏导致的恢复操作。 #### 数据一致性和持久性的实现 **3.1 读一致性实现** 为了保证读一致性,HDFS通过以下机制实现: 1. **版本控制**:每个块都有一个版本号。当数据写入块时,版本号随之增加。读取数据时,客户端可以指定要读取的版本号,从而保证了一致性。 2. **心跳机制**:数据节点定期向名称节点发送心跳消息,报告其状态信息。如果某个副本的版本落后于其他副本,名称节点会触发数据复制或修复操作,以确保所有副本的一致性。 3. **故障恢复机制**:一旦检测到故障,如节点宕机或数据损坏,HDFS会自动启动恢复流程,通过其他副本重建丢失的数据,并更新版本号,确保一致性。 **3.2 数据持久性实现** 为了确保数据的持久性,HDFS采用了以下策略: 1. **多副本存储**:每个块都有多个副本分布在不同的节点上,通常至少有三个副本。即使部分节点失效,也可以从其他节点恢复数据。 2. **日志记录**:数据节点在执行写操作时会记录日志。这些日志可以在节点重启或故障恢复时用于回放,确保数据完整性和一致性。 3. **检查点机制**:名称节点会定期创建元数据的检查点,这样即使名称节点发生故障,也可以从最近的检查点快速恢复元数据信息。 #### 结论 Apache Hadoop HDFS 的`append/hflush`设计解决了读写一致性和数据持久性的问题,确保了分布式文件系统的可靠性和高效性。通过引入新的块状态管理和一系列故障恢复机制,HDFS能够更好地满足大规模数据处理的需求。对于设计类似的分布式文件系统具有重要的参考价值。

剩余18页未读,继续阅读

- 粉丝: 2

- 资源: 8

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功