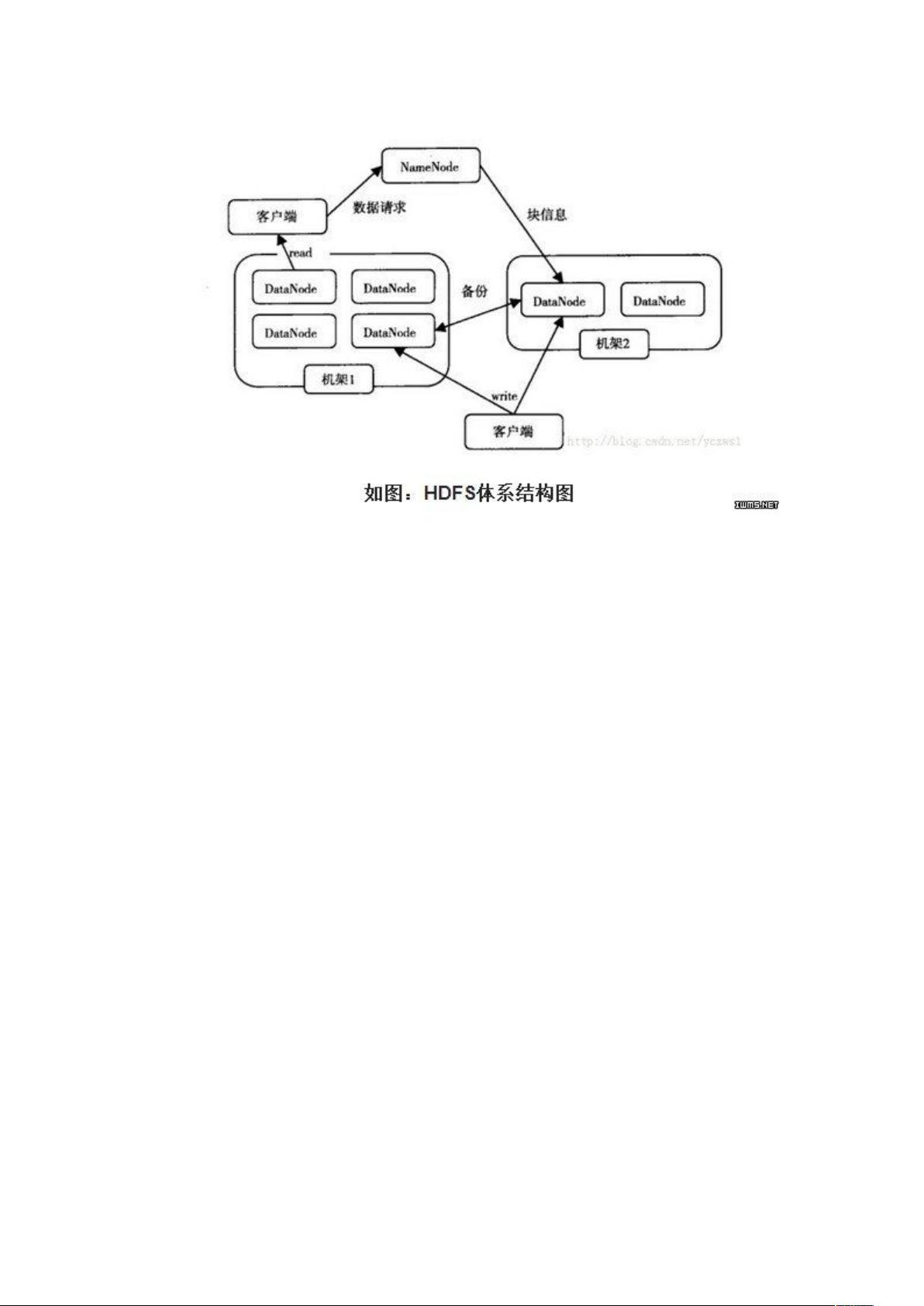

### 详解Hadoop核心架构HDFS #### HDFS体系架构概览 Hadoop作为一个领先的开源分布式计算框架,其核心组成部分之一便是Hadoop Distributed File System(HDFS),它为大规模数据处理提供了高效、可靠且可扩展的存储解决方案。HDFS的设计理念主要侧重于处理大量数据的存储需求,并且能够容忍硬件故障。 ##### 架构组成 HDFS采用了主从结构(Master/Slave)模型。一个完整的HDFS集群包括以下几部分: - **NameNode**:作为集群的主服务器,NameNode负责管理和维护文件系统的命名空间(包括文件和目录的元数据),以及客户端对文件的访问操作。 - **DataNode**:作为集群的从服务器,DataNode负责存储实际的数据块。每个DataNode都会定期向NameNode报告自己的状态。 - **Client**:客户端应用可以通过HDFS API与NameNode交互,进行文件的读写操作。 在最新的Hadoop版本中,为了提高系统的可用性和可靠性,已经支持多个NameNode的配置,这意味着可以在集群中部署多个NameNode以提供更高的容错能力和负载均衡能力。 #### 文件写入过程 文件写入HDFS的过程如下所示: 1. **Client发起请求**:客户端首先向NameNode发送写入文件的请求。 2. **NameNode响应**:NameNode根据文件的大小和块大小配置,返回给客户端一系列DataNode的信息,用于存储文件的不同部分。 3. **客户端写入数据**:客户端将文件分割成多个Block,按照DataNode的地址顺序,依次将Block写入到各个DataNode中。 #### 文件读取过程 文件从HDFS中读取的过程如下: 1. **Client发起请求**:客户端向NameNode发起读取文件的请求。 2. **NameNode响应**:NameNode返回存储该文件的DataNode列表。 3. **客户端读取文件**:客户端直接从DataNode读取文件内容。 #### 数据冗余与可靠性 为了确保数据的安全性和可靠性,HDFS采用了数据块副本机制。每个数据块默认会有三个副本,分布如下: - 第一个副本位于NameNode指定的DataNode上。 - 第二个副本位于与第一个副本不在同一台物理机上的其他DataNode上。 - 第三个副本则位于与第一个副本处于同一Rack内的其他DataNode上。 这样的设计既考虑到了数据安全性(避免单点故障),也兼顾了数据访问效率(减少跨Rack通信带来的延迟)。 #### MapReduce体系架构 MapReduce是Hadoop提供的另一个核心组件,用于处理大规模数据集的分布式并行计算任务。 ##### 架构组成 MapReduce由以下两部分组成: - **JobTracker**:作为主节点,JobTracker负责调度整个作业的任务分配,监控从节点(TaskTracker)的状态,并重新启动失败的任务。 - **TaskTracker**:作为从节点,TaskTracker负责执行具体的Map或Reduce任务,并向JobTracker汇报任务的进度和状态。 当作业被提交时,JobTracker会将作业的配置信息分发给各个TaskTracker,并调度任务的执行。如果JobTracker发生故障,可以将任务重新分配给其他的空闲TaskTracker执行。 ##### 编程模型 MapReduce提供了简单的编程接口,允许开发者通过编写Map和Reduce两个函数来处理数据。Map函数负责将输入数据转换为键值对,而Reduce函数则对具有相同键的值进行聚合处理。这种编程模型使得开发者能够专注于业务逻辑而非分布式细节,大大简化了开发过程。 HDFS和MapReduce共同构成了Hadoop的核心组件,它们之间相互协作,为大数据处理提供了强大的支持。HDFS为大规模数据提供了可靠的存储服务,而MapReduce则提供了高效的数据处理能力。两者结合,使得Hadoop能够在分布式环境中处理海量数据成为可能。

剩余8页未读,继续阅读

- 粉丝: 2

- 资源: 92

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功