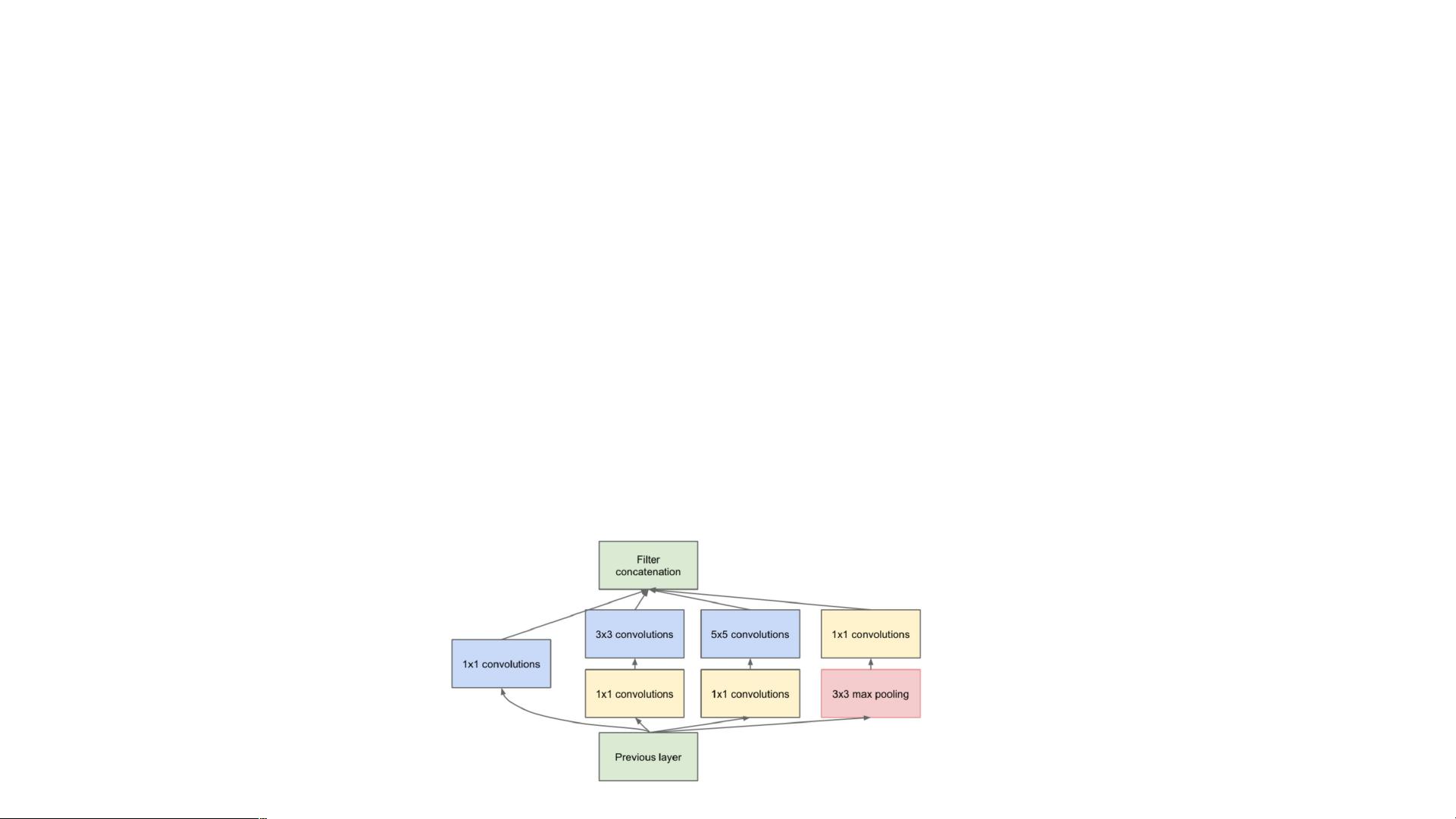

深度学习中的注意力机制 深度学习中的注意力机制是指在神经网络中引入选择性关注输入信息的机制,以从大量信息中筛选出重要的信息。这种机制源于对人类视觉的研究,人类视网膜的不同部位具有不一样的信息处理能力,人类需要选择视觉区域中的特定部分,然后重点关注它。 注意力机制最早用于自然语言处理领域(NLP),后来在计算机视觉领域(CV)也得到广泛的应用。注意力机制没有严格的数学定义,例如传统的局部图像特征提取、滑动窗口方法等都可以看作是一种注意力机制。在神经网络中,注意力机制通常是一个额外的神经网络,能够硬性选择输入的某些部分,或者给输入的不同部分分配不同的权重。 在卷积神经网络中引入注意力机制有很多方法,以空间维度增加引入attention机制(如inception网络的多尺度,让并联的卷积层有不同的权重),也可以在通道维度(channel)增加attention机制,当然也有混合维度即同时在空间维度和通道维度增加attention机制。 SEnet模型就是一个典型的例子,该模型是在通道维度增加注意力机制的论文是获得了2017年最后一届ImageNet比赛图像分类冠军的模型。SEnet模型的关键操作是squeeze和excitation,通过自动学习的方式获取到每个特征通道的重要程度,然后用这个重要程度去给每一个特征通道赋予一个权重值,从而让神经网络重点关注某些特征通道。 squeeze操作是将每个通道的二维特征(H×W)压缩为1个实数,论文是通过平均值池化的方式实现。这属于空间维度的一种特征压缩,因为这个实数是根据二维特征所有值算出来的,所以在某种程度上具有全局的感受野,通道数保持不变,所以通过squeeze操作后变为1×1×C。 excitation操作是通过参数来为每个特征通道生成一个权重值,对于权重值是如何生成就很关键,论文是通过两个全连接层组成一个Bottleneck结构去建模通道间的相关性,并输出和输入特征同样数目的权重值。 Scale操作是将前面得到的归一化权重加权到每个通道的特征上,论文中的方法是用乘法,逐通道乘以权重系数,完成再通道维度上引入注意力机制。 注意力机制是在神经网络中引入选择性关注输入信息的机制,以从大量信息中筛选出重要的信息。SEnet模型是引入注意力机制的一个典型例子,通过squeeze、excitation和Scale三种操作来引入注意力机制,从而提高神经网络的性能。

剩余9页未读,继续阅读

- 粉丝: 3

- 资源: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0