SVD算法

以下内容来源于参考文献,仅供学习交流

一、什么是SVD算法

奇异值分解(Singular Value Decomposition,以下简称SVD)是在机器学习领域广泛应用的算法,它不光可以用于降维算法中的特征分解,还可以用于推荐系统,以及自然语言处理等领域。是很多机器学习算法的基石

二、SVD算法的应用

隐形语义索引:最早的SVD应用之一就是信息检索,我们称利用SVD的方法为隐性语义检索(LSI)或隐形语义分析(LSA)。

基于SVD的图像压缩、基于协同过滤的推荐引擎、利用SVD简化数据

可应用于优化类问题,路径、空间最优化问题

三、SVD代码的实现

import math

import random

import matplotlib.pyplot as plt

#求平均值

def Average(fileName):

fi = open(fileName, ‘r’)

result = 0.0

cnt = 0

for line in fi:

cnt += 1

arr = line.split()

result += int(arr[2].strip())

ret

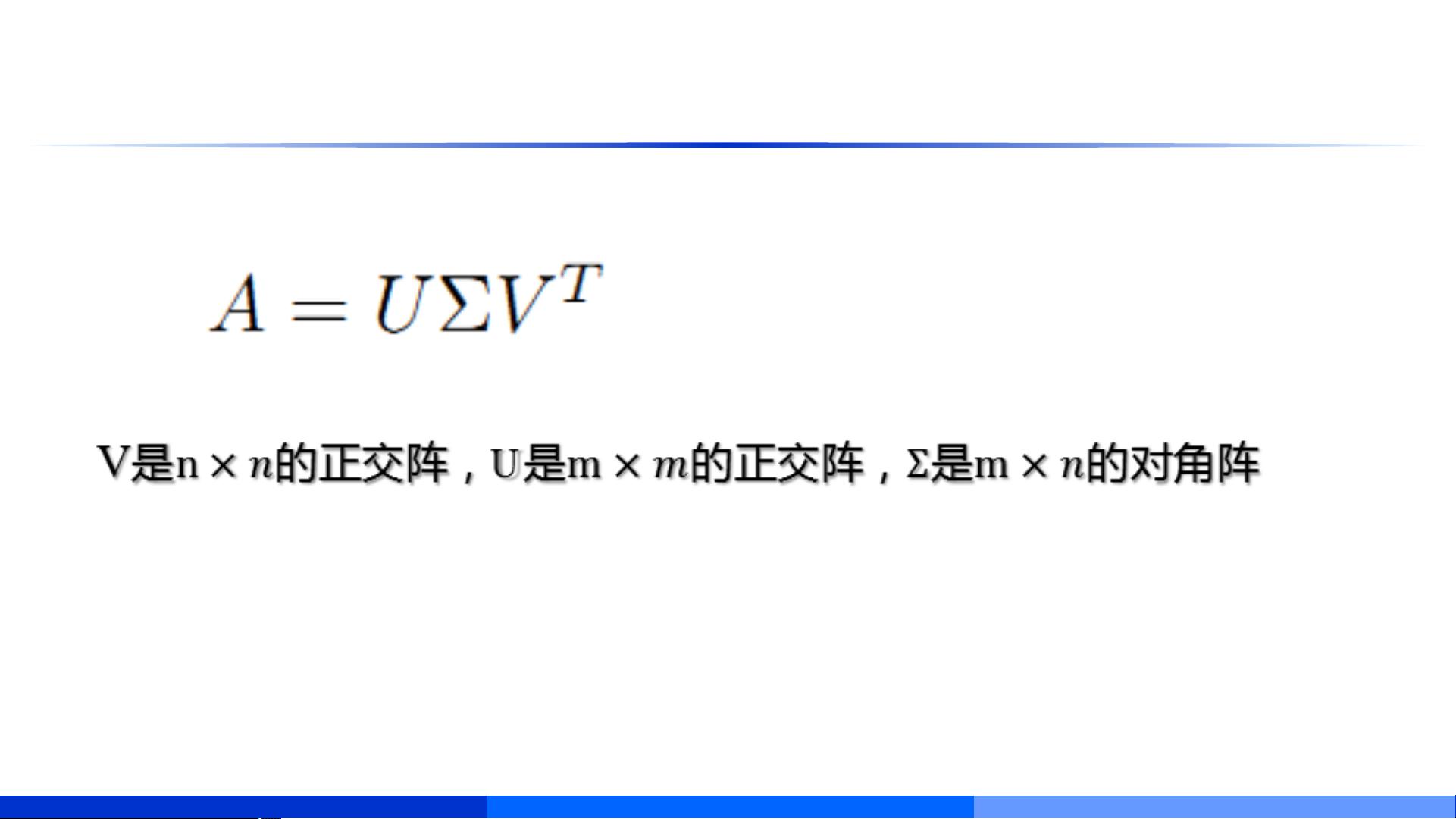

奇异值分解(SVD,Singular Value Decomposition)是一种在数学和计算机科学中广泛使用的线性代数技术,尤其在机器学习和大数据分析领域扮演着重要角色。SVD能够将一个矩阵分解为三个矩阵的乘积,即 \( A = U \Sigma V^T \),其中 \( A \) 是原始矩阵,\( U \) 和 \( V \) 是正交矩阵,而 \( \Sigma \) 是对角矩阵,包含了矩阵 \( A \) 的奇异值。

1. **SVD简介**

- 奇异值分解是将任意矩阵 \( A \) 分解成三个矩阵的乘积,每个矩阵都有特定的数学特性。这种分解方式能够揭示矩阵的内在结构,有助于数据的降维和分析。

- 在推荐系统中,SVD被用来进行矩阵分解,通过对用户-商品评分矩阵进行分解,寻找隐藏的潜在因素,进而预测用户对未评分商品的喜好。

2. **SVD计算**

- 计算SVD通常涉及计算矩阵的特征值和特征向量,然后构造相应的正交矩阵和对角矩阵。

- 例如,对于一个简单的2x2矩阵 \( A \),SVD可能表示为 \( A = U \Sigma V^T \),其中 \( U \) 和 \( V \) 是单位正交矩阵,\( \Sigma \) 是一个对角矩阵,其对角线元素为矩阵 \( A \) 的奇异值。

3. **SVD推荐算法**

- 在推荐系统中,SVD被用于矩阵因子分解,即将用户-商品评分矩阵 \( R \) 分解为两个低秩矩阵 \( P \) 和 \( Q \) 的乘积,\( R \approx P \times Q \)。

- 目标是找到最佳的 \( P \) 和 \( Q \),使它们的乘积尽可能接近实际评分矩阵 \( R \),从而预测未知的评分。

- 优化过程通常通过最小化预测评分与实际评分之间的误差平方和(SSE)来实现,可以通过梯度下降法或交替最小二乘法等优化算法进行。

4. **RSVD(Regularization SVD)**

- 为了防止过拟合,即模型过度适应训练数据,通常会在SSE中引入正则化参数(L2范数惩罚项),以限制 \( P \), \( Q \), \( Bu \), 和 \( Bi \) 的大小。

- RSVD考虑了用户和商品的固有属性,添加了用户偏置 \( bu \) 和商品偏置 \( bi \),以更准确地预测评分,更新规则相应调整。

5. **带偏置的SVD**

- 用户对商品的评分不仅受用户和商品之间关系的影响,还受到用户和商品自身特性的影响。因此,评分预测会包含总体平均分、用户偏置和商品偏置。

- 在训练过程中,不仅要更新 \( P \) 和 \( Q \),还需要更新 \( Bu \) 和 \( Bi \),以适应这些偏置项。

6. **SVD的编程实现**

- SVD的实现通常涉及读取数据、初始化参数、迭代优化以及计算和评估预测结果。提供的Python代码示例展示了如何计算平均值,这在处理数据预处理时是常见的操作。

在实际应用中,SVD推荐算法通常结合数据集如咪咕或MovieLens进行训练和验证,通过10折交叉验证来评估模型的性能。通过不断迭代优化,SVD能够有效地挖掘隐藏在大量用户行为数据下的模式,从而为用户提供个性化的推荐。