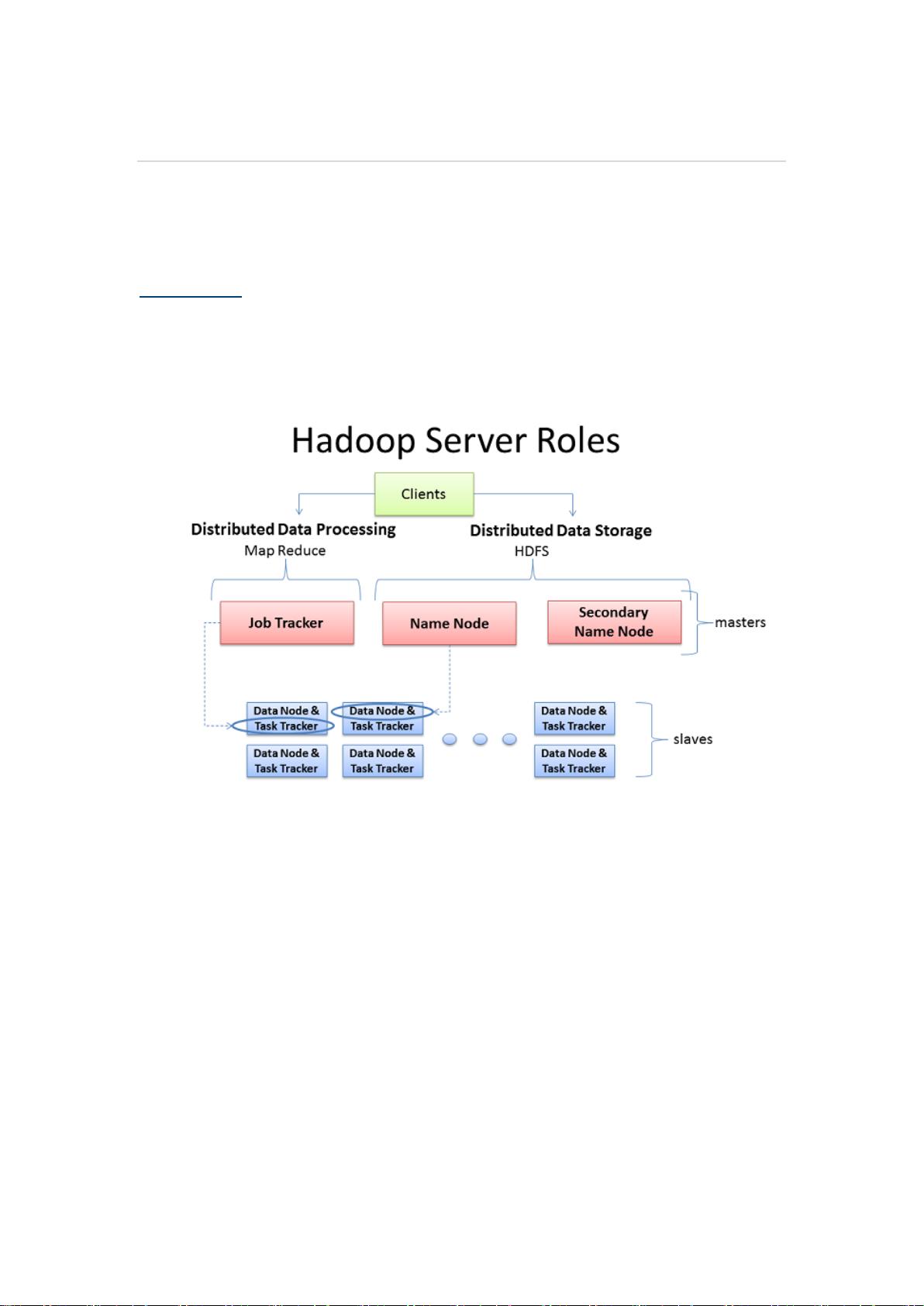

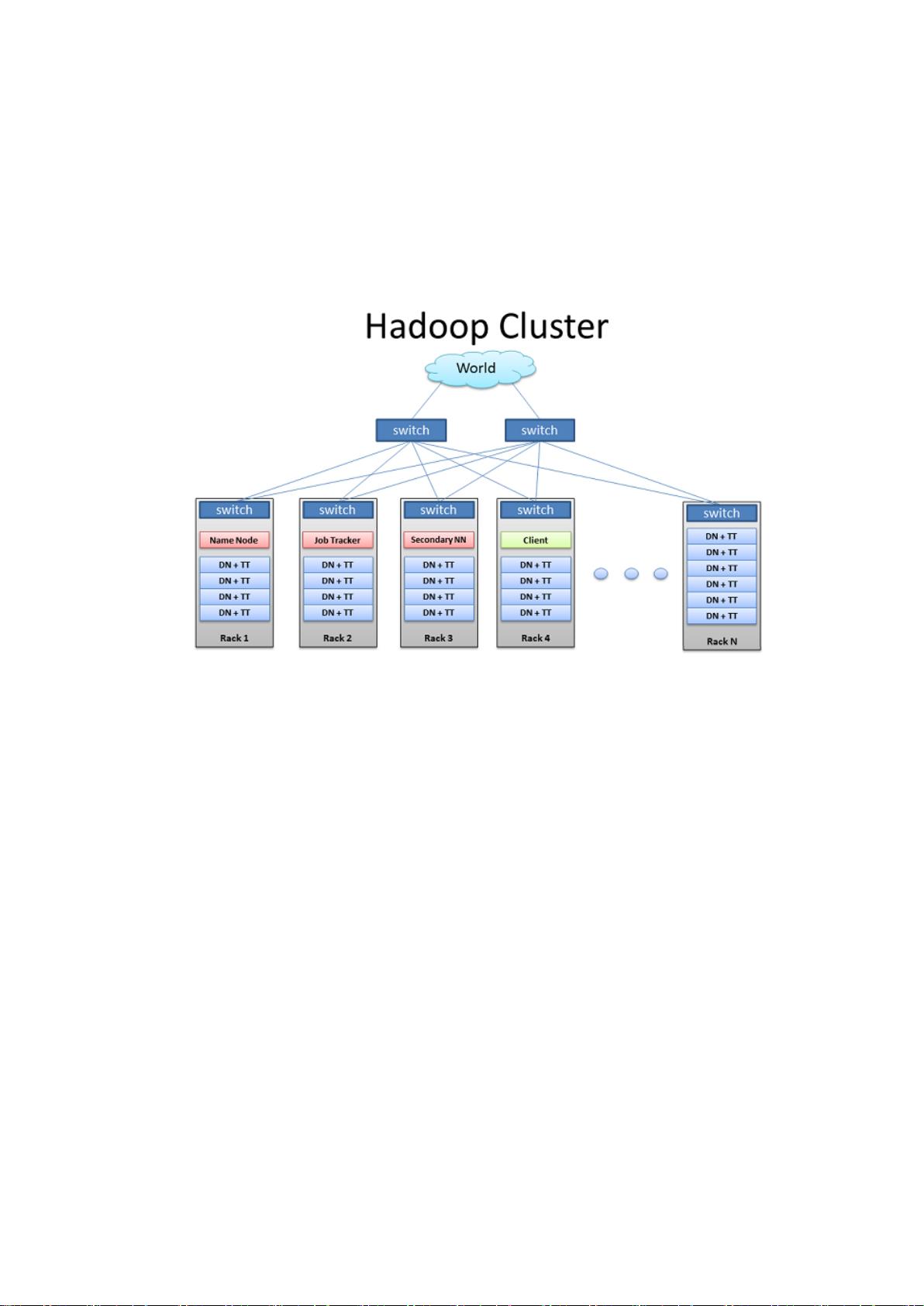

Hadoop集群是大数据处理领域的核心技术之一,它能够在分布式的环境中处理大量数据。深入了解Hadoop集群的体系结构和网络关系对于有效利用Hadoop处理数据具有重要意义。 要了解Hadoop集群的工作原理。Hadoop的主要任务部署在三个部分:Client机器、主节点(NameNode和JobTracker)和从节点(DataNode)。主节点负责监督Hadoop的关键功能模块HDFS(Hadoop分布式文件系统)和MapReduce。HDFS的NameNode负责监控和调度数据存储,而MapReduce的JobTracker负责监控和调度数据的并行处理。从节点负责数据的存储和计算任务,每个从节点既是数据节点,也负责与主节点通信的守护进程。 Client机器负责将数据加载到集群中,并提交MapReduce数据处理的作业描述。之后,Client从集群中获取或查看处理后的结果。在小型集群中,一个物理设备可能同时承担JobTracker和NameNode的角色。但在大型集群中,一般采用独立服务器分别处理单一任务,以避免性能损耗。 Hadoop集群通常在Linux系统上运行,直接操作底层硬件,通常不需要虚拟服务器和管理层,这样可以避免额外的性能损耗。Hadoop集群通过机架和机架式服务器连接,一般使用1GB或2GB的网络带宽。虽然10GB带宽不常见,但能显著提高CPU核心和磁盘驱动器的效率。 Hadoop的工作流程包括数据的加载、并行处理和结果的存储。以分析客服部门的电子邮件中“Refund”出现的次数为例,Client将数据加载到集群中,提交数据处理描述,然后集群将处理结果存储在新文件中,Client读取结果。在这个过程中,Client将数据分割成小块并分发到集群中的不同机器。为了防止数据丢失,Hadoop默认将每块数据复制三次。 Hadoop集群对机架配置有“机架感知”(RackAwareness)的能力,即管理员可以定义机架的数量。这样做的目的是为了预防数据丢失和提高网络性能。为了防止数据丢失,Hadoop会将数据在不同机架的多个节点上复制存储。 Hadoop的存储机制依赖于NameNode和DataNode。NameNode存储文件系统的元数据,包括文件目录结构、每个文件的块列表和块存储位置的映射。DataNode则实际存储数据块,并向NameNode报告它们的状态。HDFS保证了高吞吐量数据访问,并可以部署在廉价的硬件上。 此外,Hadoop MapReduce作业的调度包括作业提交、任务分配、任务执行和结果收集等步骤。作业被提交到JobTracker,然后被分解为多个任务。任务分配给TaskTracker,并在DataNode上执行。每个TaskTracker节点执行分配给它的任务,并返回处理结果到JobTracker。 Hadoop集群的网络设计对其性能有着直接的影响。网络的带宽、延迟和可靠性都会影响到数据处理的效率。因此,设计Hadoop集群时,需要优化网络性能,减少数据传输的瓶颈。 Hadoop集群在实际部署时需要考虑扩展性、容错性和维护性。对于大规模的Hadoop部署,还需要考虑能耗和冷却等问题。Hadoop集群的维护包括监控集群状态、故障诊断和恢复等,以确保集群的稳定运行。

剩余17页未读,继续阅读

yutao3142018-03-03写的不错,中文的,加油

yutao3142018-03-03写的不错,中文的,加油

- 粉丝: 23

- 资源: 14

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功