人工智能领域深度学习的选择性详解.pdf

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

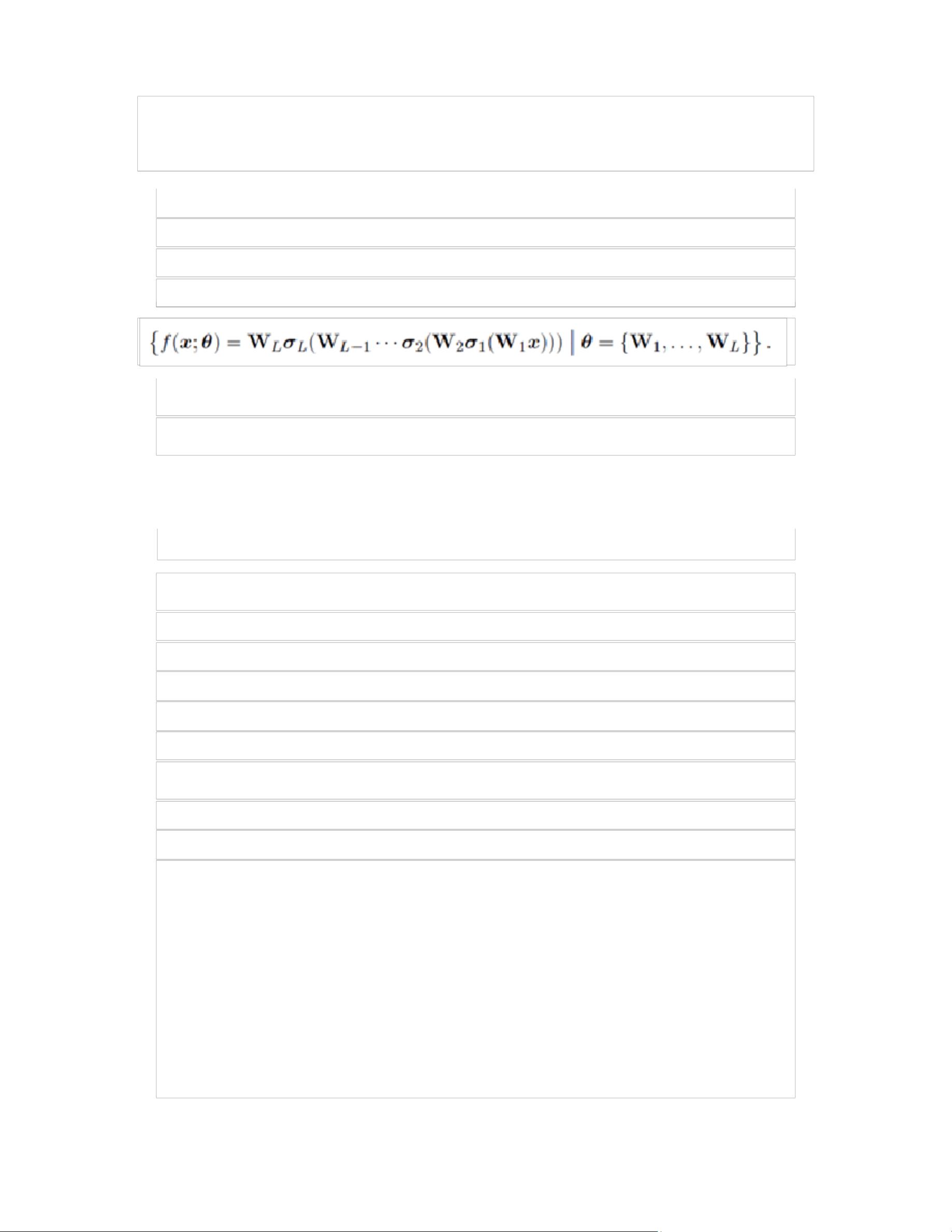

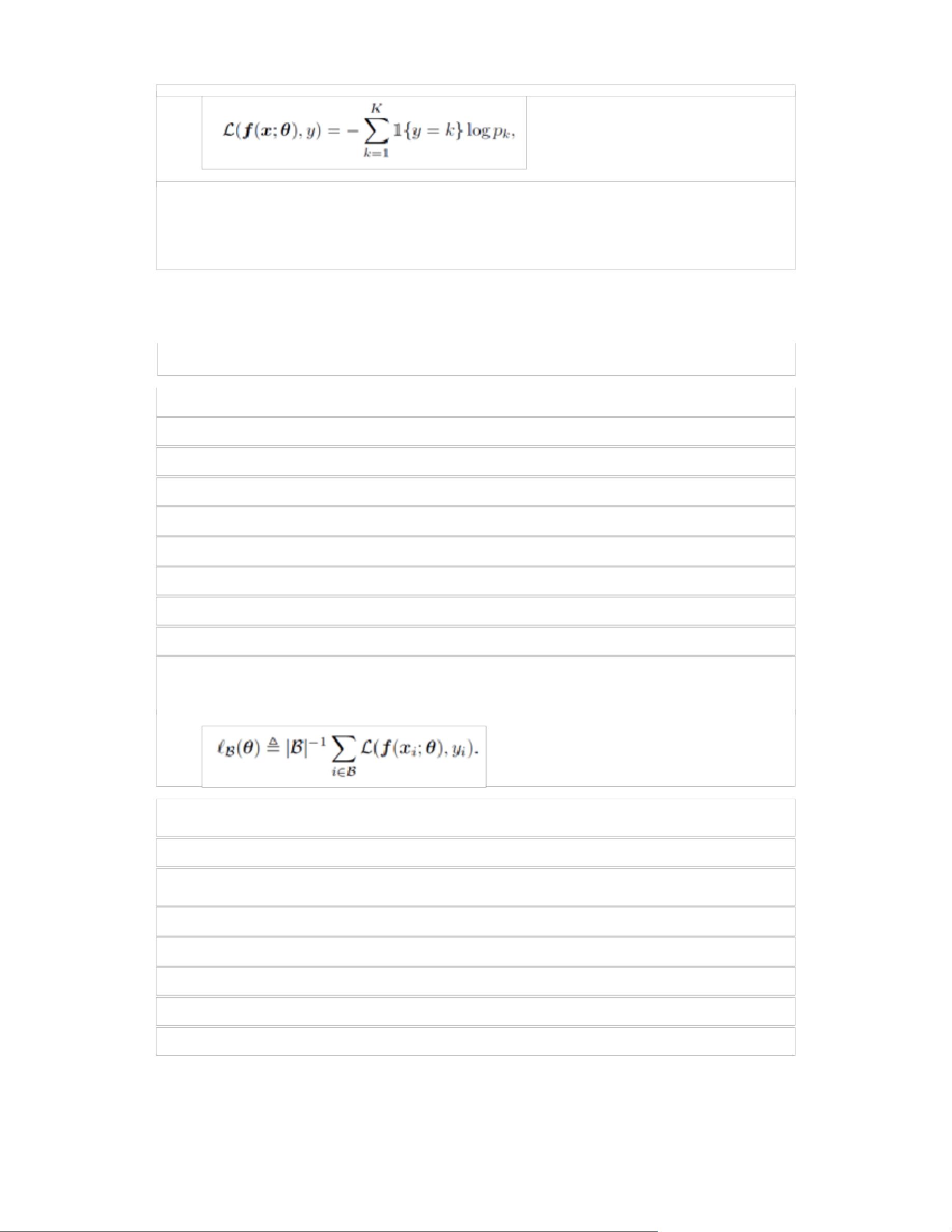

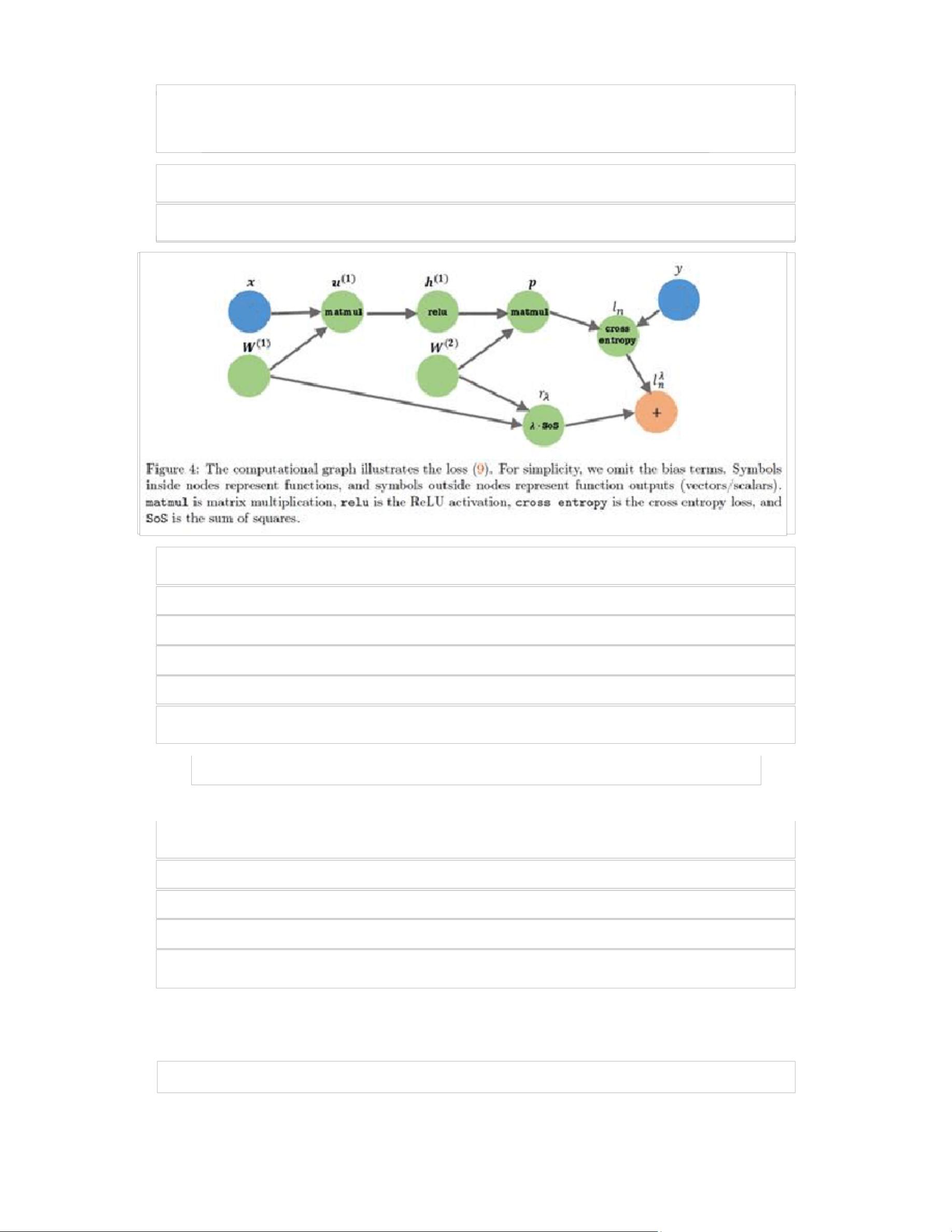

深度学习是人工智能领域的重要分支,它通过构建深层的神经网络模型来解决复杂的学习任务,尤其在图像识别、语音识别和自然语言处理等方面取得了显著成果。本文将深入探讨深度学习的特性、理论基础以及训练方法。 深度学习的核心在于其深度结构,这使得网络能够通过多层非线性转换学习到复杂的特征表示。相比于浅层模型,深度网络通过增加网络层数而非宽度,能够更有效地提取数据的代表性特征。这种深度结构不仅提高了模型的表达能力,而且有助于减少近似误差和估计误差。 深度学习的另一个显著特点是过度参数化,即模型的参数数量远大于训练样本的数量。尽管这可能导致过拟合,但在实践中,通过使用正则化技术,如 dropout 或批量归一化,以及利用大规模数据集,深度学习模型能够避免过拟合并保持良好的泛化性能。此外,深度学习的训练过程通常依赖于强大的计算资源,特别是图形处理单元(GPU)集群,它们能够加速模型的训练过程。 在深度学习的训练过程中,优化算法起着关键作用。随机梯度下降(SGD)是最常用的优化方法,它通过迭代更新参数来最小化损失函数。SGD每次仅使用一小部分数据(mini-batch)进行更新,从而降低了计算成本并加快了训练速度。反向传播算法是计算神经网络梯度的关键工具,它利用链式规则沿着计算图反向传播误差,以更新各个层的权重。 在理论层面,深度学习的理论基础仍在发展中。尽管深度学习在实践中表现出色,但对于为何深度模型能在大量数据上达到低预期风险,理论解释尚不完善。现有的分析通常将深度学习的性能分解为近似误差和估计误差两部分。近似误差衡量模型对目标函数的表示能力,而估计误差则反映了从训练数据到未知数据的泛化性能。深度学习的优势在于这两部分误差都相对较小。 前馈神经网络(FNN)或多层感知器(MLP)是深度学习的基础模型,由多个隐藏层和激活函数组成。常见的激活函数包括ReLU、leaky ReLU和sigmoid等,它们引入非线性以增强模型的表达力。损失函数的选择取决于任务类型,例如分类问题通常采用交叉熵损失。训练过程中,反向传播算法与SGD结合,通过计算图进行高效的梯度计算和参数更新。 深度学习是一种强大且广泛应用于现代AI的技术,它通过构建深度神经网络模型来学习复杂的数据表示。尽管其理论基础尚待完善,但通过优化算法、大量的数据和强大的计算资源,深度学习已经在诸多领域展现了卓越的性能。未来的研究将继续探索深度学习的理论基础,以更好地理解其工作原理并进一步提升其性能。

剩余31页未读,继续阅读

- 粉丝: 6797

- 资源: 3万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 【岗位说明】电商公司各岗位的岗位说明书.docx

- 【岗位说明】电商公司各职位说明书.doc

- 【岗位说明】电商美工岗位职责.doc

- 【岗位说明】电商美工主管的岗位职责.docx

- 【岗位说明】电商文案策划专员职位说明书.docx

- 【岗位说明】电商公司各部门各岗位职责及岗位考核.docx

- 【岗位说明】电商客服岗位职责.docx

- 【岗位说明】设计部部门职责及岗位职责说明书.docx

- 【岗位说明】淘宝天猫各岗位说明书电商运营必备工具说明.doc

- 【岗位说明】电商运营主管岗位职责.doc

- 【岗位说明】电商平台运营岗位职责.docx

- 【岗位说明】电子商务岗位职责.docx

- 【岗位说明】美工岗位职责.doc

- 【岗位说明】淘宝天猫组织架构及部分职位职责.docx

- 《3ds+Max应用》01+学习任务一++亲密接触三维动画写字字帖.ppt

- 热合自动设备sw16全套技术资料100%好用.zip

信息提交成功

信息提交成功