大数据实验报告 (5).pdf

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

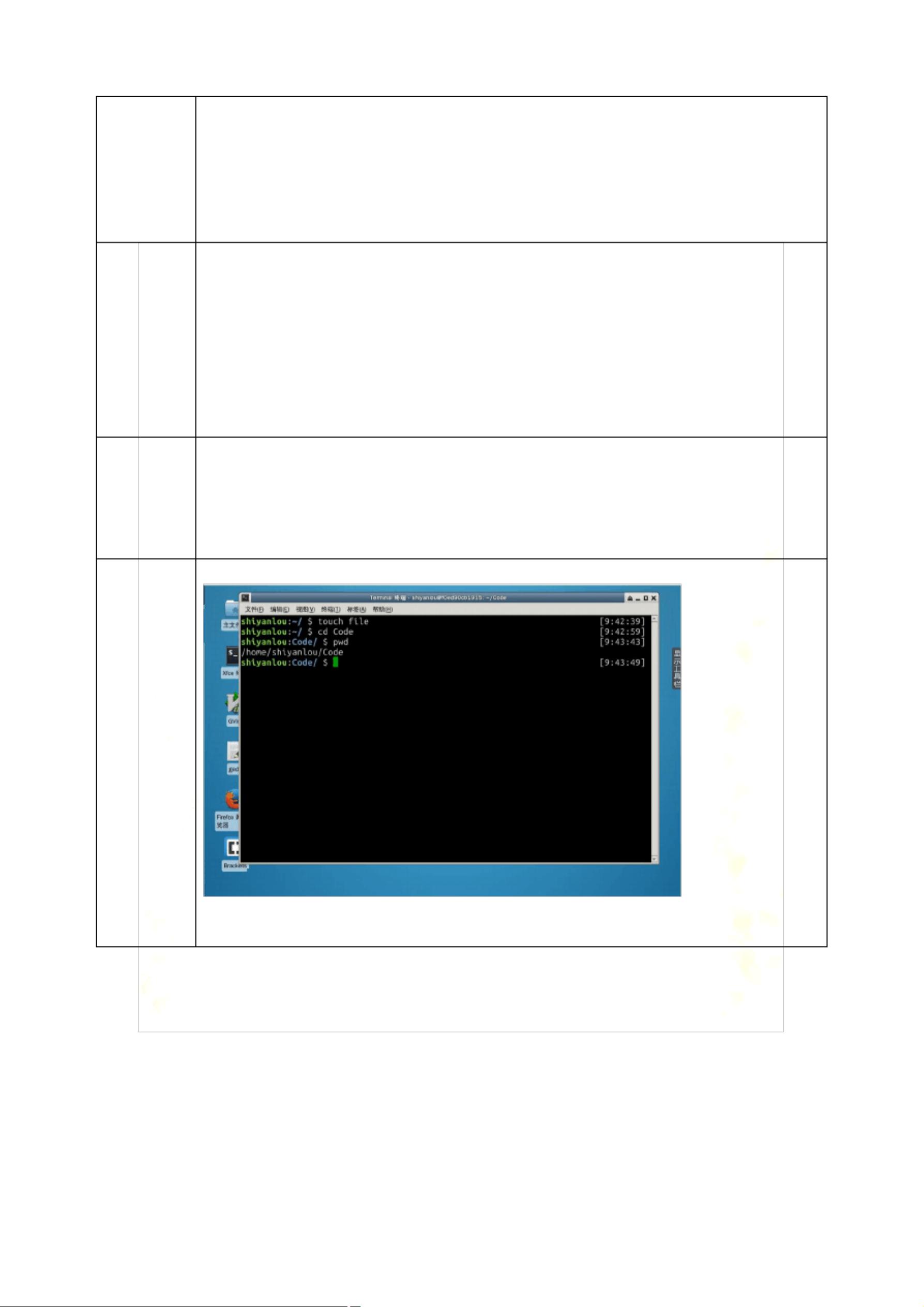

【大数据实验报告】 本次实验主要涉及了两个核心知识点:Linux操作系统和Hadoop的大数据处理框架。我们从Linux的基本操作入手,理解其系统发展历史、基本概念和操作,包括用户及文件权限管理,以及目录结构和文件操作。然后,我们深入到Hadoop的世界,学习了Hadoop的安装配置和基本操作。 ### Linux操作系统 #### 1. Linux操作系统发展历史与基本概念 Linux是一种开源的、类UNIX的操作系统,起源于1991年Linus Torvalds开发的内核。它具有稳定性高、安全性好、可定制性强等特点,广泛应用于服务器、嵌入式设备和超级计算机等领域。 #### 2. Linux用户及文件权限管理 在Linux中,用户和用户组是权限管理的基础。通过`adduser`和`groupadd`命令可以创建用户和用户组,`usermod`用于修改用户属性。文件权限通过chmod命令调整,包括读(r)、写(w)和执行(x)三个权限位,分别对应数字4、2和1,通过组合这些数字可以设置用户和用户组的权限。 #### 3. Linux文件操作 文件操作包括创建、删除、复制、移动和重命名等。`touch`用于创建文件,`rm`删除文件,`cp`和`mv`分别用于复制和移动文件,`rename`或`mv`用于重命名。文件权限查看常用`ls -l`,`ls -A`显示隐藏文件,`ls -d`显示目录自身而非其内容,`ls -S`按大小排序。 ### Hadoop大数据处理框架 #### 1. Hadoop单机模式与伪分布式模式 Hadoop提供单机模式(本地模式)供开发者测试,无需配置复杂的集群环境。伪分布式模式则在一个节点上模拟多节点集群,方便学习和调试。 #### 2. Hadoop的安装与配置 安装Hadoop涉及到下载源码、解压、配置环境变量、修改配置文件(如core-site.xml、hdfs-site.xml等)和格式化HDFS。在配置文件中,如`core-site.xml`中设置HDFS的默认FS,`hdfs-site.xml`中配置HDFS的相关参数。 #### 3. Hadoop的启动与测试 成功配置后,通过`start-dfs.sh`和`start-yarn.sh`启动Hadoop服务。验证安装是否成功,可以使用Hadoop提供的命令如`hadoop fs -ls`查看HDFS文件系统内容。 实验中,学生通过学习和实践,掌握了Linux的基本操作和Hadoop的安装配置,但在实验过程中遇到了问题,如Java JDK的下载、Hadoop环境配置和编译等问题。这些问题的解决过程体现了自我学习和解决问题的能力,也暴露出一些需要进一步学习和研究的领域。 总结来说,本次实验旨在通过实际操作,使学生理解Linux系统的基本操作和Hadoop的大数据处理流程,为后续深入学习大数据技术打下坚实基础。在实践中发现问题并解决问题,是学习过程中的重要环节,也是提升技能的有效方式。

剩余20页未读,继续阅读

- 粉丝: 6789

- 资源: 3万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功