PySpark 原理解析.docx

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

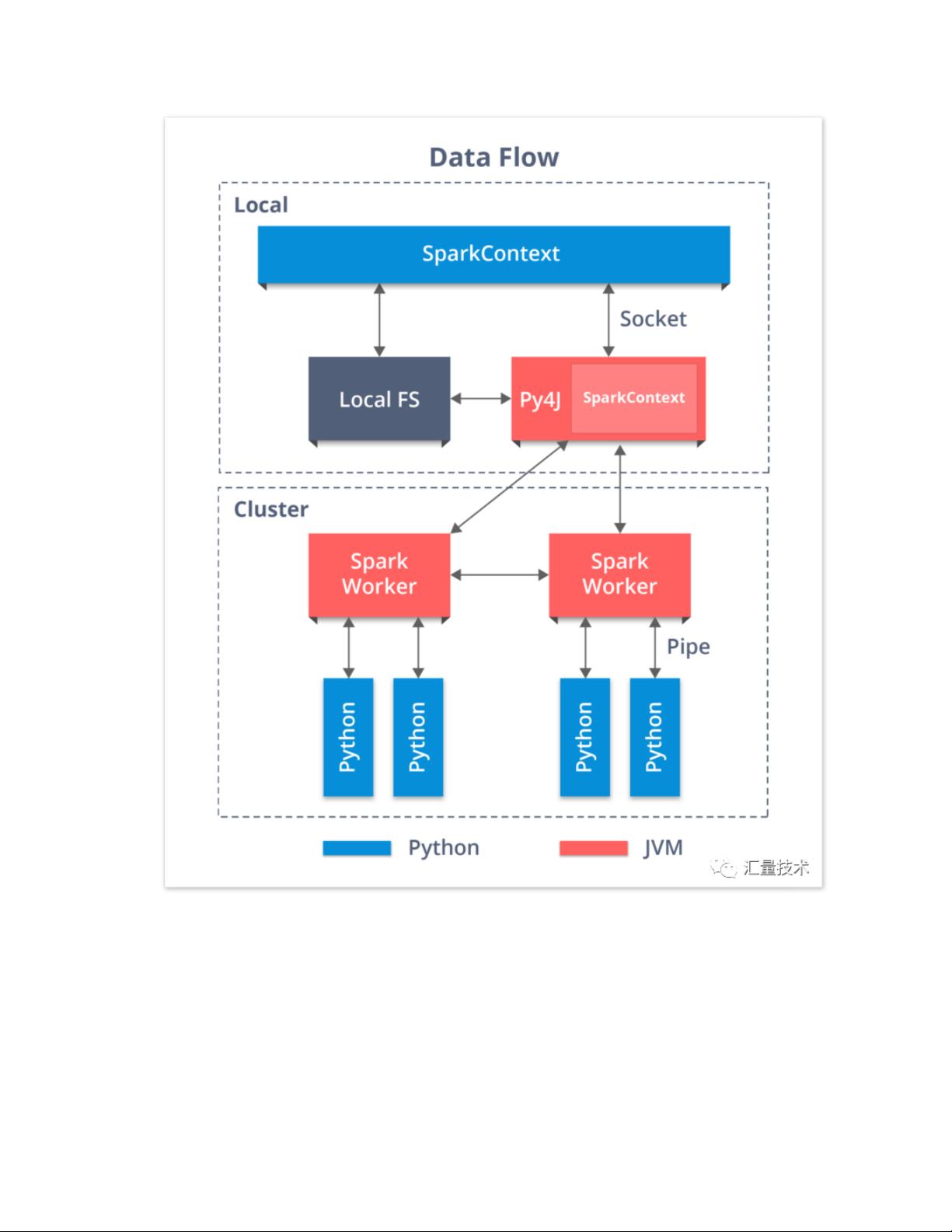

PySpark 是 Apache Spark 的 Python API,它允许开发者使用 Python 编写 Spark 应用程序,享受 Spark 的分布式计算能力。PySpark 的核心在于如何在 Python 和 JVM 之间进行交互,以便利用 Spark 的 Scala 和 Java 实现。以下是 PySpark 的工作原理和主要组件的详细解析。 1. **多进程架构**: PySpark 使用了 Python 和 JVM 进程分离的架构,这意味着在 Driver 和 Executor 端都有 Python 和 JVM 的进程。当通过 `spark-submit` 提交 PySpark 作业时,Driver 端的 Python 脚本会启动并与 JVM 进行交互。Executor 端则由 Driver 启动 JVM 进程,然后在 JVM 中启动 Python 子进程来执行 Python 用户定义的函数(UDF)。 2. **Py4j**: Py4j 是一个 Python 到 Java 的通信库,用于在 Python 程序中调用 Java 类和方法。在 PySpark 中,Py4j 负责在 Python 端和 JVM 端之间建立安全的通信通道。例如,当在 Python 中创建 `SparkContext` 对象时,Py4j 会启动 JVM 并创建 Scala 端的 `SparkContext` 对象。 3. **启动 JVM**: 在 `python/pyspark/context.py` 的 `_ensure_initialized` 函数中,PySpark 使用 `launch_gateway` 来启动 JVM 进程。这个过程通常通过 Spark 的 `spark-submit` 脚本来进行,确保 JVM 使用正确的类路径和环境设置。 4. **Java Gateway**: `JavaGateway` 是 Py4j 提供的一个关键组件,它允许 Python 进程与 JVM 进程通信。在 `python/pyspark/java_gateway.py` 中,通过 `JavaGateway` 创建一个连接到 JVM 的实例,并导入 Spark 相关的 Java 类,如 `SparkConf`, `SparkContext`, `DataFrame` 等,以便在 Python 中使用。 5. **进程间通信**: 在 Executor 端,Python UDF 的执行通过 socket 进行进程间通信。Driver 端的 JVM 启动 Executor 的 JVM 进程,然后 Executor 的 JVM 会启动 Python 子进程,执行 Python 代码。这种通信方式允许 PySpark 在分布式环境中高效地处理数据。 6. **RDD 和 DataFrame 操作**: 在 PySpark 中,RDD(弹性分布式数据集)和 DataFrame 的操作实际上是通过 Py4j 调用 Java 接口实现的。这些操作包括转换、过滤、聚合等,最终由 Spark 的优化器生成执行计划并在集群中执行。 7. **性能考虑**: 尽管 PySpark 提供了 Python 的便利性,但 Python 的 GIL(全局解释器锁)可能会限制并发性能。为了解决这个问题,PySpark 会在 Executor 端并行运行 Python 任务,每个任务在一个独立的 Python 进程中执行。 8. **资源管理**: Spark 的资源管理是通过 YARN 或 Mesos 等集群管理器进行的,它们负责分配和调度 Executor,确保作业能够有效利用集群资源。 PySpark 结合了 Python 的易用性和 Spark 的高性能分布式计算能力,通过 Py4j 和进程间通信机制实现了 Python 与 JVM 之间的无缝协作。理解和掌握这些原理对于编写高效、可靠的 PySpark 应用程序至关重要。

剩余13页未读,继续阅读

- 粉丝: 0

- 资源: 7万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功