项目介绍9.doc

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

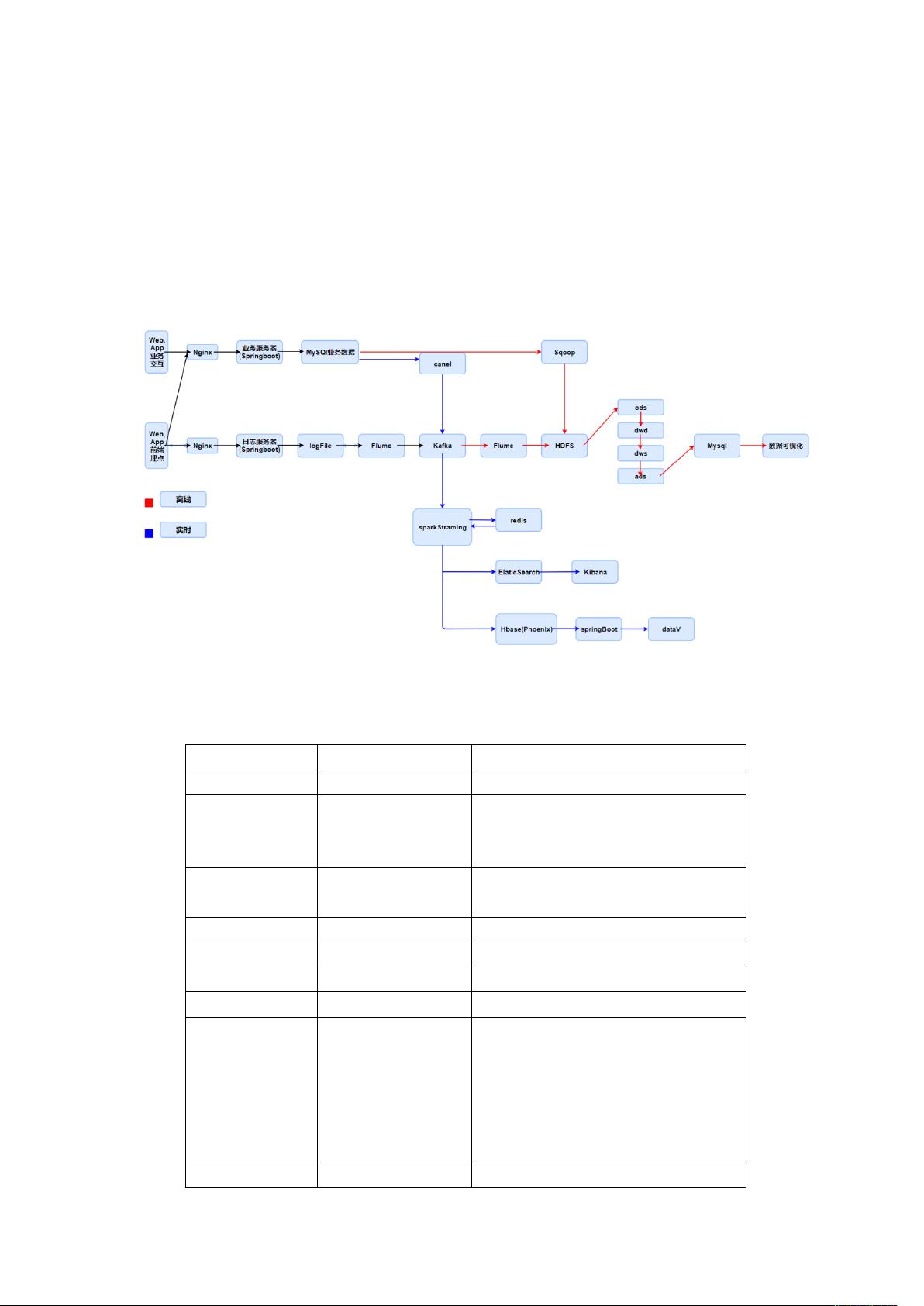

【大数据项目介绍与面试辅导】 在大数据领域,项目经验和面试准备是至关重要的。自我介绍时,可以强调你在大学期间积累的计算机基础知识,如Java SE、MySQL、Web开发以及数据结构和算法,这些基础为理解大数据提供了必要的背景。通过实习经历,你接触到了数据仓库、用户画像和推荐系统,进一步激发了你对大数据的兴趣。你选择学习Hadoop、Hive、Flume、Kafka、Spark、HBase等大数据技术,并关注新兴的Flink,这些是当前大数据处理的关键组件。 在实际工作中,你参与了一个电商数仓项目,项目主要分为三部分:数据平台搭建、数据仓库搭建及离线计算系统、实时计算系统。这涵盖了大数据处理的全链条,包括数据采集、存储、处理和分析。 在服务器规划阶段,针对10台服务器的大数据集群,你需要考虑物理机与云主机的选择。在这个例子中,公司选择了阿里云的云主机,因为它可以提供类似配置而无需专门的运维人员。接着是集群规划,你需要统计数据量,例如用户行为日志、Kafka中的数据、Flume数据和业务数据,并计算出所需存储空间。在本例中,总需求约为78TB,这决定了需要10台服务器。计算能力方面,20核CPU和400线程可以处理大量数据,而1280GB内存可以支持大约87GB的数据处理。 集群搭建时,考虑到高可用性、资源效率和便利性,你可能需要配置NN和MySQL的高可用,将ZK和KF部署在同一节点,以及合理分配Spark、Hive、MySQL等服务的安装位置。此外,离线测试集群通常配置为生产环境的一半,并且在测试环境中,大多数服务仅安装在3台服务器上。 在项目架构和技术选型上,你需要明确每个组件的作用,如Hadoop用于分布式存储和计算,Flume用于日志收集,Kafka作为消息中间件,Hive提供数据分析,MySQL存储元数据,Spark进行大数据处理,ES提供搜索引擎功能,而Azkaban则用于工作流管理。每个组件的版本选择也至关重要,例如Hadoop 3.1.3和Flume 1.9.0分别带来了断点续传等功能优化。 面试时,你可以围绕这些知识点来展示你的项目经验、技术理解和问题解决能力。对于大数据工程师来说,理解整个大数据生态系统,掌握各个组件的工作原理和协同方式,以及如何根据业务需求进行系统规划和优化,都是面试中需要展现的关键技能。同时,能够清晰地阐述项目经历,特别是面对挑战时的解决方案,会让你在面试中脱颖而出。

剩余34页未读,继续阅读

- 粉丝: 7w+

- 资源: 173

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功