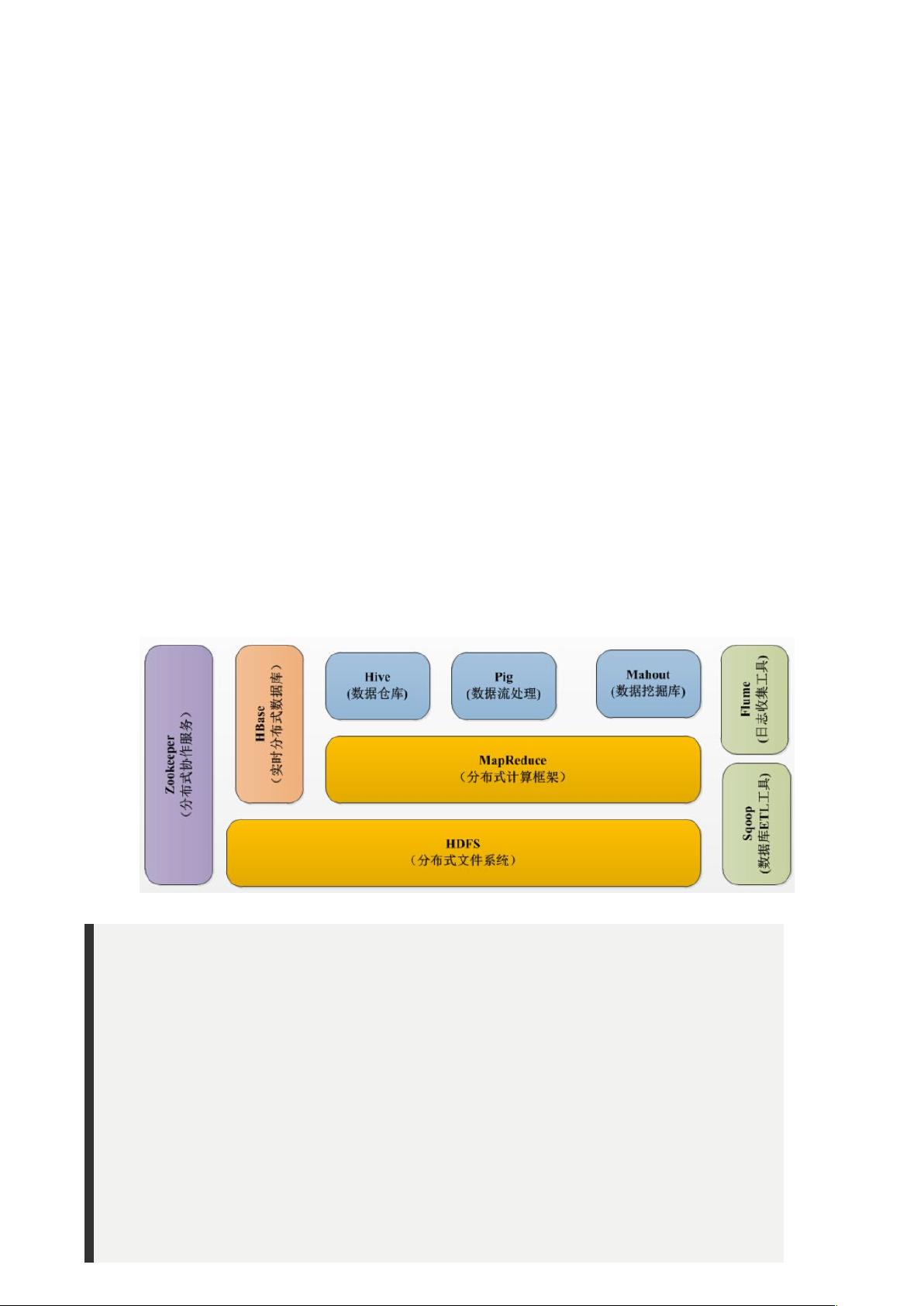

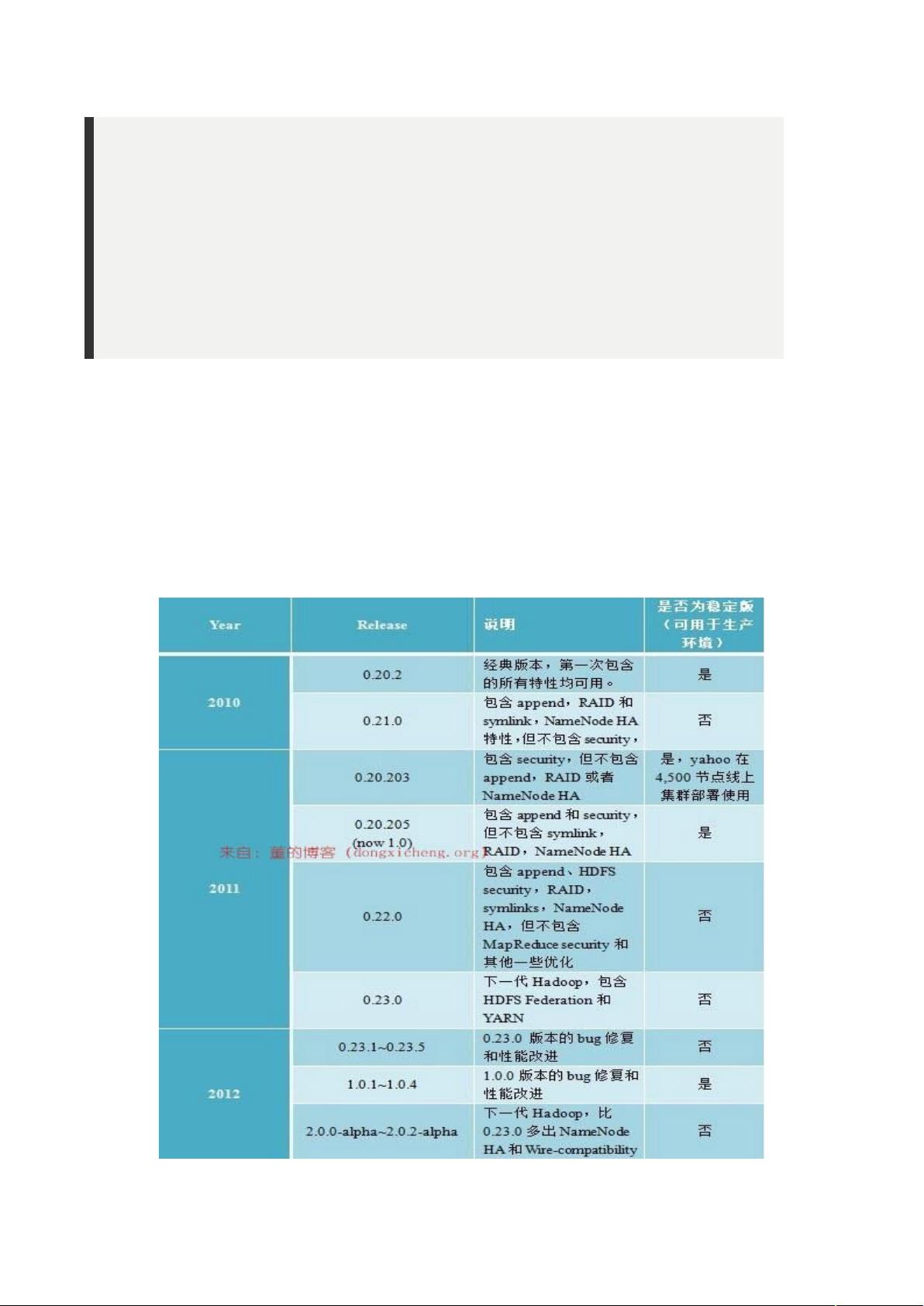

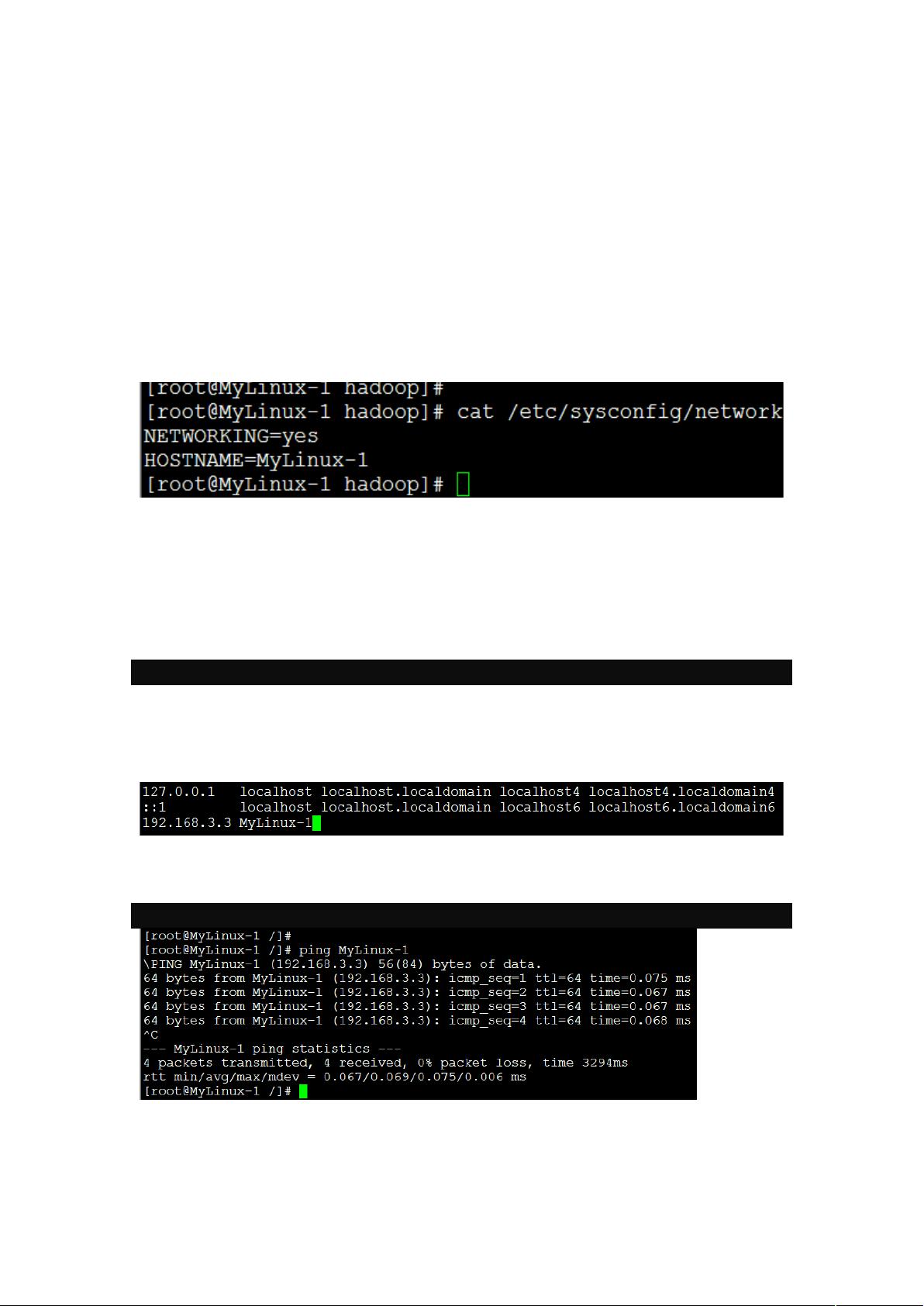

### Hadoop 1.XX 安装部署及组件架构详解 #### 一、Hadoop介绍 ##### 1.1 Hadoop简介 Apache Hadoop 是一个开源的软件框架,旨在通过简单编程模型对大规模数据集进行分布式处理。它具有高度可扩展性,能够从单一服务器扩展至数千台服务器,每台服务器都拥有本地计算能力和存储资源。Hadoop 的核心优势之一在于其高可用性,这并不依赖于昂贵的硬件设备。相反,它的代码库本身就能在应用层检测和处理硬件故障,确保即使在低成本服务器集群上也能提供可靠的服务。 ##### 1.2 Hadoop生态系统 经过多年发展,Hadoop 形成了一个丰富的生态系统,其中包括多个关键组件: - **HDFS (Hadoop Distributed File System)**:这是 Hadoop 生态圈的基础组成部分,提供了一种分布式的数据存储机制。HDFS 能够将数据分布存储在计算机集群上,为其他工具如 HBase 提供支持。 - **MapReduce**:作为 Hadoop 的主要执行框架,MapReduce 支持分布式并行处理。它将任务分解为“map”(映射)和“reduce”(化简)两个阶段,使得 Hadoop 可以并行访问数据,实现高效的数据处理。 - **HBase**:构建在 HDFS 之上的 NoSQL 数据库,面向列存储。HBase 用于高效地读写大量数据,通常用于实时数据访问场景。它使用 Zookeeper 进行集群管理和协调。 - **Zookeeper**:Hadoop 的分布式协调服务,用于管理 Hadoop 操作,确保所有组件之间的协调一致。 - **Pig**:提供了一个简单的编程模型,用于简化 MapReduce 编程的复杂性。Pig 使用 PigLatin 脚本语言,可以将复杂的 MapReduce 任务转换为一系列更简单的操作。 - **Hive**:为 Hadoop 提供 SQL 类似的查询语言 HiveQL,使得熟悉 SQL 的用户无需了解 MapReduce 即可执行数据查询。 - **Sqoop**:用于在传统的关系型数据库、数据仓库和 Hadoop 之间传输数据。它利用 MapReduce 实现数据的并行导入/导出。 - **Flume**:用于收集、聚合和移动大量日志数据,特别是从多台机器收集日志数据到 HDFS。 ##### 1.3 Apache版本衍化 Apache Hadoop 版本经历了两次重大迭代,即 Hadoop 1.0 和 Hadoop 2.0。Hadoop 1.0 包括了 0.20.x、0.21.x 和 0.22.x 等版本,其中 0.20.x 最终演变为稳定的 1.0.x 版本。而 Hadoop 2.0 引入了全新的架构,包括 HDFS Federation 和 YARN(Yet Another Resource Negotiator)两个系统,大大增强了系统的灵活性和性能。 #### 二、安装前准备 ##### 2.1 设置机器名 为了确保 Hadoop 集群中的每个节点能够正确识别对方,需要在每台服务器上设置唯一的机器名。可以通过编辑 `/etc/sysconfig/network` 文件来完成这一设置。例如: ```bash HOSTNAME=myserver.example.com ``` 更改后,需要重启服务器使新设置生效。 ##### 2.2 设置 Host 映射文件 为了确保集群内的服务器能够互相识别,需要设置 IP 地址与机器名的映射。可以通过编辑 `/etc/hosts` 文件来实现: ```bash 192.168.1.10 myserver.example.com ``` 设置完成后,使用 `ping` 命令验证设置是否成功。 ##### 2.3 设置操作系统环境 在安装 Hadoop 之前,还需要确保操作系统环境满足以下要求: - **关闭防火墙**:防火墙可能会阻止节点间通信,因此需要关闭。可以通过以下命令查看防火墙状态: ```bash systemctl status firewalld ``` 如果防火墙处于开启状态,可以使用以下命令将其关闭: ```bash systemctl stop firewalld ``` - **关闭 SELinux**:SELinux 也可能会导致通信问题。可以通过以下命令检查 SELinux 状态: ```bash sestatus ``` 如果 SELinux 处于启用状态,需要将其禁用。编辑 `/etc/selinux/config` 文件,将 `SELINUX=enforcing` 更改为 `SELINUX=disabled`,然后重启服务器。 ##### 2.4 创建账户及目录 - **创建账户**:为了便于管理和安全考虑,建议为 Hadoop 创建专用账户。 - **设置 Hadoop 用户名密码**:为创建的账户设置强密码。 - **创建目录**:为 Hadoop 的各个组件创建必要的目录,例如 `/data/hdfs`, `/data/yarn` 等。 完成以上准备工作后,就可以正式开始 Hadoop 的安装与配置过程了。这些步骤对于搭建一个可靠的 Hadoop 1.X 集群至关重要,确保了集群的稳定性和安全性。

剩余15页未读,继续阅读

- 粉丝: 8

- 资源: 12

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功