Lucene_3.0_原理与代码分析

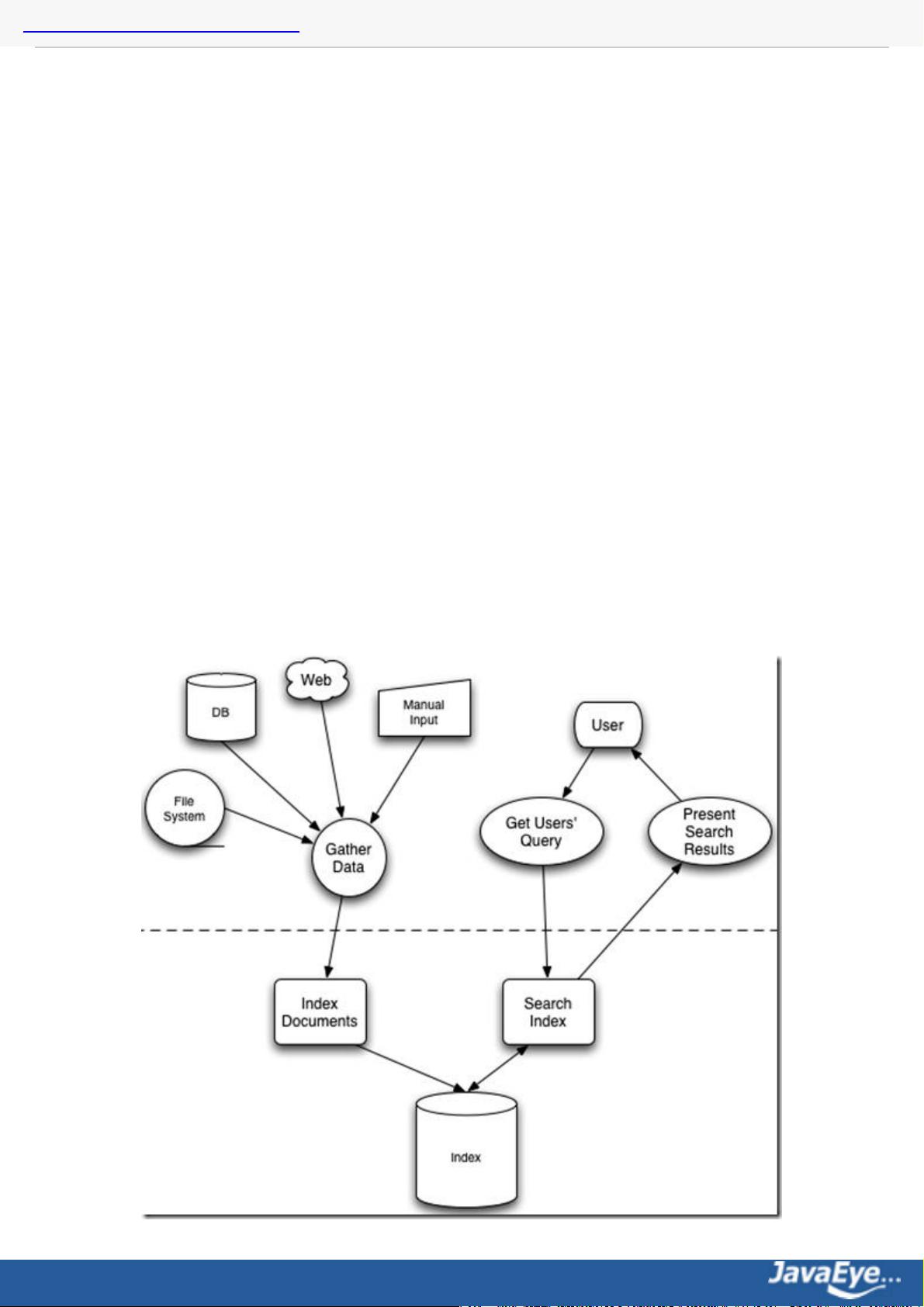

### Lucene 3.0 原理与代码分析 #### 一、全文检索基本原理 全文检索(Full-text Search)是一种从非结构化文本中提取相关信息的技术,它允许用户通过输入关键词来查找文档中是否包含这些关键词。全文检索系统通常能够处理大量的文档集合,并提供高效的搜索性能。 在了解Lucene的工作原理前,我们需要先理解全文检索的基本概念。根据Apache Lucene官方文档的定义,Lucene是一个基于Java的高效全文检索库。因此,深入理解全文检索对于掌握Lucene至关重要。 **非结构化数据与全文检索** 在我们的日常生活中,数据大致可以分为两大类:结构化数据和非结构化数据。结构化数据通常是指具有固定格式或有限长度的数据,例如数据库中的表格、元数据等;而非结构化数据则是指那些不定长或没有固定格式的数据,比如电子邮件、文档、网页内容等。全文检索主要针对的就是非结构化数据进行处理。 #### 二、Lucene 的总体架构 Lucene 提供了一个灵活且可扩展的架构,使得开发者可以根据具体的应用场景定制搜索引擎。其核心组件包括: 1. **Indexer(索引器)**:负责读取原始文档并创建索引。这个过程中,索引器会对文档进行分词处理,将文档分解为一系列关键词,并记录下每个关键词出现的位置。 2. **Searcher(搜索器)**:基于创建好的索引,执行用户的查询请求。它会解析用户的查询语句,查找相应的文档,并返回结果。 3. **Analyzer(分析器)**:用于分词和过滤文档内容。分析器可以是内置的也可以是由用户自定义的。 4. **Document(文档)**:表示索引中的单个文档。每个文档都是一组字段的集合,其中每个字段可以有不同的值。 5. **Field(字段)**:构成文档的基本单元。字段可以存储不同的类型的数据,例如字符串、数字等。 6. **Term(词条)**:表示一个具体的单词或短语。索引是以词条为基础建立的。 7. **IndexWriter(索引写入器)**:用于创建和更新索引。 8. **IndexReader(索引读取器)**:用于读取索引,但不能修改索引。 9. **Query(查询)**:用户输入的查询语句,可以是简单的关键词或复杂的布尔表达式。 10. **ScoreDoc(评分文档)**:包含匹配文档的信息及其相关性得分。 11. **Sort(排序)**:决定搜索结果如何排序的规则。 #### 三、Lucene 的索引文件格式 Lucene 使用一种高效的存储格式来保存索引数据。这些索引文件主要包括: 1. **Segment Info File(段信息文件)**:存储了关于该段的信息,如版本号、文档数量等。 2. **Fields Index File(字段索引文件)**:记录了所有字段的名称以及每个字段的词条数。 3. **Fields Data File(字段数据文件)**:包含了每个字段的词条及其对应的文档ID和位置信息。 4. **Term Vector Files(词条向量文件)**:提供了关于每个词条在文档中出现位置的信息,这对于某些高级功能(如相关性反馈)非常重要。 5. **Compound File(复合文件)**:将多个索引文件合并成一个大文件,以提高读取效率。 #### 四、Lucene 索引过程分析 Lucene 的索引过程可以分为以下几个步骤: 1. **文档解析**:读取原始文档并解析成适合处理的格式。 2. **分词处理**:将文档分解成一系列词条。这一步通常由分析器完成,可以是内置的也可以是自定义的。 3. **词条处理**:对每个词条执行诸如去除停用词、词干提取等操作,以提高检索的准确性。 4. **索引构建**:根据处理后的词条构建倒排索引。倒排索引是一种数据结构,用于快速定位文档中包含特定词条的位置。 5. **索引优化**:通过对索引进行合并、压缩等操作,提高索引的读取速度和存储效率。 #### 五、Lucene 段合并过程分析 Lucene 中的索引是以段(Segment)的形式存在的。随着新的文档不断被添加,可能会形成多个段。为了提高搜索效率,Lucene 会定期执行段合并操作,将多个小段合并成一个较大的段。这一过程涉及到以下关键步骤: 1. **选择待合并段**:根据一定的策略选择需要合并的段。 2. **合并索引**:将选中的段合并成一个新的段。 3. **删除旧段**:合并完成后,旧的段会被删除,以释放磁盘空间。 4. **更新索引**:更新索引中关于段的信息,确保索引的一致性。 #### 六、Lucene 打分公式的数学推导 Lucene 使用TF-IDF(Term Frequency-Inverse Document Frequency)算法来计算文档的相关性得分。TF-IDF 是一种统计方法,用来评估一个词条在一个文档中的重要程度。公式如下: \[ \text{TF-IDF}(t,d,D) = \text{TF}(t,d) \times \text{IDF}(t,D) \] 其中: - \( \text{TF}(t,d) \) 表示词条 \( t \) 在文档 \( d \) 中的频率。 - \( \text{IDF}(t,D) \) 表示词条 \( t \) 在文档集 \( D \) 中的逆文档频率。 #### 七、Lucene 搜索过程解析 Lucene 的搜索过程主要包括以下几个步骤: 1. **查询解析**:将用户输入的查询语句解析成 Lucene 可以理解的形式。 2. **查询执行**:根据解析后的查询语句,在索引中查找匹配的文档。 3. **评分**:计算匹配文档的相关性得分。 4. **排序**:按照相关性得分对文档进行排序。 5. **结果展示**:将排序后的文档列表返回给用户。 #### 八、Lucene 的查询语法、JavaCC 及 QueryParser Lucene 支持多种查询语法,如布尔查询、短语查询等。JavaCC 是一种工具,用于生成解析器和编译器,它常用于实现 Lucene 的查询解析器。`QueryParser` 类则用于将用户的查询字符串解析成 Lucene 可以理解的查询对象。 #### 九、Lucene 的查询对象 在 Lucene 中,查询对象用于表示用户查询的具体形式。Lucene 提供了多种查询对象,如 `TermQuery`、`BooleanQuery`、`PhraseQuery` 等,它们分别对应于不同类型的查询。 #### 十、Lucene 的分词器(Analyzer) 分词器是 Lucene 中的核心组件之一,用于将文本分解成词条。Lucene 提供了多种内置的分词器,如 `StandardAnalyzer`、`SimpleAnalyzer` 等。此外,用户还可以自定义分词器以满足特定的需求。 #### 总结 本文详细介绍了Lucene 3.0的原理与代码分析,从全文检索的基本原理出发,逐步深入到Lucene的具体实现细节。Lucene不仅提供了一套完整的全文检索解决方案,还为开发者留出了足够的扩展空间,使其能够适应各种不同的应用场景。通过深入学习Lucene的工作原理,可以帮助开发者更好地利用这一强大的工具来构建高效的搜索应用。

剩余549页未读,继续阅读

- 粉丝: 0

- 资源: 36

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功