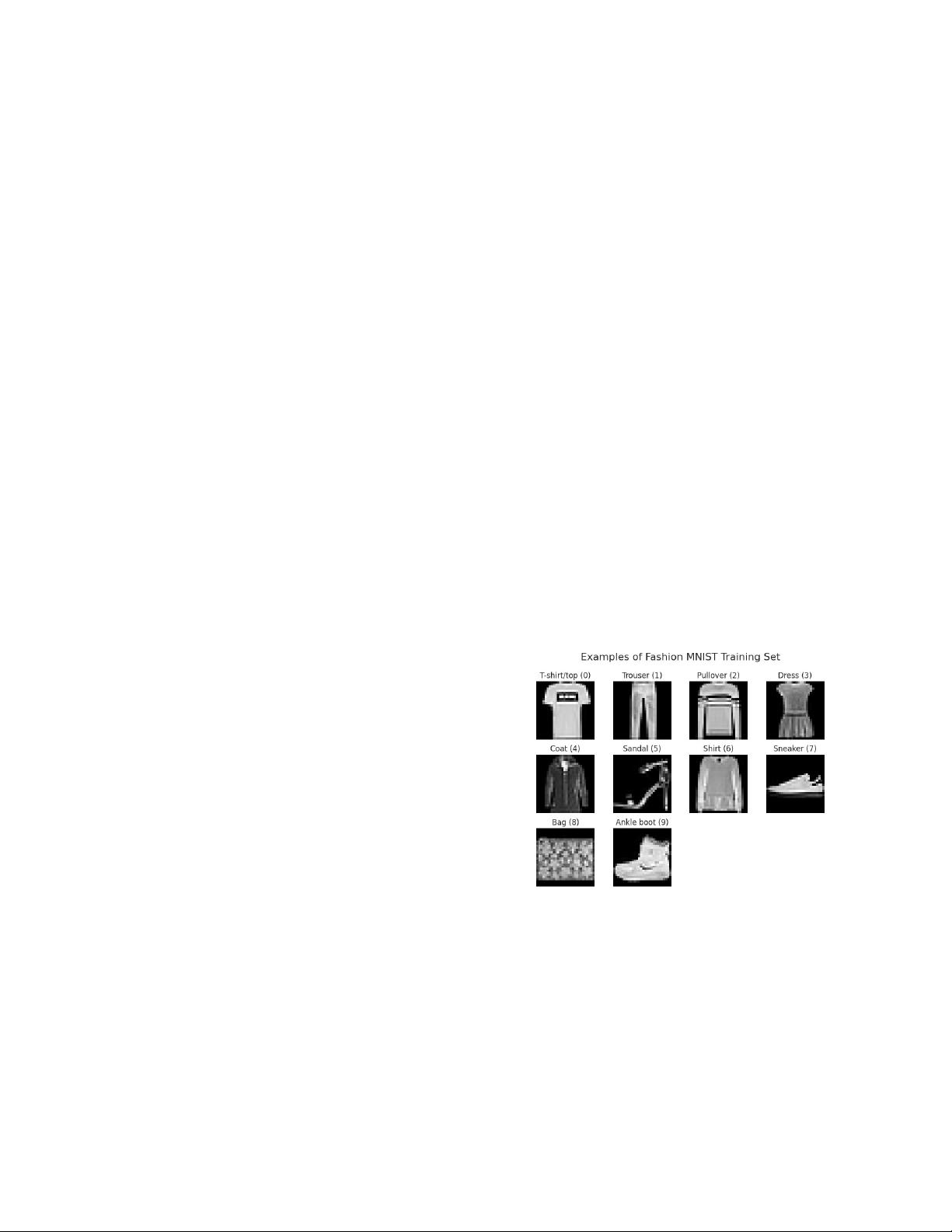

ST, we will delve into the details of three popular algorithms: Decision Trees, K-Nearest Neighbors (KNN), and XGBoost, evaluating their capabilities in image classification tasks. **决策树(Decision Tree)** 决策树是一种监督学习算法,常用于分类任务。它通过创建一个表示特征与类别之间关系的树状模型来进行预测。在Fashion-MNIST数据集上,决策树会基于图像的各个特征(如形状、纹理等)进行分割,形成一系列规则。决策树的优势在于易于理解和解释,但可能面临过拟合或欠拟合的问题。为了优化决策树在Fashion-MNIST上的表现,通常需要调整的参数包括树的深度、最小样本划分数量以及特征选择方法。 **K-最近邻(K-Nearest Neighbors, KNN)** KNN是一种基于实例的学习,它将新样本分类为与其最近的K个训练样本中最常见的类别。在Fashion-MNIST中,KNN会计算测试图像与训练集中所有图像的距离,然后选取最接近的K个邻居来决定测试图像的类别。KNN的性能受K值、距离度量方式以及是否进行降维等因素影响。较大的K值可以减少噪声影响,但可能降低分类的精度,而较小的K值可能导致模型过于敏感。 **极端梯度提升(Extreme Gradient Boosting, XGBoost)** XGBoost是梯度提升算法的一种高效实现,特别适用于处理大规模数据和多分类问题。它通过迭代地添加弱学习器(如决策树),每次迭代都专注于纠正前一轮学习器的错误,从而构建出强学习器。在Fashion-MNIST上,XGBoost能够利用图像的复杂结构,逐步提高分类性能。关键参数包括学习率、树的深度、正则化项以及迭代次数。优化这些参数有助于平衡模型的复杂性和泛化能力。 **比较与优化** 在对比这三种算法时,我们会关注它们在准确率、召回率、F1分数等指标上的表现。为了提高分类性能,通常需要对每个模型进行参数调优,例如使用网格搜索、随机搜索或者贝叶斯优化。此外,预处理步骤如特征缩放、数据增强、降维也可能影响模型性能。 **实验设计与结果分析** 实验通常会包含交叉验证来评估模型的稳定性和泛化能力。对于Fashion-MNIST,我们可能会使用5折或10折交叉验证,并报告平均性能。通过对不同参数组合的结果进行比较,我们可以确定每种算法的最佳配置。我们还会讨论模型的运行时间和内存消耗,这对于实际应用中的可扩展性和效率至关重要。 总结来说,Fashion-MNIST数据集为研究者提供了挑战性的图像分类任务,决策树、KNN和XGBoost都是常用的分类算法,各有优缺点。通过深入理解这些算法的工作原理,结合适当的参数调整和预处理,我们可以为特定任务选择最适合的模型,提高分类的准确性和效率。这项研究旨在为机器学习实践者提供关于如何在复杂图像数据集上选择和优化算法的洞察。

- 粉丝: 0

- 资源: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功