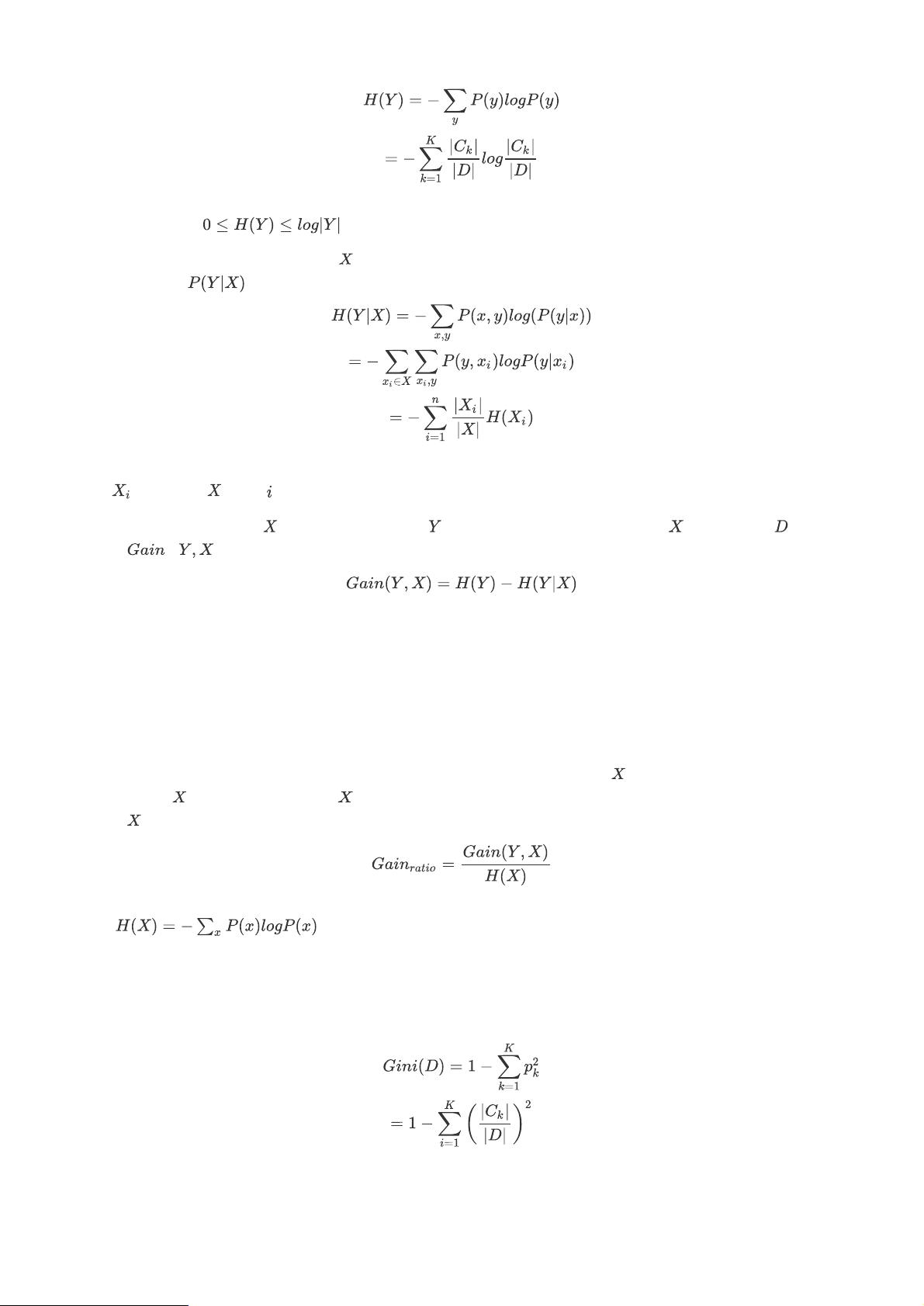

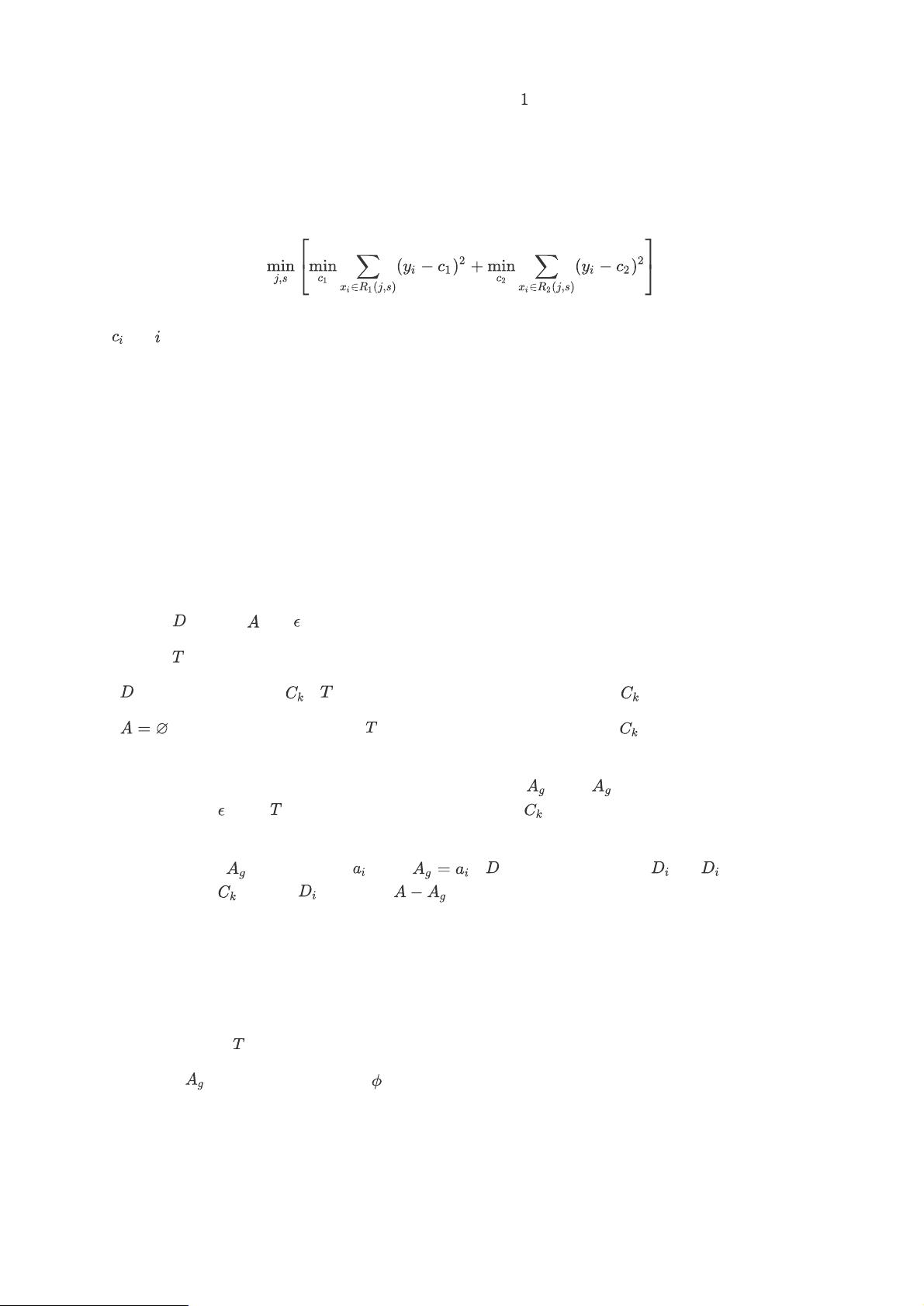

机器学习是人工智能的一个重要分支,它主要研究如何通过计算机程序使用样本数据自动学习并提高自身的性能。在机器学习中,树模型因其直观性和实用性而成为研究和应用的热点。树模型是一类模拟决策过程的算法,其中决策树、随机森林、Adaboost、GBDT、XGBoost和孤立森林是树模型中较具代表性的算法。 决策树是一种模拟人类决策过程的算法,它通过一系列规则对数据进行分类或回归。ID3、C4.5和CART是三种常用的决策树算法。ID3使用信息增益作为特征选择的标准,C4.5则是信息增益率,而CART则采用基尼指数。信息增益是基于信息熵概念,它度量了数据集的不确定性。信息增益越大,意味着不确定性降低越多,因此一个好的特征将会导致信息增益的增加。信息增益率则是为了校正信息增益偏好取值较多的属性的倾向而提出的。基尼指数是另一种特征选择准则,它与信息熵一样可以度量数据集的不确定性,但计算方法不同。 随机森林(RF)是一种集成学习方法,它通过构建多个决策树并将它们的预测结果进行投票或平均来提高整体的预测准确率和防止过拟合。随机森林中每个决策树的构建都是在原始训练数据集的一个随机子集上进行的,而且在每个节点进行分裂时,也是从随机选择的特征子集中选择最佳的分裂属性。 Adaboost是一种提升方法,它的核心思想是通过不断增加那些之前分类错误的样本的权重,使得分类器更关注那些难以分类的样本来提高准确度。Adaboost通过加权多数表决的方式结合多个分类器的预测结果,使得最终的分类结果更准确。 GBDT(Gradient Boosting Decision Tree)是梯度提升决策树的缩写,它通过迭代的方式建立多个决策树,每次迭代都通过拟合前一轮迭代的预测误差来改进模型。GBDT使用损失函数的负梯度来指导树的生长方向,是一种高效的机器学习算法,适合用于回归问题和分类问题。 XGBoost(eXtreme Gradient Boosting)是GBDT的优化版本,它使用了二阶泰勒展开来近似损失函数,并且在优化过程中加入了正则项来控制模型的复杂度,防止过拟合。XGBoost使用了并行计算和缓存优化等技术,使得训练速度更快,效率更高。 孤立森林是一种基于树的异常检测算法,它通过随机选择特征以及在特征值上随机选择切分点来构建多棵孤立树,每棵树都试图孤立每个数据点。异常点通常会在树中较浅的层次被孤立出来,因此孤立森林特别适合用于异常检测问题。 在特征选择方面,决策树的特征选择依赖于特征对于数据集分类的影响程度。一个好的特征能够降低数据集的不确定性,这也就是为什么信息增益、信息增益率和基尼指数等准则如此重要的原因。在构建决策树时,算法会根据这些准则选择最佳的分裂点,使得生成的树尽可能地反映数据的真实结构。 在建树过程中,决策树会递归地将数据集分割成更小的子集,直到满足停止条件,如所有数据点属于同一类或者所有特征都已使用。建树的目的是找到能够最大程度地将数据集按照类标签进行分类的树结构。在剪枝阶段,会移除一些对分类结果影响不大的树节点,以减少过拟合的风险。 在机器学习的实践中,树模型因其可解释性强、不需要复杂的数学变换、能够处理数值型和类别型数据而受到青睐。树模型在构建过程中不需要特征标准化,也能够处理缺失数据,并且可以很好地捕捉特征间的非线性关系。然而,树模型也有其缺点,例如容易过拟合,特别是在数据维度较高时容易遇到维度灾难的问题。 在特征工程中,特征选择是关键步骤之一。树模型可以根据特征选择准则,从原始特征中挑选出最有代表性的特征,从而简化模型,提高训练效率和预测性能。特征选择可以基于统计测试、模型或基于搜索的方法来完成。在决策树中,特征选择通常是在每个节点分裂时进行的,是树构建过程中的自然组成部分。 机器学习中的树模型是众多算法中非常重要的一个类别。从决策树到随机森林、Adaboost、GBDT、XGBoost再到孤立森林,每种算法都有其独特的原理和应用场景。对于初学者来说,通过理解这些基础理论并结合实践,可以逐步深入学习并掌握机器学习的核心技术。

剩余17页未读,继续阅读

- 粉丝: 12w+

- 资源: 9195

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功