基于Q-learning的分布式自适应拓扑稳定性算法.docx

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

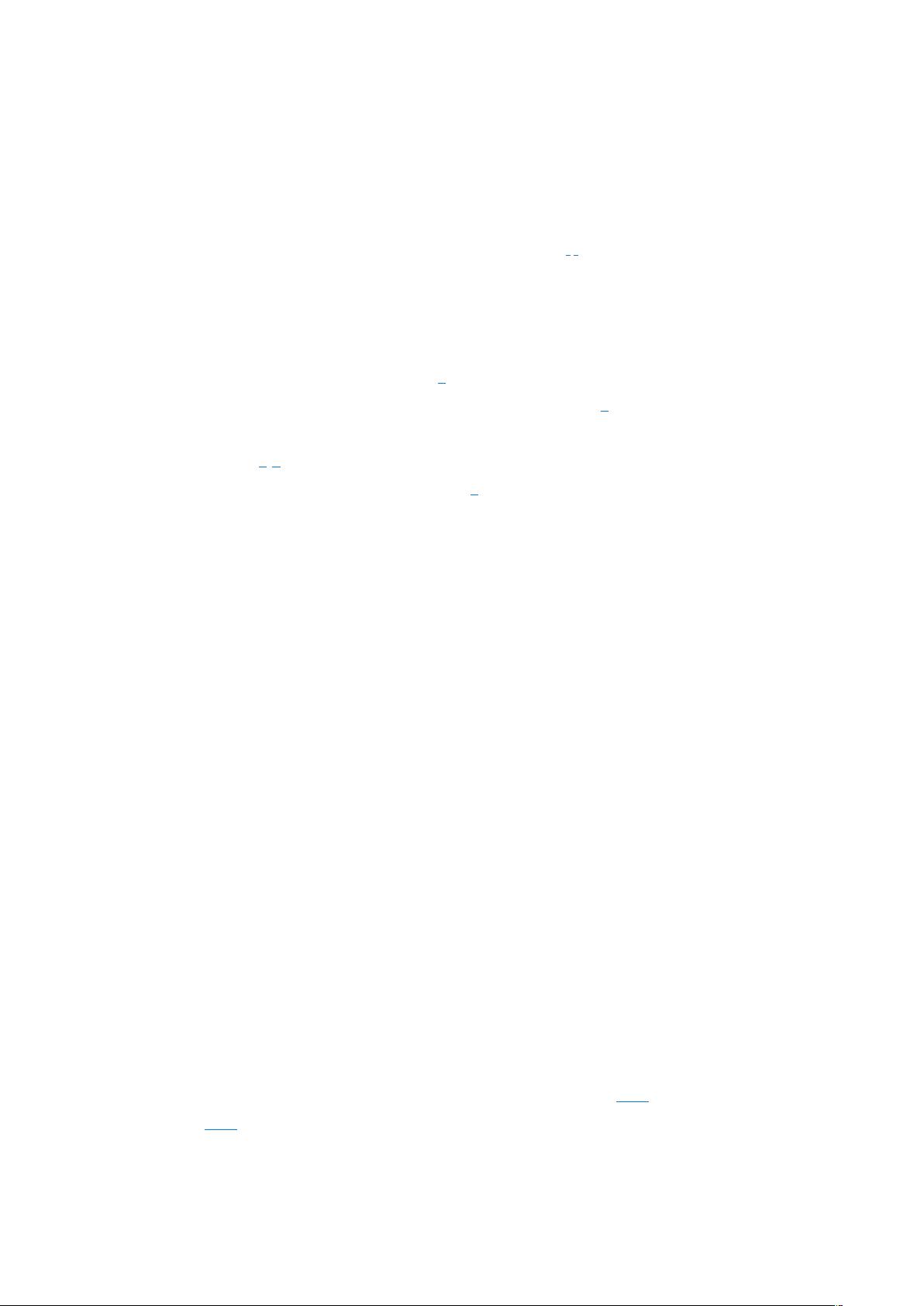

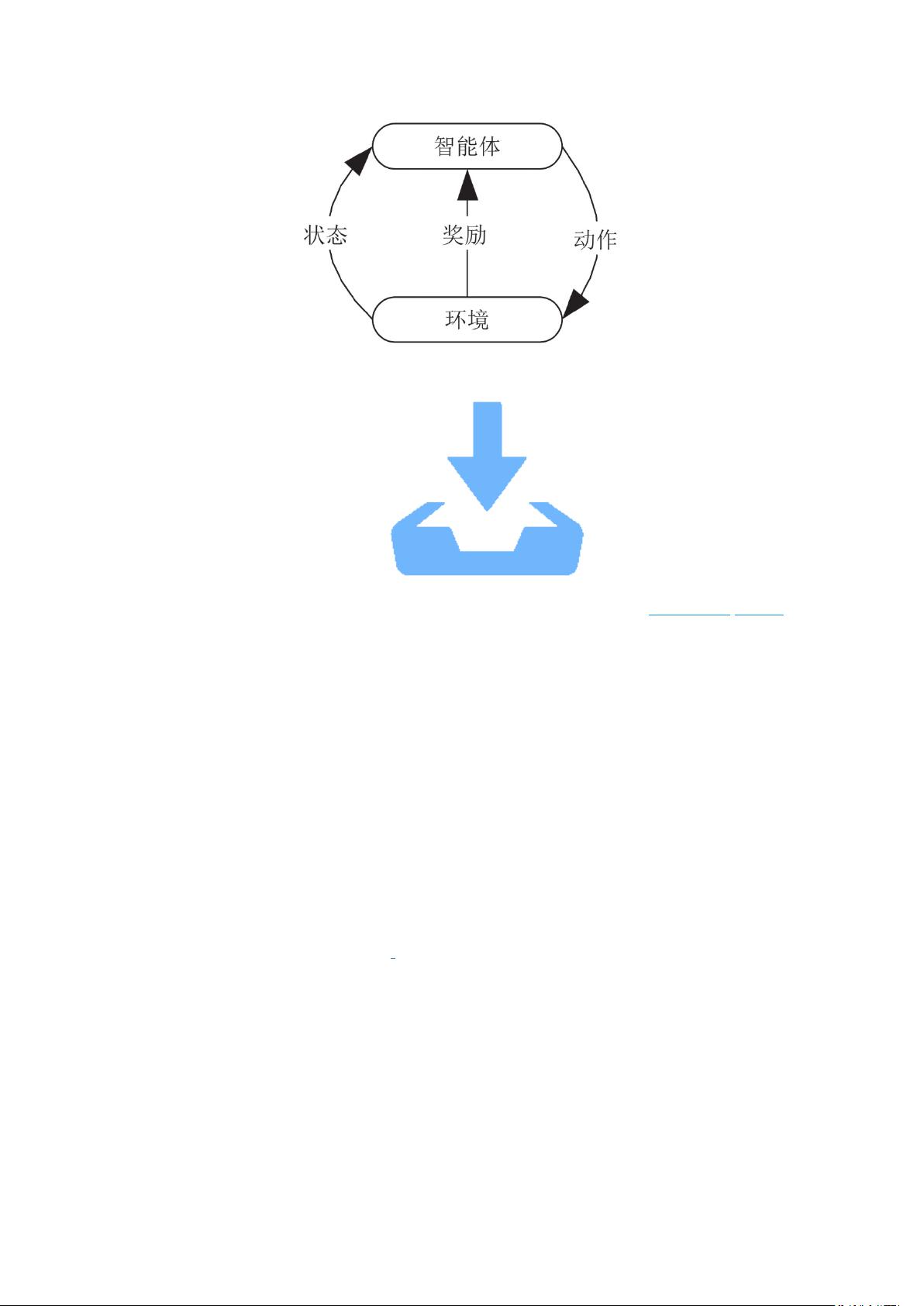

在移动自组织网络(MANET)中,保持网络拓扑的稳定性和通信链路的持续性至关重要。基于Q-learning的分布式自适应拓扑稳定性算法针对MANET的特点,如有限的资源、动态变化的网络结构以及节点的高流动性,提供了一种优化解决方案。Q-learning是一种强化学习算法,它允许节点通过与环境的交互来学习最佳的行为策略,以最大化预期的奖励。 链路稳定性是MANET中的关键概念,特别是在节点间可能存在快速移动的情况下。例如,如果节点A需要通过B或C向D发送数据,而B正在快速远离其他节点,那么(A, B)链路可能会变得不稳定,而(C, A)链路则可能因为C的缓慢移动而保持更长时间的稳定。因此,选择稳定的链路可以提高路由效率和网络服务质量。 强化学习的基本模型包括环境、状态、动作、奖励和智能体。在这个模型中,智能体(在网络中即为节点)根据当前状态选择动作,并从环境中获取奖励或惩罚。通过反复尝试和学习,智能体能够优化其策略,以在每个状态下选择能带来最大长期奖励的动作。强化学习框架图展示了这种交互过程,其中智能体不断地探索环境,调整策略以最大化收益。 Q-learning是强化学习的一个典型算法,特别适用于MANET的环境,因为它不需要事先知道环境模型,而是通过试错的方式自我学习。Q-learning维护一个Q表,记录每个状态和动作对的预期奖励。在每一步,节点根据Q表选择动作,并根据实际获得的奖励更新Q值,使得在类似状态下选择该动作的可能性增加或减少。在MANET中,节点通过邻居节点的接收信号强度(RSSI)值进行分布式强化学习,根据信号强度的变化动态调整其路由策略。 本文提出的算法将RSSI与Q-learning结合,节点通过学习邻居节点的信号强度值,自适应地划分决策区间,形成直接决策区间和自适应强化学习区间。这允许节点根据不同的环境条件对连接状态进行分级判断,并实时更新学习。通过不断学习,每个节点都将构建一个最优联接策略表,用于预测和判断下一状态的邻居节点连接情况,从而适应网络的动态变化,提高链路稳定性和整体网络性能。 基于Q-learning的分布式自适应拓扑稳定性算法利用了强化学习的优势,通过学习和适应环境,能够在MANET中选择最稳定的链路,减少通信中断,提高数据传输的可靠性。这种方法克服了传统算法只考虑单一参数或固定移动特性预测的局限性,更加全面地反映了节点移动性对链路稳定性的综合影响。

剩余12页未读,继续阅读

- 粉丝: 4451

- 资源: 1万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功