在机器学习领域,计算题是理解算法本质的关键环节。这里我们深入探讨了六个核心概念:ADAboost、SVM、决策树、EM算法、反向传播和K-means聚类。

1. **ADAboost**:ADAboost(Adaptive Boosting)是一种集成学习方法,通过连续迭代加权多数表决来构建弱学习器的强学习器。第二轮迭代后,错误分类的样本会获得更高的权重。例如,如果在第一轮中有样本6、7和8被误分类,它们在第二轮中的权重会增加,以便在后续迭代中学习器会更关注这些难以分类的样本。

2. **SVM(Support Vector Machine)**:最大间隔最大化是SVM的核心思想。给定正样本和负样本,我们需要找到一个超平面,使得两类样本的距离最大化。对于给定的样本集,可以通过拉格朗日乘子法和对偶问题求解最大间隔超平面。例如,正样本{(1,2), (2,3), (3,3)}和负样本{(2,1), (3,2)},可以手动求解线性可分情况下的超平面和支持向量。

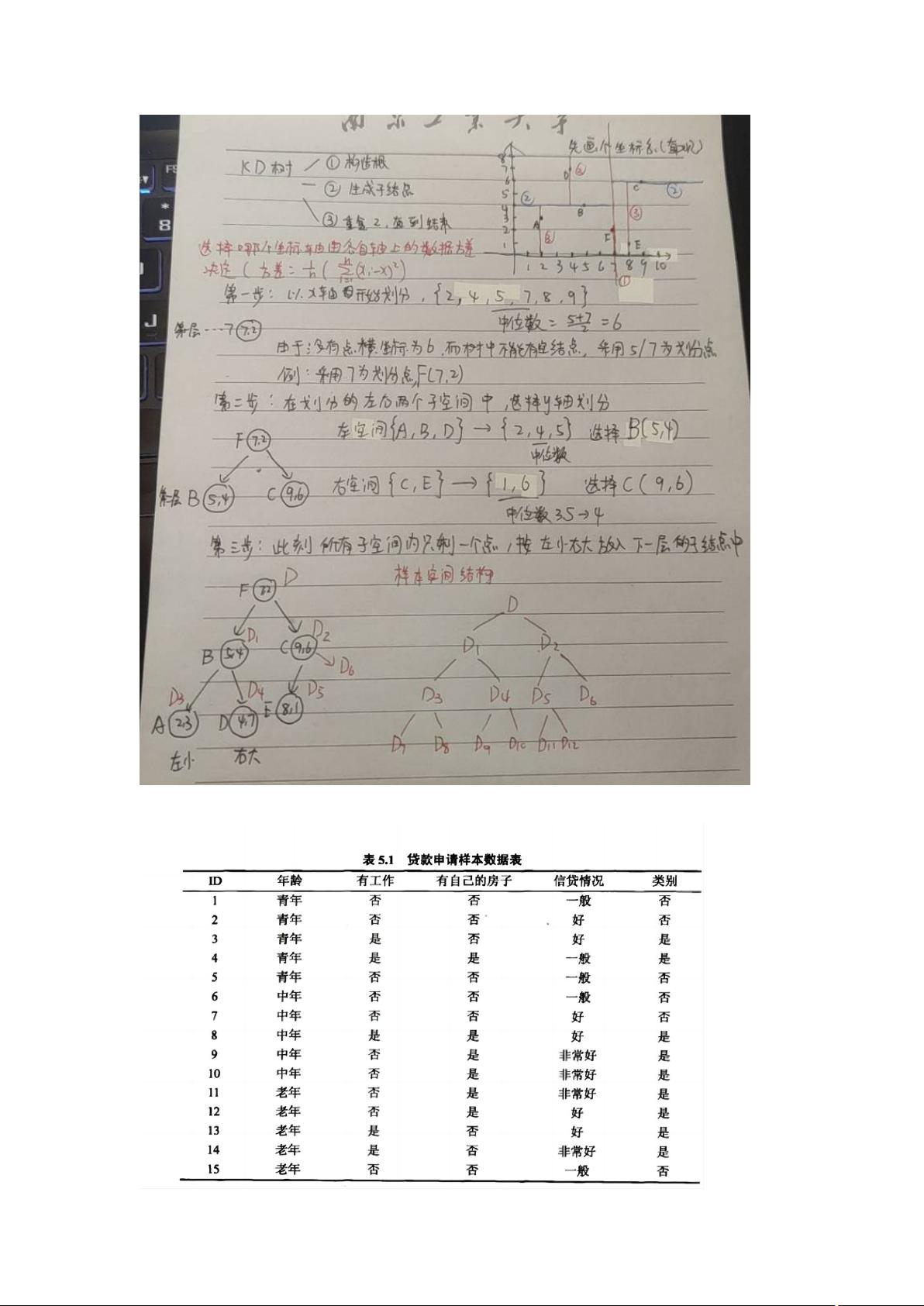

3. **决策树(ID3与C4.5)**:ID3和C4.5是两种著名的决策树算法。它们基于信息熵或增益率选择最优特征来分裂节点。构建决策树的过程包括计算信息熵,选择信息增益最大的特征,然后递归地分裂节点,直到满足停止条件(如达到预设的深度或所有样本属于同一类别)。

4. **EM算法(Expectation-Maximization)**:EM算法常用于处理缺失数据和概率模型参数估计。在给定硬币投掷实验数据的情况下,EM算法通过E步骤(期望)和M步骤(最大化)迭代更新概率参数P1和P2,直到收敛,从而估计出每枚硬币正面朝上的概率。

5. **反向传播(Backpropagation)**:反向传播是神经网络中优化权重的主要方法。在Sigmoid激活函数和交叉熵损失函数的设置下,通过链式法则计算损失函数对权重w和偏置b的梯度,进而更新参数以最小化损失,促进网络的训练。

6. **K-means聚类**:K-means聚类旨在将数据分配到k个聚类中,每个聚类由其质心代表。例如,对于给定的9个二维数据点,选取k=3,初始质心为A1、B1和C1。使用曼哈顿距离衡量点与质心之间的距离,然后重新分配数据点到最近的质心并更新质心,直至质心不再改变或达到预设迭代次数。

7. **朴素贝叶斯分类器**:基于贝叶斯定理,学习一个分类器来预测给定特征的类标记。例如,根据训练数据,可以计算特征X(1)和X(2)在各个类别的先验概率,以及条件概率P(Y|X),从而预测新样本x=(2,S)的类标记。

8. **有向概率图模型(Directed Probabilistic Graphical Models)**:在这样的模型中,p(x)的条件概率连乘形式反映了变量间的条件独立性。每个变量的概率可以通过其父节点的条件概率计算得出。

以上这些计算题涵盖了机器学习中基础且重要的概念,通过它们可以深入理解各种算法的运作机制。