没有合适的资源?快使用搜索试试~ 我知道了~

资源推荐

资源详情

资源评论

ChatGPT

在

做

什么

...

为什么

它

有

效

?

-WhatIs

ChatGPTDoing

…

andWhyDoesItWork?

WhatIsChatGPTDoing

…

andWhyDoesItWork?

ChatGPT

在

做

什么

...

为什么

它

有

效

?

February14,20232

⽉

14

,

2023

It

’

sJustAddingOneWordataTime

它

只

是

⼀

次

添

加

⼀个

单

词

ThatChatGPTcanautomaticallygeneratesomethingthatreadsevensuperficiallylikehuman-

writtentextisremarkable,andunexpected.Buthowdoesitdoit?Andwhydoesitwork?My

purposehereistogivearoughoutlineofwhat

’

sgoingoninsideChatGPT

―

andthentoexplore

whyitisthatitcandosowellinproducingwhatwemightconsidertobemeaningfultext.I

shouldsayattheoutsetthatI

’

mgoingtofocusonthebigpictureofwhat

’

sgoingon

―

and

whileI

’

llmentionsomeengineeringdetails,Iwon

’

tgetdeeplyintothem.(Andtheessenceof

whatI

’

llsayappliesjustaswelltoothercurrent

“

largelanguagemodels

”

[LLMs]asto

ChatGPT.)

ChatGPT

可

以

⾃

动

⽣

成

⼀些东

西

,

甚

⾄

表

⾯

上

读

起

来

像

⼈

类

写

的

⽂

本

,

这

是

⾮

常

了不

起

的

,

也

是

出

乎

意

料

的

。

但

它

是

如

何

做

到

的

呢

?

为什么

它

有

效

?

我

在

这

⾥

的

⽬

的

是

粗

略

地

概

述

ChatGPT

内

部

发

⽣

的

事

情

,

然

后

探

索

为什么

它

可

以

在

⽣

成我

们

认

为

有

意

义

的

⽂

本

⽅

⾯

做

得

如

此

出

⾊

。

我

应

该

在

⼀

开

始

就

说

,

我

将

专

注

于

正

在

发

⽣

的

事

情

的

⼤

局

-

虽

然

我

会

提

到

⼀些

⼯

程

细

节

,

但

我

不

会

深

⼊

探

讨

它

们

。

(

我

要

说

的

本

质

同

样

适

⽤

于

其

他

当

前

的

“

⼤

型

语

⾔

模

型

”

[LLM]

和

ChatGPT

。

ThefirstthingtoexplainisthatwhatChatGPTisalwaysfundamentallytryingtodoistoproduce

a

“

reasonablecontinuation

”

ofwhatevertextit

’

sgotsofar,whereby

“

reasonable

”

we

mean

“

whatonemightexpectsomeonetowriteafterseeingwhatpeoplehavewrittenon

billionsofwebpages,etc.

”

⾸

先

要

解

释

的

是

,

ChatGPT

从

根

本

上⼀

直

试

图

做

的

是

产

⽣

迄

今为

⽌

获

得

的

任何

⽂

本

的

“

合

理

延

续

”

,

其

中

“

合

理

”

是

指

“

⼈

们

在

看

到

⼈

们

在

数

⼗

亿个

⽹

⻚

上

写

的

内

容

后可

能

期望

某

⼈

写

什么

,

等等

。

Solet

’

ssaywe

’

vegotthetext

“

ThebestthingaboutAIisitsabilityto

”

.Imaginescanning

billionsofpagesofhuman-writtentext(sayonthewebandindigitizedbooks)andfindingall

instancesofthistext

―

thenseeingwhatwordcomesnextwhatfractionofthetime.ChatGPT

effectivelydoessomethinglikethis,exceptthat(asI

’

llexplain)itdoesn

’

tlookatliteraltext;it

looksforthingsthatinacertainsense

“

matchinmeaning

”

.Buttheendresultisthatit

producesarankedlistofwordsthatmightfollow,togetherwith

“

probabilities

”

:

因

此

,

假

设

我

们

有

⽂

本

“

⼈

⼯

智

能

最

好

的

事

情

是

它

的

能

⼒

”

。

想

象

⼀下

,

扫

描

数

⼗

亿

⻚

的

⼈

类

书

写

⽂

本

(

例

如

在

⽹络

和

数

字

化

书

籍

中

)

并

找

到

这

些

⽂

本

的

所

有

实

例

,

然

后

查

看

下⼀个

单

词

在

哪

⼀

部

分

时

间

出

现

。

ChatGPT

有

效

地

做

了

这

样

的

事

情

,

除

了

(

正

如

我

将

解

释

的

那

样

)

它

不

查

看

⽂

字

⽂

本

;

它

寻

找

在

某

种

意

义上

“

意

义

匹

配

”

的

事

物

。

但

最

终结

果

是

,

它

产

⽣

了⼀个

可

能

跟

随

的

单

词

的

排

名

列

表

,

以

及

“

概

率

”:

AndtheremarkablethingisthatwhenChatGPTdoessomethinglikewriteanessaywhatit

’

s

essentiallydoingisjustaskingoverandoveragain

“

giventhetextsofar,whatshouldthenext

wordbe?

”

―

andeachtimeaddingaword.(Moreprecisely,asI

’

llexplain,it

’

saddinga

“

token

”

,whichcouldbejustapartofaword,whichiswhyitcansometimes

“

makeupnew

words

”

.)

值

得

注

意

的

是

,

当

ChatGPT

做

⼀些

像

写

⼀

篇

⽂

章

这

样

的

事

情

时

,

它

本

质

上

所

做

的

只

是

⼀

遍

⼜

⼀

遍

地

问

“

给

定

到

⽬

前

为

⽌

的

⽂

本

,

下⼀个

词

应

该

是

什么

?

⸺

每

次

都

加

⼀个

字

。

(

更

准

确

地

说

,

正

如

我

将

解

释

的

那

样

,

它

正

在

添

加

⼀个

“

令

牌

”

,

这

可

能

只

是

⼀个

单

词

的

⼀

部

分

,

这

就

是

为什么

它

有

时

可

以

“

编

造

新

单

词

”

。

But,OK,ateachstepitgetsalistofwordswithprobabilities.Butwhichoneshoulditactually

picktoaddtotheessay(orwhatever)thatit

’

swriting?Onemightthinkitshouldbethe

“

highest-ranked

”

word(i.e.theonetowhichthehighest

“

probability

”

wasassigned).But

thisiswhereabitofvoodoobeginstocreepin.Becauseforsomereason

―

thatmaybeoneday

we

’

llhaveascientific-styleunderstandingof

―

ifwealwayspickthehighest-rankedword,

we

’

lltypicallygetavery

“

flat

”

essay,thatneverseemsto

“

showanycreativity

”

(andeven

sometimesrepeatswordforword).Butifsometimes(atrandom)wepicklower-rankedwords,

wegeta

“

moreinteresting

”

essay.

但

是

,

好

的

,

在

每

⼀

步

它

都

会

得

到

⼀个

带

有

概

率

的

单

词

列

表

。

但

是

它实

际

上

应

该

选

择

哪

⼀个

来

添

加到

它

正

在

写

的

⽂

章

(

或

其

他什么

)

中

?

有

⼈

可

能

会

认

为

它

应

该

是

“

排

名

最

⾼

”

的

词

(

即

分

配

最

⾼

“

概

率

”

的

词

)

。

但

这

就

是

⼀

点

巫

毒

教

开

始

蔓

延

的

地

⽅

。

因

为

出

于

某

种

原

因

⸺

也

许

有

⼀

天

我

们会

有

⼀个

科

学

⻛

格

的

理

解

⸺

如

果

我

们

总

是

选

择排

名

最

⾼

的

词

,

我

们

通

常

会

得

到

⼀

篇

⾮

常

“

平

淡

”

的

⽂

章

,

似

乎

永

远

不

会

“

表

现

出

任何

创

造

⼒

”

(

甚

⾄

有

时

会

逐

字

重

复

)

。

但

是

,

如

果有

时

(

随

机

)

我

们

选

择排

名

较

低

的

单

词

,

我

们会

得

到

⼀

篇

“

更有

趣

”

的

⽂

章

。

Thefactthatthere

’

srandomnessheremeansthatifweusethesamepromptmultipletimes,

we

’

relikelytogetdifferentessayseachtime.And,inkeepingwiththeideaofvoodoo,there

’

s

aparticularso-called

“

temperature

”

parameterthatdetermineshowoftenlower-ranked

wordswillbeused,andforessaygeneration,itturnsoutthata

“

temperature

”

of0.8seems

best.(It

’

sworthemphasizingthatthere

’

sno

“

theory

”

beingusedhere;it

’

sjustamatter

ofwhat

’

sbeenfoundtoworkinpractice.Andforexampletheconceptof

“

temperature

”

is

therebecauseexponentialdistributionsfamiliarfromstatisticalphysicshappentobebeing

used,butthere

’

sno

“

physical

”

connection

―

atleastsofarasweknow.)

这

⾥

存

在

随

机

性

的

事

实

意

味

着

,

如

果

我

们

多

次

使

⽤

相

同

的

提

⽰

,

我

们

每

次

都

可

能

会

得

到

不

同

的

论

⽂

。

⽽

且

,

为了与

巫

毒

教

的

想

法

保

持

⼀

致

,

有

⼀个

特

定

的

所

谓

“

温

度

”

参

数

来

确

定

使

⽤

排

名

较

低

的

单

词

的

频

率

,

对

于

论

⽂

⽣

成

,

事

实

证

明

0.8

的

“

温

度

”

似

乎

是

最

好

的

。

(

值

得强

调

的

是

,

这

⾥

没

有

使

⽤

“

理

论

”

;

这

只

是

在

实

践

中

发

现

什么

有

效

的

问

题

。

例

如

,

“

温

度

”

的

概

念

之

所

以

存

在

,

是

因

为

恰

好

使

⽤

了

统

计

物

理

学

中

熟

悉

的

指

数

分

布

,

但

没

有

“

物

理

”

联

系

⸺

⾄

少

据

我

们

所

知

。

BeforewegoonIshouldexplainthatforpurposesofexpositionI

’

mmostlynotgoingtouse

thefullsystemthat

’

sinChatGPT;insteadI

’

llusuallyworkwithasimplerGPT-2system,which

hasthenicefeaturethatit

’

ssmallenoughtobeabletorunonastandarddesktopcomputer.

AndsoforessentiallyeverythingIshowI

’

llbeabletoincludeexplicitWolframLanguagecode

thatyoucanimmediatelyrunonyourcomputer.(Clickanypictureheretocopythecodebehind

it.)

在

我

们

继续

之

前

,

我

应

该

解

释

⼀下

,

出

于

说

明

的

⽬

的

,

我

通

常

不

会使

⽤

ChatGPT

中

的

完

整

系

统

;

相

反

,

我

通

常

会使

⽤

更

简

单

的

GPT-2

系

统

,

该

系

统

具

有

⾜

够

⼩

的

功

能

,

可

以

在

标

准

台

式

计

算

机

上

运

⾏

。

因

此

,

对

于

我

展

⽰

的

基

本

上

所

有

内

容

,

我

将

能

够

包

含

明

确

的

Wolfram

语

⾔

代

码

,

您

可

以

⽴

即

在

计

算

机

上

运

⾏

。

(

单

击

此

处

的

任何

图

⽚

以

复

制

其

背

后

的

代

码

。

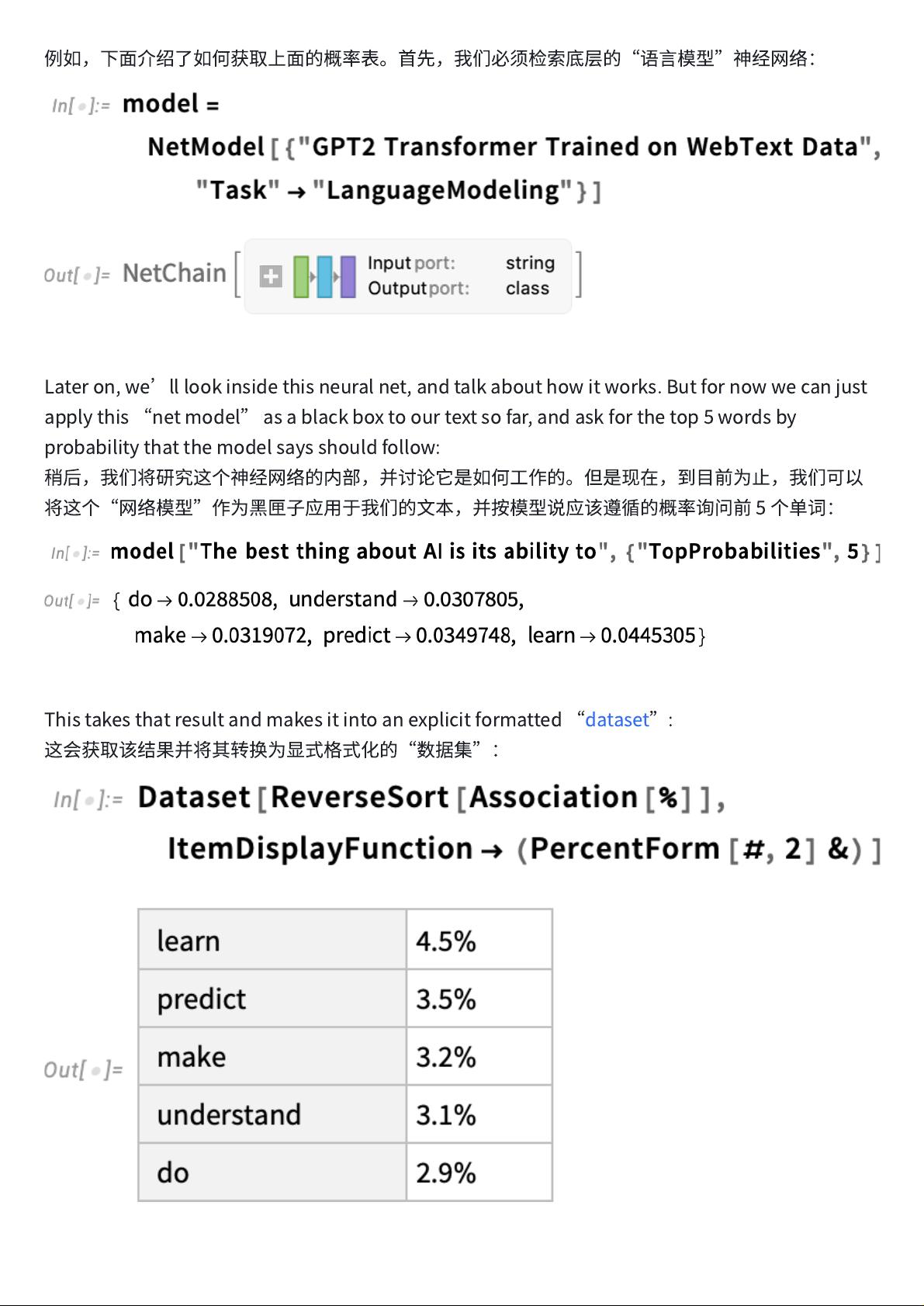

Forexample,here

’

showtogetthetableofprobabilitiesabove.First,wehavetoretrievethe

underlying

“

languagemodel

”

neuralnet:

例

如

,

下

⾯

介

绍

了

如

何

获

取

上

⾯

的

概

率

表

。

⾸

先

,

我

们

必

须

检

索

底

层

的

“

语

⾔

模

型

”

神

经⽹络

:

Lateron,we

’

lllookinsidethisneuralnet,andtalkabouthowitworks.Butfornowwecanjust

applythis

“

netmodel

”

asablackboxtoourtextsofar,andaskforthetop5wordsby

probabilitythatthemodelsaysshouldfollow:

稍

后

,

我

们

将

研

究

这

个

神

经⽹络

的

内

部

,

并

讨论

它

是

如

何

⼯

作

的

。

但

是

现

在

,

到

⽬

前

为

⽌

,

我

们

可

以

将

这

个

“

⽹络

模

型

”

作

为

⿊

匣

⼦

应

⽤

于

我

们

的

⽂

本

,

并

按

模

型

说

应

该

遵

循

的

概

率

询

问

前

5

个

单

词

:

Thistakesthatresultandmakesitintoanexplicitformatted

“

dataset

”

:

这

会

获

取

该

结

果

并

将

其

转

换

为

显

式

格

式

化

的

“

数

据

集

”:

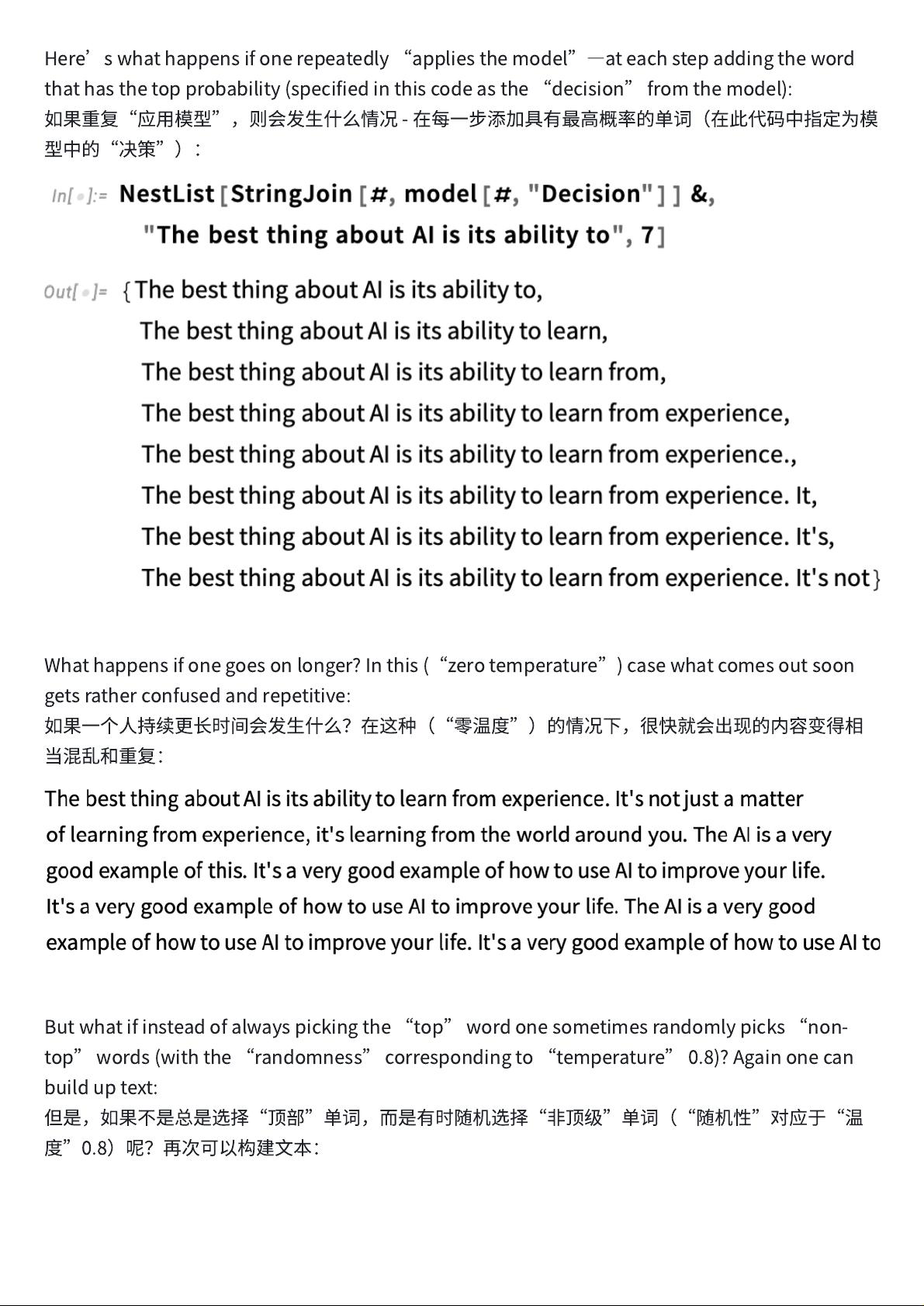

Here

’

swhathappensifonerepeatedly

“

appliesthemodel

”

―

ateachstepaddingtheword

thathasthetopprobability(specifiedinthiscodeasthe

“

decision

”

fromthemodel):

如

果

重

复

“

应

⽤

模

型

”

,

则

会

发

⽣

什么

情

况

-

在

每

⼀

步

添

加

具

有最

⾼

概

率

的

单

词

(

在

此

代

码

中

指

定

为

模

型

中

的

“

决

策

”

)

:

Whathappensifonegoesonlonger?Inthis(

“

zerotemperature

”

)casewhatcomesoutsoon

getsratherconfusedandrepetitive:

如

果

⼀个⼈

持

续

更

⻓

时

间

会

发

⽣

什么

?

在

这

种

(

“

零

温

度

”

)

的

情

况

下

,

很

快

就

会

出

现

的

内

容

变

得

相

当

混

乱

和

重

复

:

Butwhatifinsteadofalwayspickingthe

“

top

”

wordonesometimesrandomlypicks

“

non-

top

”

words(withthe

“

randomness

”

correspondingto

“

temperature

”

0.8)?Againonecan

builduptext:

但

是

,

如

果

不

是

总

是

选

择

“

顶

部

”

单

词

,

⽽

是

有

时

随

机

选

择

“

⾮

顶

级

”

单

词

(

“

随

机

性

”

对

应

于

“

温

度

”

0.8

)

呢

?

再

次

可

以

构

建

⽂

本

:

剩余98页未读,继续阅读

资源评论

weishaoonly

- 粉丝: 135

- 资源: 1381

上传资源 快速赚钱

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功