Pix2Seq:谷歌大脑提出 CV 任务统一接口!.pdf

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

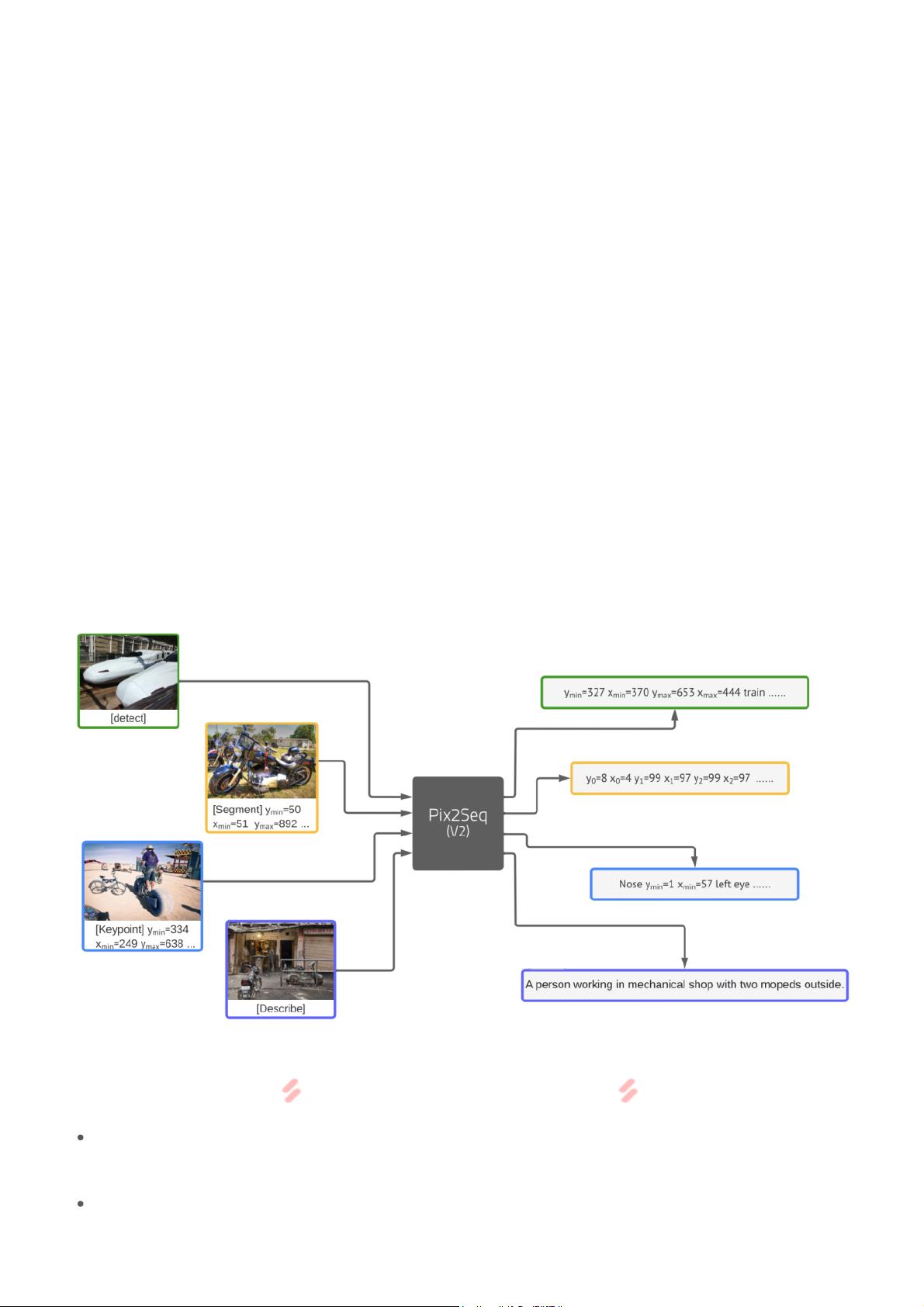

Pix2Seq是由谷歌大脑团队提出的一种创新方法,旨在为计算机视觉(CV)任务提供一个统一的接口和模型架构。这个框架借鉴了自然语言处理(NLP)中的序列生成思想,试图将各种CV任务转化为序列化的输入和输出,从而实现通用模型在多个任务上的应用。 在NLP领域,大规模预训练语言模型如BERT和GPT已经成为处理各种文本任务的基础,通过prompt(提示)指导模型生成目标文本。然而,CV任务的输入和输出通常更为多样化,包括边界框、密集掩模、关键点等,这使得直接应用序列化生成框架变得复杂。 Pix2Seq的核心思想是将CV任务的输出转换为一种统一的token序列形式。例如,在目标检测任务中,模型的输出不再是直接的边界框坐标和类别标签,而是将这些信息序列化为tokens。同样,实例分割、人体关键点检测和图像描述生成等任务也可以通过类似的序列化方法进行处理。 Pix2Seq v2进一步扩展了这一概念,将四个不同的视觉任务——目标检测、实例分割、人体关键点检测和图像描述生成——统一到一个模型中。它通过定义一个标准化的sequence接口,使得模型无需针对每个任务进行特定的结构或损失函数调整,只需通过修改prompt来指示模型生成对应任务的输出格式。 具体来说,Pix2Seq的实现包括以下几个步骤: 1. **Tokenization序列化**:将输入图像转换为一系列tokens,这可能涉及到图像特征的提取和编码。对于输出,任务描述(如指令)和目标结果被转换为token序列。 2. **任务描述**:使用task prompt来指示模型执行的具体任务,例如“detect”指令对于目标检测,或者“describe”指令对于图像描述生成。 3. **模型生成**:模型接收到tokenized输入和task prompt后,生成与任务对应的token sequence。这可能涉及多模态的Transformer架构或其他序列生成模型。 4. **解码与还原**:生成的token sequence被解码回原始的CV任务输出形式,如边界框、像素掩模或关键点坐标。 通过这种方式,Pix2Seq不仅简化了模型的构建和训练过程,还允许模型在不同任务之间共享学习,提升了泛化能力。在论文《A Unified Sequence Interface for Vision Tasks》中,研究人员展示了这个框架在四个核心视觉任务上的表现,表明其性能可以与专门针对各个任务训练的最新模型相媲美。 总结来说,Pix2Seq是CV领域的重大进展,它通过序列化输入和输出,为不同任务提供了一个统一的接口。这使得模型能够跨越任务边界,提高了模型的复用性和效率,为CV任务的通用建模打开了新的可能。随着该方法的进一步研究和发展,我们有望看到更多CV任务被整合到这种统一的序列化框架中,推动计算机视觉领域的进步。

剩余7页未读,继续阅读

- 粉丝: 1277

- 资源: 5623

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- matlab平台的的语音滤波设计.zip

- matlab平台的汉字语音识别.zip

- matlab平台的汉字识别.zip

- matlab平台的的运动行为检测.zip

- matlab平台的火焰识别系统设计.zip

- matlab平台的基于DWT+SVD结合傅里叶变换的数字图像水印水印系统.zip

- matlab平台的火焰烟雾检测.zip

- matlab平台的教室人数统计.zip

- matlab平台的交通道路标识识别.zip

- matlab平台的家居防火识别系统.zip

- matlab平台的考勤系统设计.zip

- matlab平台的口罩检测.zip

- matlab平台的金属表面缺陷分析.zip

- matlab平台的口罩识别设计.zip

- matlab平台的口罩识别.zip

- matlab平台的口罩识别检测.zip

信息提交成功

信息提交成功