恕我直言,很多小样本学习的工作就是不切实际的.pdf

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

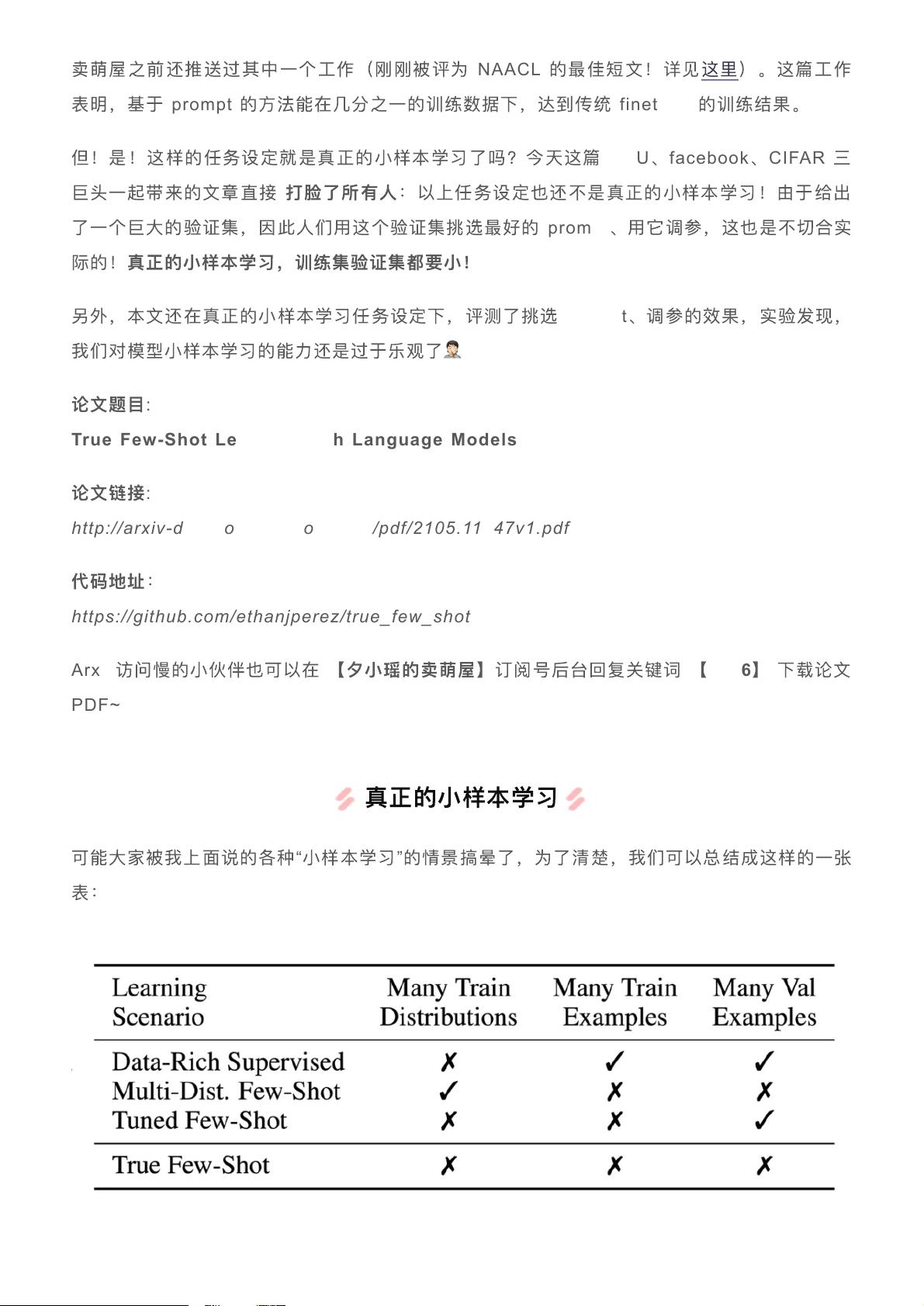

:“恕我直言,很多小样本学习的工作就是不切实际的.pdf” :本文探讨了小样本学习的现状,指出许多现有方法在实际应用中的局限性,特别是过度依赖大型验证集进行参数调整和prompt选择的问题。 【部分内容】分析: 小样本学习(Few-shot Learning)是一个热门的机器学习领域,它旨在解决在有限数据条件下训练模型的问题。传统的小样本学习方法通常需要一个大规模的训练集,然后在测试时使用少量样本进行预测。然而,这种设定与现实世界中的小样本场景相去甚远,因为在实际应用中往往缺乏大量的训练数据。 随着GPT3等大模型的出现,小样本学习的思路发生了转变。研究人员开始利用预训练模型,仅用几条或几十条样本进行finetune,这种方式更接近现实中的小样本学习需求。Prompt技术在此过程中起到了关键作用,通过设计特定的finetune任务形式,将与任务相关的提示信息引入模型,以更好地利用预训练模型的结构和先验知识。 尽管基于prompt的方法在减少训练数据量方面取得了进展,但NYU、Facebook和CIFAR的研究人员指出,即使这种方法也不是真正的小样本学习,因为它们仍然依赖大型验证集进行prompt选择和调参。真正的“True Few-Shot Learning”应该既没有额外的数据分布辅助,也没有大量的训练或验证数据,因为获取标注数据的成本高昂。 论文提出了True Few-Shot Learning的概念,并对比了几种小样本学习情况,包括传统的有大量数据的有监督学习、Multi-Distribution Few-Shot、Tuned Few-Shot以及True Few-Shot。作者质疑了在没有足够验证数据的情况下,如何有效地调整模型参数。为此,他们提出了两种策略:k折交叉验证(CV)和类似在线学习的交叉验证(MDL)。这两种方法试图在训练集和验证集之间找到平衡,最小化样本损失的差异,以实现更好的模型泛化能力。 实验结果显示,无论模型大小,使用CV和MDL方法选择prompt都能在LAMA数据集上得到一定的效果。LAMA是一个评估语言模型知识提取能力的数据集,通过比较不同prompt,研究发现这些方法在限制验证集的情况下仍能有效改善模型性能。 本文对当前小样本学习方法进行了批判性的反思,强调了在资源有限的环境下进行模型优化的挑战,并提出了新的交叉验证策略以适应真正的True Few-Shot Learning。这一研究对于推动小样本学习理论的发展和实际应用具有重要意义,未来的研究应更加关注在有限资源条件下的模型学习能力和泛化性能。

剩余7页未读,继续阅读

- 粉丝: 1272

- 资源: 5619

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功