藏经阁-When DNNs go wrong – adversarial examples and what we can le

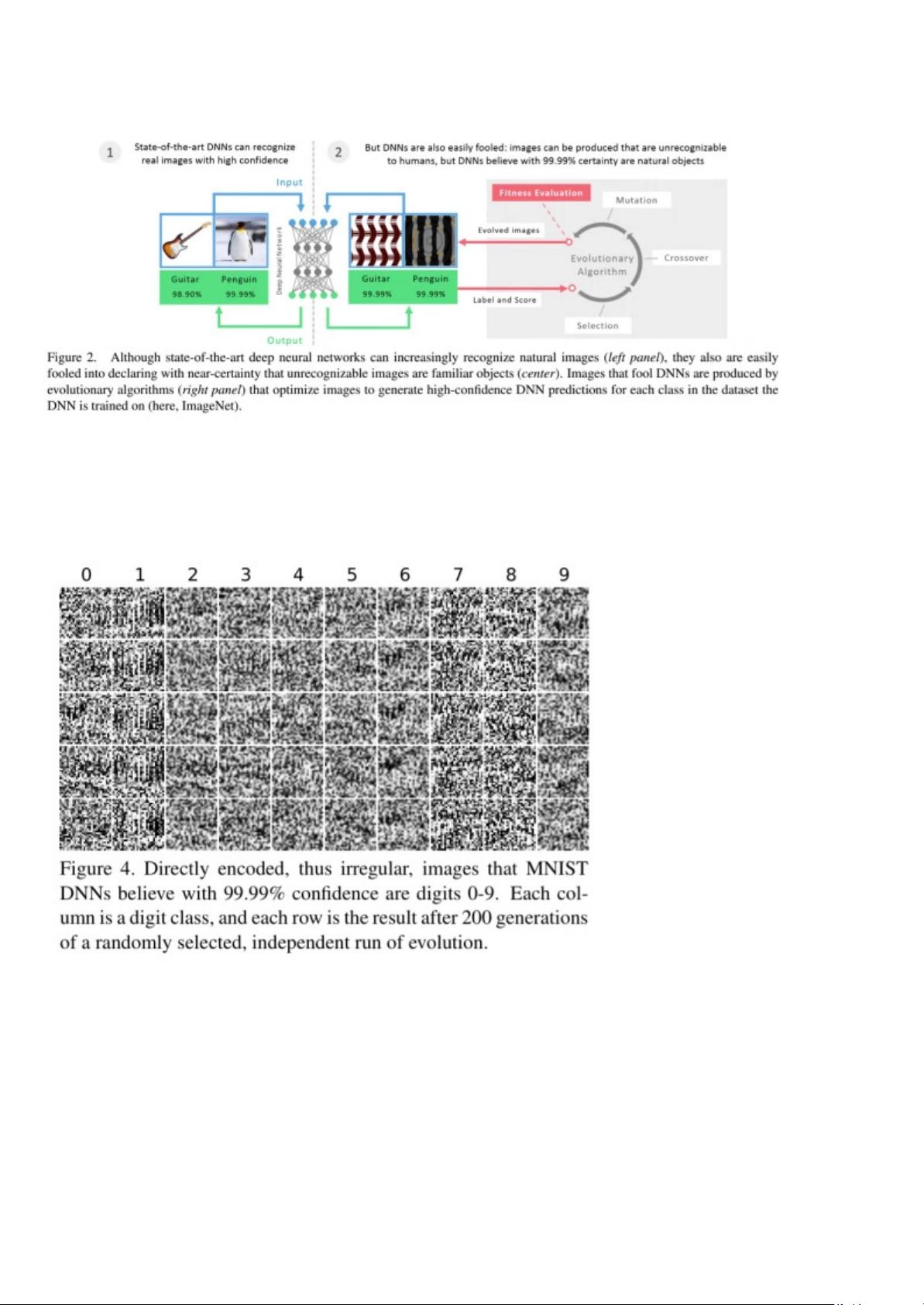

深度学习中对抗样本的研究 深度神经网络(DNN)是一种强大的机器学习模型,但它们也存在一些缺陷,例如易受到对抗样本的攻击。对抗样本是指专门构建的输入,使得深度神经网络产生错误的输出。研究对抗样本可以帮助我们更好地理解深度神经网络中的内部机理,并找到方法来防止其被攻击。 本文总结了五篇与对抗样本相关的研究论文,分别是: 1. "Deep Neural Networks are Easily Fooled"(Nguyen et al., 2015):这篇论文展示了深度神经网络易被欺骗的性质,并提出了生成对抗样本的方法。 2. "Practical Black-box Attacks against Deep Learning Systems using Adversarial Examples"(Papernot et al., 2016):这篇论文介绍了一种实用的黑盒攻击方法,使用对抗样本来攻击深度学习系统。 3. "Adversarial Examples in the Physical World"(Goodfellow et al., 2017):这篇论文研究了对抗样本在物理世界中的应用,例如攻击自动驾驶系统。 4. "Explaining and Harnessing Adversarial Examples"(Goodfellow et al., 2015):这篇论文探讨了对抗样本的机理,并提出了利用对抗样本来改进深度神经网络的方法。 5. "Distillation as a Defense to Adversarial Perturbations against Deep Neural Networks"(Papernot et al., 2016):这篇论文提出了使用蒸馏技术来防止对抗样本攻击的方法。 通过研究对抗样本,我们可以更好地理解深度神经网络的机理,并找到方法来防止其被攻击。同时,对抗样本的研究也可以帮助我们提高深度神经网络的鲁棒性和安全性。 此外,对抗样本的研究还可以应用于其他领域,例如自动驾驶、自然语言处理和计算机视觉等。因此,对抗样本的研究具有重要的理论和实践价值。 对抗样本的研究是深度学习领域中的一个重要方向,对抗样本的研究可以帮助我们更好地理解深度神经网络的机理,并找到方法来防止其被攻击。

剩余18页未读,继续阅读

- 粉丝: 87

- 资源: 1万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 基于HarmonyOS的鸿蒙网络编程设计源码

- 基于小程序的“最多跑一次”源码(小程序毕业设计完整源码+LW).zip

- 仓储系统服务端 基于偌依的单体架构springboot

- 基于小程序的个人健康信息管理小程序源码(小程序毕业设计完整源码).zip

- 基于LLM模型驱动的在线网页PPT制作工具设计源码

- 基于Vue框架的日期选择器组件CSS设计源码

- 基于小程序的使命召唤游戏助手的设计与实现源码(小程序毕业设计完整源码+LW).zip

- 基于Java、Vue等技术的模拟社区核酸检测管理系统设计源码

- CM311-5 HV 固件包

- 基于群晖Synology Audio Station的AsMusic第三方音乐播放器设计源码

- 基于pythonQt5实现的跑马灯效果,作为pythonQt 5的入门例子很适合,已经将每一行代码标注了解释,很好的入门案例

- 基于小程序的党员之家服务系统小程序源码(小程序毕业设计完整源码+LW).zip

- 基于Vue框架的母婴商城小程序设计源码

- 基于Spring Boot、Mybatis-plus、MySQL的React硅谷后台项目后端代码设计源码

- 基于小程序的党建工作小秘书源码(小程序毕业设计完整源码).zip

- 基于110法律咨询网数据的医疗纠纷小程序设计源码

信息提交成功

信息提交成功