藏经阁-Automatic Checkpointing.pdf

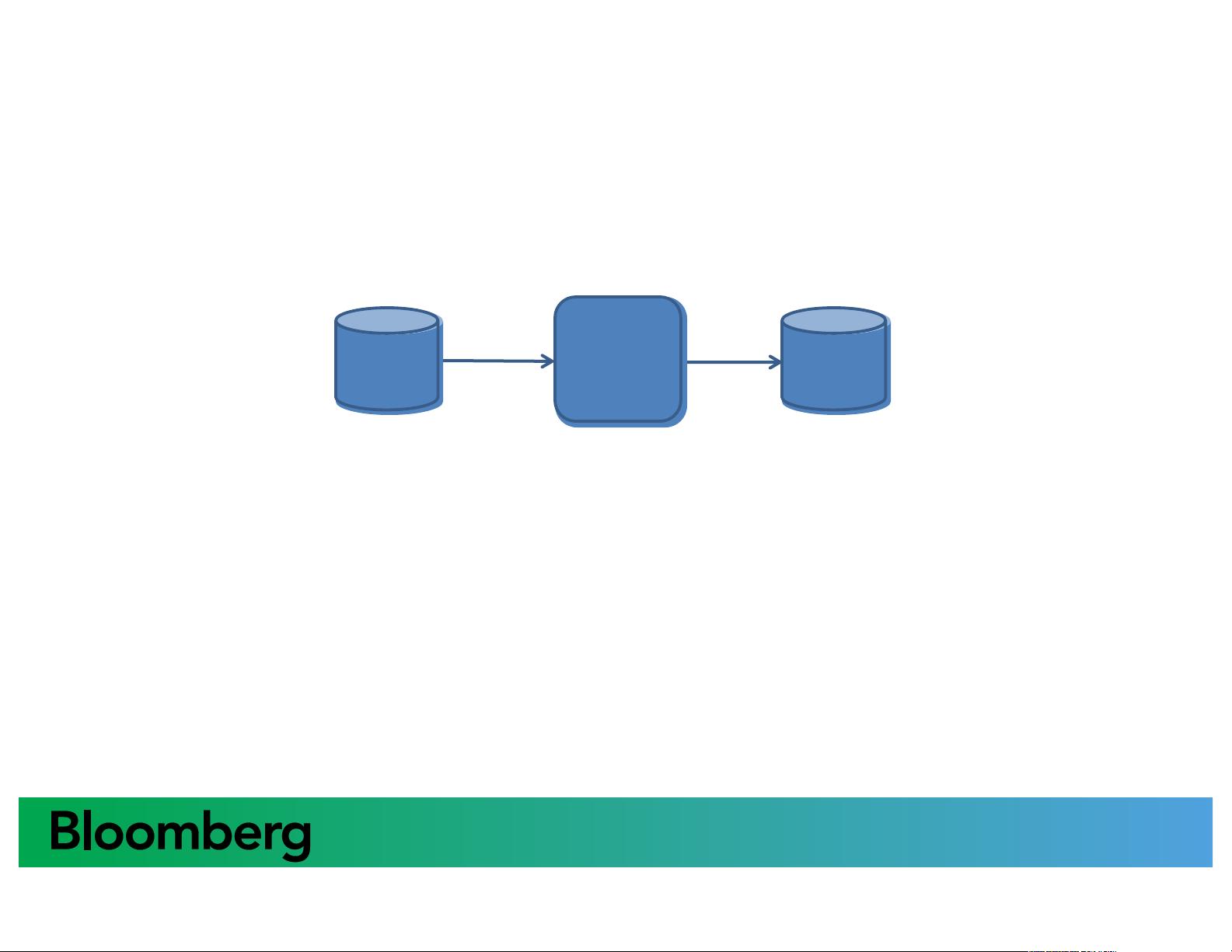

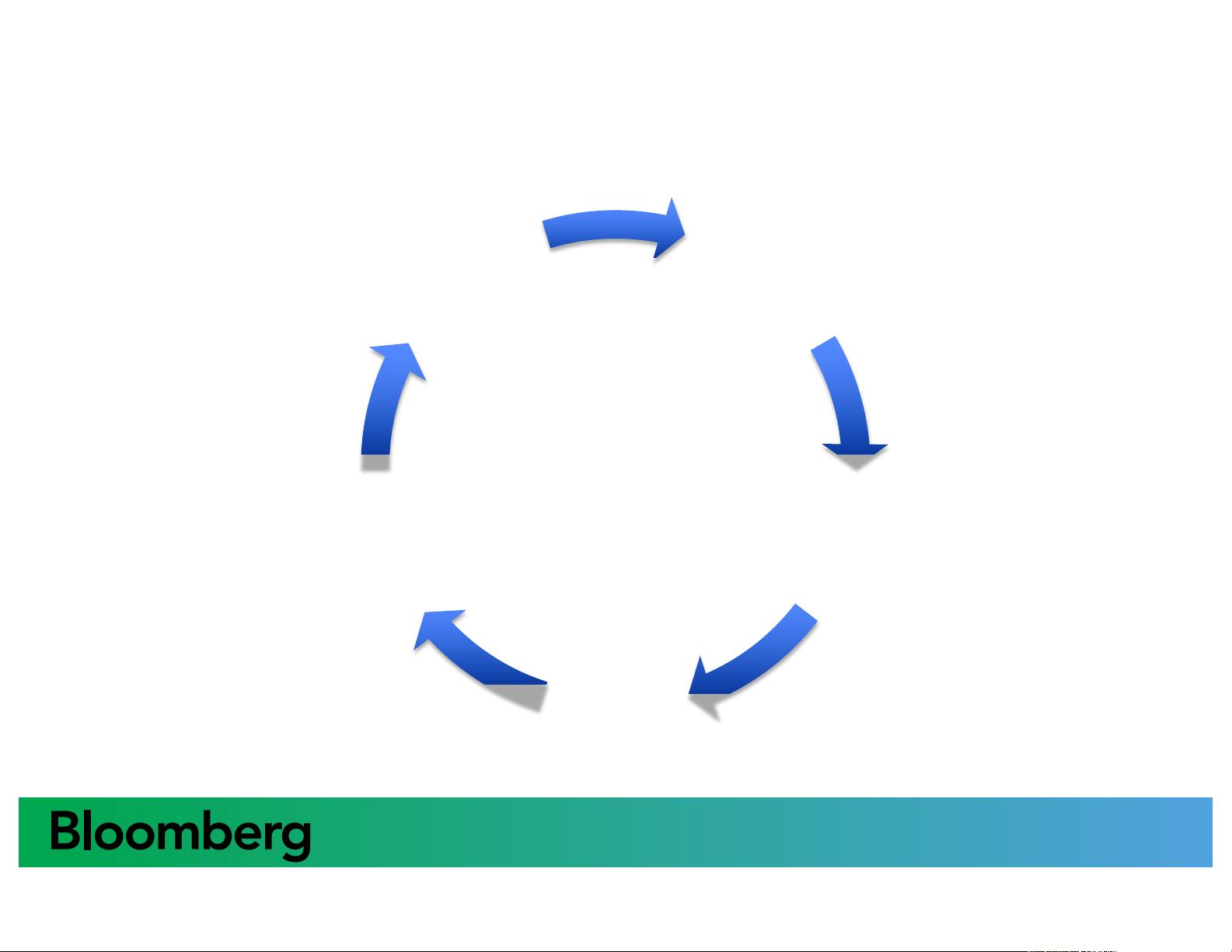

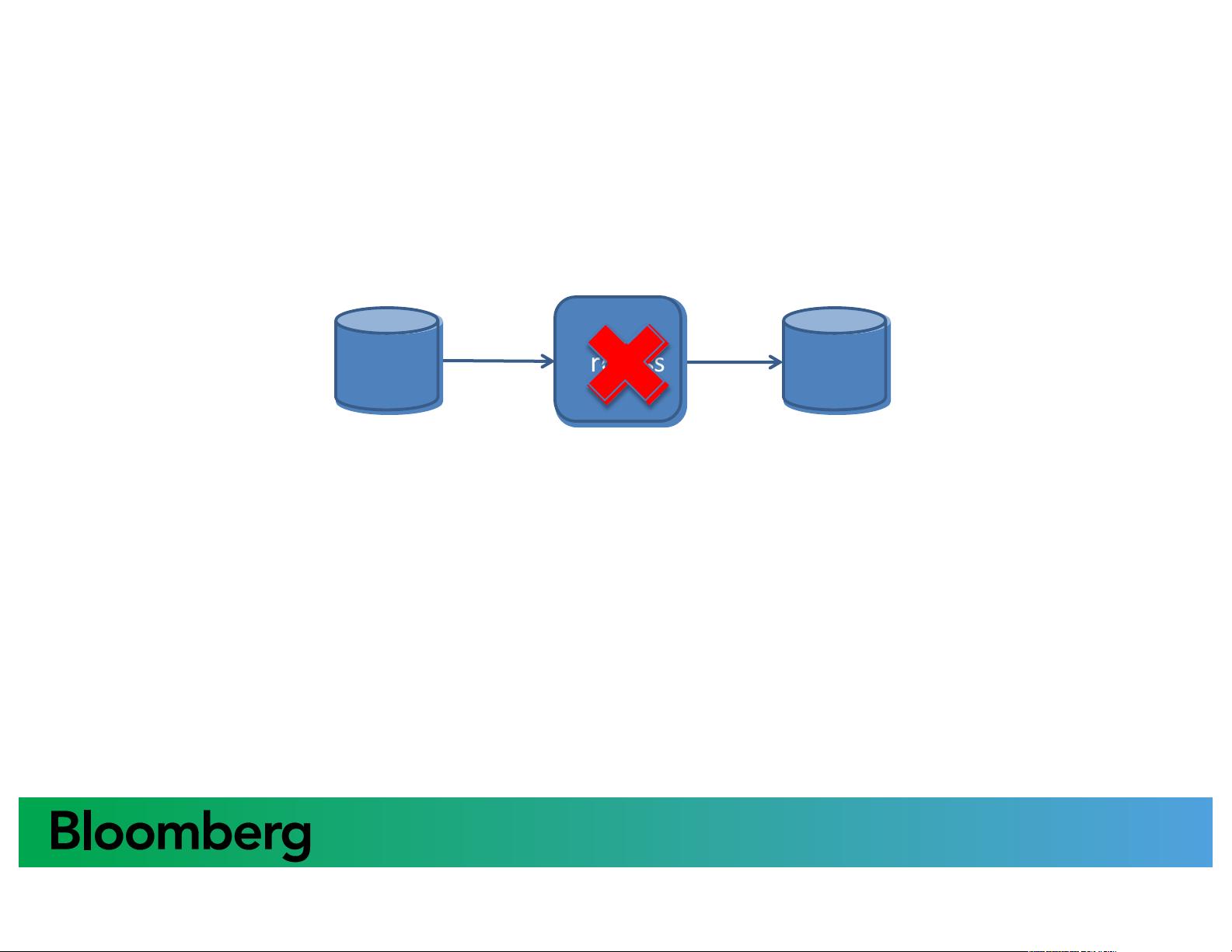

藏经阁-Automatic Checkpointing.pdf 本文档主要讲述了 Apache Spark 中的自动检查点机制,介绍了 Checkpointing 的概念、实现方式和应用场景。 Checkpointing 是 Spark 中的一种机制,用于在数据处理过程中保存当前进度,以便在失败时可以从检查点恢复,避免重新处理整个数据集。Checkpointing 可以在 Spark 中通过对 RDD 依赖关系的管理来实现。 文档首先介绍了 Spark 的开发周期,包括编码、部署、执行和观察结果。然后,作者遇到了一个问题,即某个 Spark 任务失败并抛出了 HotGarbageException 异常,原因是某个库的 Util$$anonfun$morefun$1.apply 方法抛出了异常。 为了解决这个问题,作者尝试将数据处理流程分解为多个 Stage,每个 Stage 负责处理一部分数据。通过对每个 Stage 的输出结果进行保存和加载,以便在失败时可以从检查点恢复。 文档接着介绍了自动检查点机制的实现方式,即通过 checkpoint() 方法将 RDD 的依赖关系保存到磁盘上,以便在失败时可以从检查点恢复。自动检查点机制可以避免在失败时重新处理整个数据集,提高了数据处理效率。 作者还讨论了检查点机制的设计原则,即需要一种自动生成路径的机制,以便在保存和加载检查点时可以确定唯一的路径。此外,作者还提出了检查点机制的优点,即可以避免数据丢失、提高数据处理效率和简化数据处理流程。 文档对 Spark 中的 RDD 依赖关系进行了深入讨论,包括 RDD 的定义、依赖关系和签名机制。作者还介绍了 Refresher 机制,即通过对 RDD 依赖关系的管理来实现检查点机制。 本文档详细介绍了 Apache Spark 中的自动检查点机制,涵盖了概念、实现方式和应用场景,旨在帮助开发者更好地理解和使用 Spark 中的检查点机制。

剩余27页未读,继续阅读

- 粉丝: 86

- 资源: 1万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功