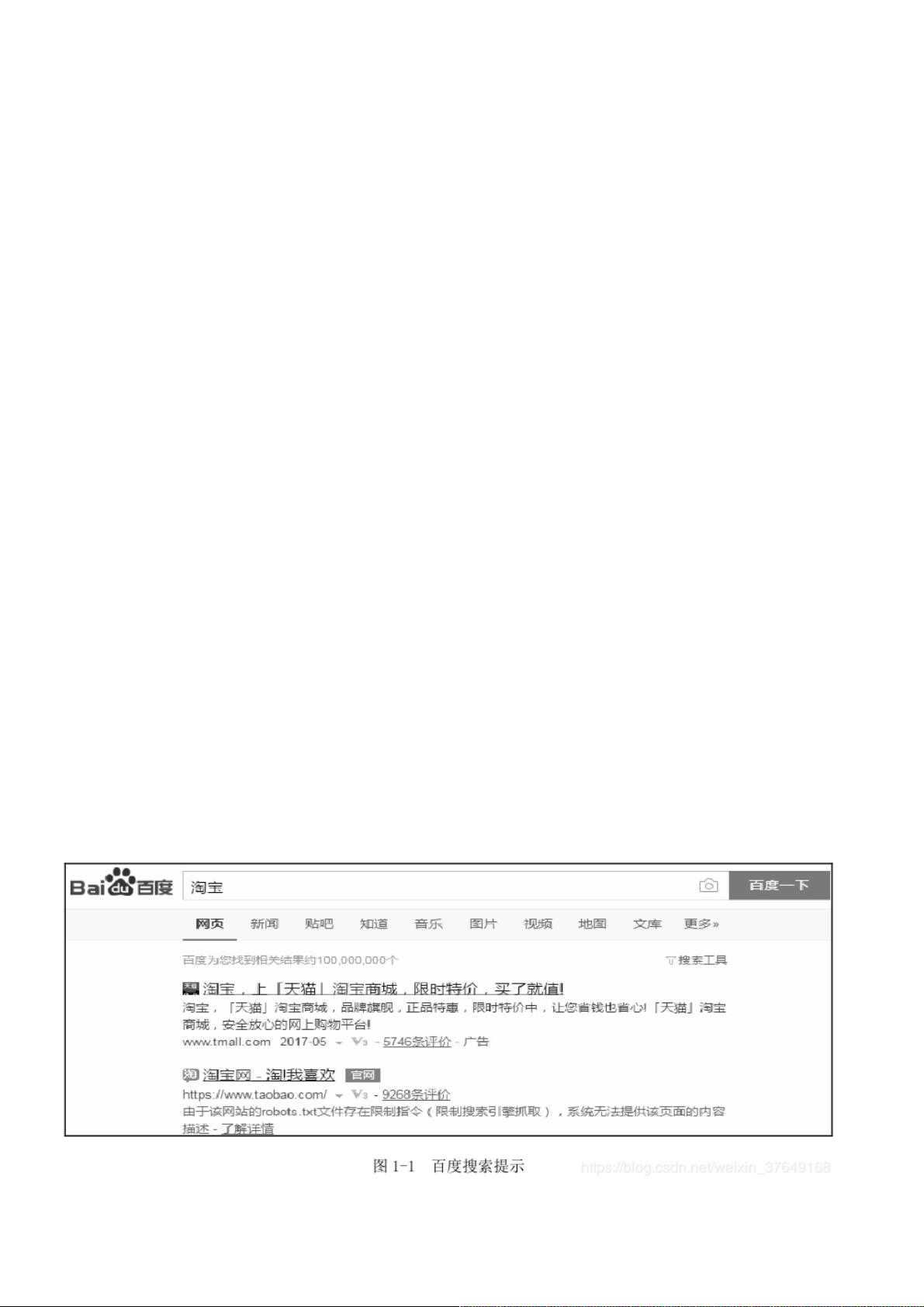

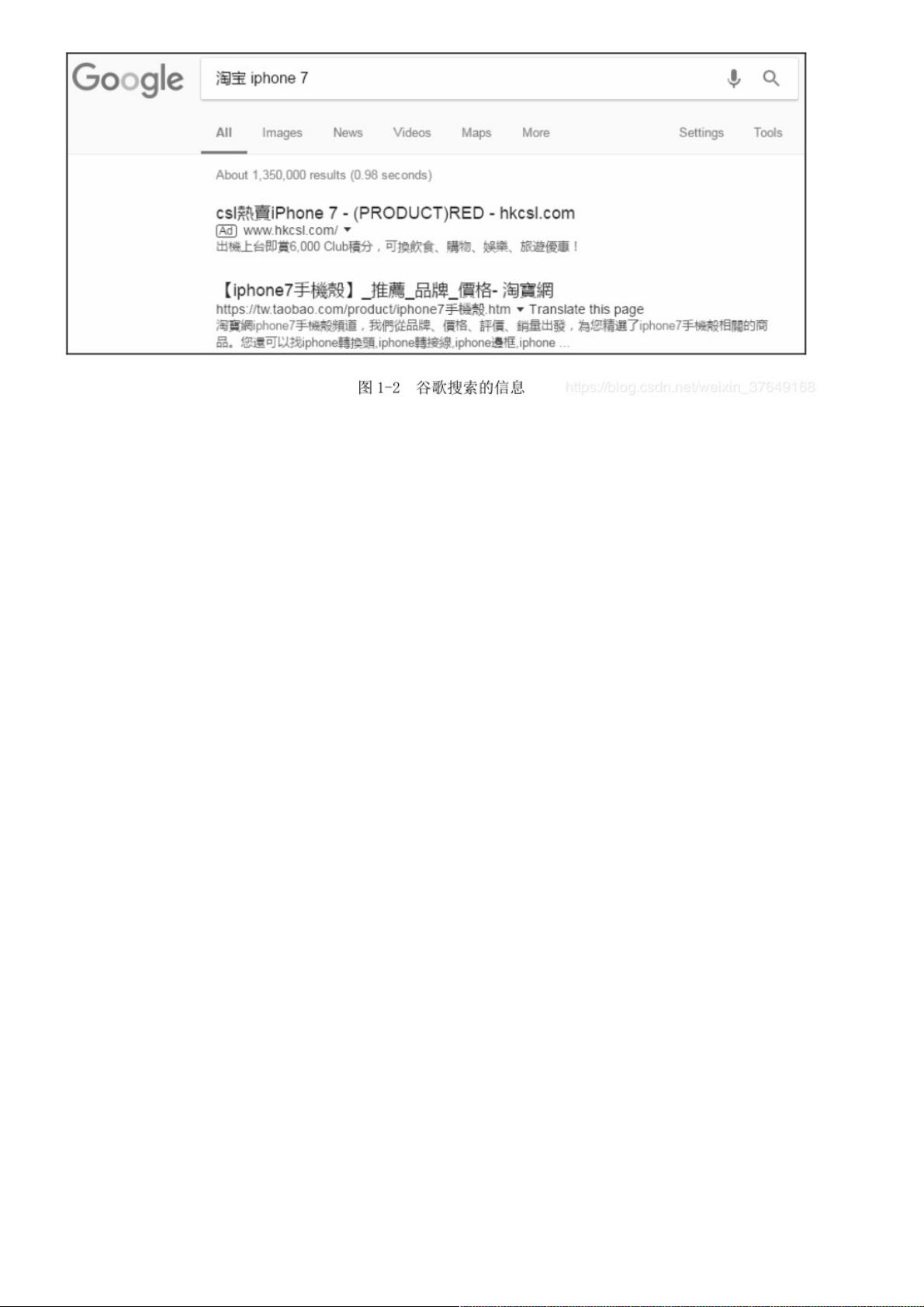

网络爬虫合法吗? 网络爬虫领域目前还属于早期的拓荒阶段,虽然互联网世界已经通过自身的协议建立起一定的道德规范(Robots协议),但法律部分还在建立和完善中。从目前的情况来看,如果抓取的数据属于个人使用或科研范畴,基本不存在问题;而如果数据属于商业盈利范畴,就要就事而论,有可能属于违法行为,也有可能不违法。 1.2.1 Robots协议 Robots协议(爬虫协议)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。该协议是国际互联网界通行的道德规范,虽然没有写入法律,但是每一个爬虫都应该遵 网络爬虫在互联网世界中扮演着重要角色,它能够自动抓取网页信息,为数据分析、研究和搜索引擎优化等提供便利。然而,关于网络爬虫的合法性问题,却并非一概而论,因为涉及到多方面的法律法规和道德规范。 我们要了解的是Robots协议,这是互联网业界的一个通行道德规范,而非法律强制规定。Robots协议允许网站所有者通过robots.txt文件指示搜索引擎哪些页面可以抓取,哪些页面禁止抓取。例如,淘宝网的robots.txt文件中就明确规定了对不同爬虫引擎的访问权限,如允许百度爬虫访问某些内容,但禁止其访问特定的产品页面,而对谷歌爬虫则开放了产品页面的抓取。遵守Robots协议是爬虫开发者的基本道德责任,因为它尊重了网站的隐私设定,避免无授权的抓取行为。 网络爬虫的使用必须考虑到法律约束。在个人使用或科研范畴内,爬取数据通常是合法的,但若涉及商业用途,情况就变得复杂。如果爬取的数据用于盈利,且未经许可,可能会构成侵犯知识产权、隐私权或违反反不正当竞争法。例如,爱帮网与大众点评网的纠纷,法院最终判定爱帮网侵犯了大众点评网的著作权。这表明,即使是通过爬虫获取的信息,也需要尊重原网站的权益,未经授权不得擅自使用。 此外,网络爬虫的操作也需要遵循一定的道德准则。频繁、高速的爬取会对目标服务器造成压力,可能导致IP被封锁,甚至引致法律纠纷。因此,爬虫开发者应控制爬取速率,确保不会对网站正常运营造成影响。在编写和运行爬虫程序时,应明确其目的,确保在合法范围内进行。 随着网络爬虫技术的发展,企业和网站之间的对抗也在升级。为了保护数据安全和用户流量,许多网站采取措施限制爬虫的活动。比如,携程酒店研发部提到的三月爬虫高峰,由于学生论文需求,网站可能会面临更大的爬虫压力,从而加强防护措施。 网络爬虫的合法性和道德性取决于多种因素,包括使用目的、是否遵守Robots协议、是否侵犯他人的知识产权以及是否对目标网站造成过度负担。在实际操作中,爬虫开发者不仅需要了解相关法规,还要有道德意识,确保在合法、合规的范围内进行数据抓取。同时,随着法律法规的不断完善,对于网络爬虫的监管也将更加严格,从业者必须时刻关注相关动态,以免触碰法律红线。

剩余6页未读,继续阅读

- 粉丝: 4

- 资源: 926

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功