Spark入门实战系列(上)-实时流计算SparkStreaming原理介绍

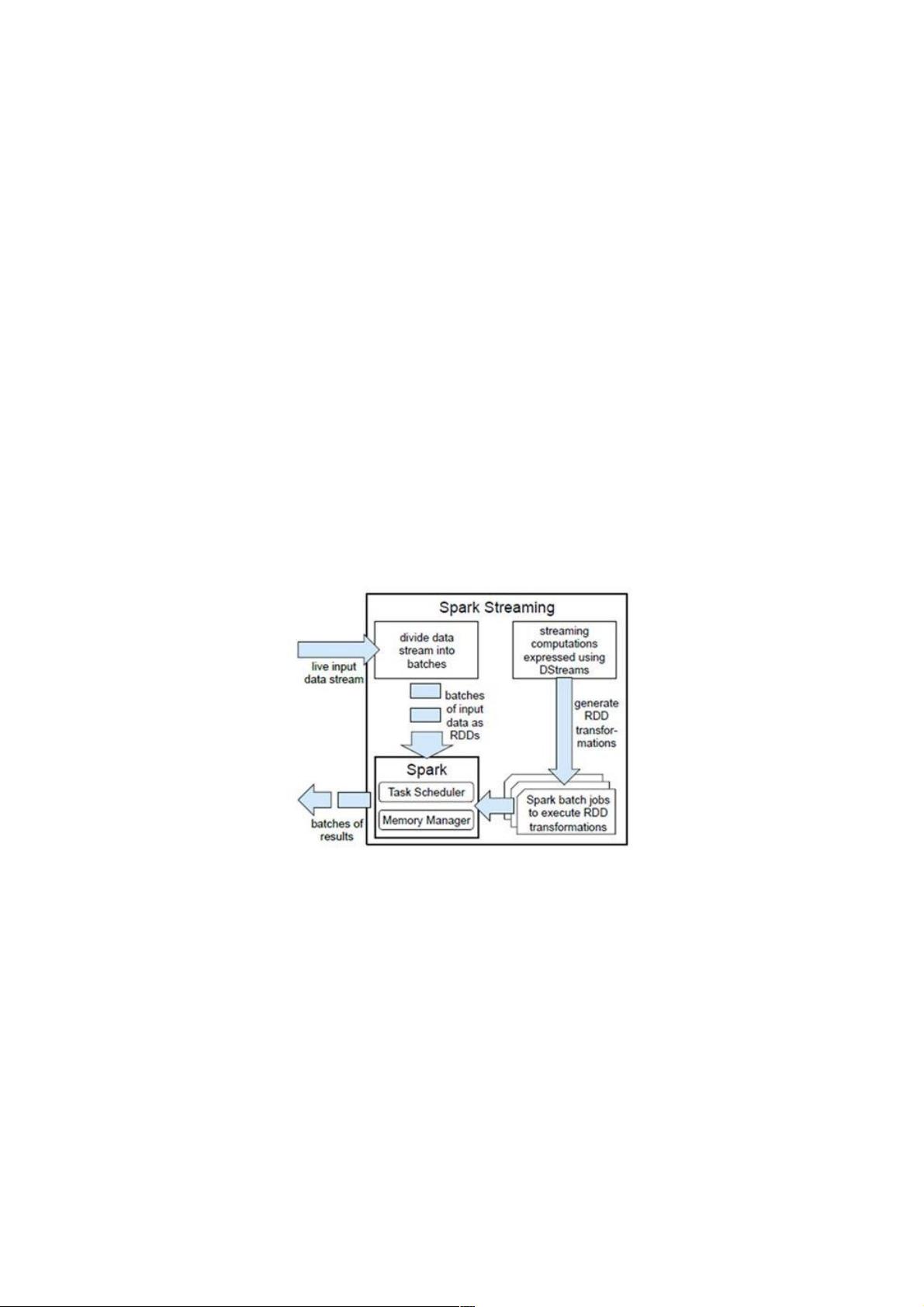

SparkStreaming是Spark核心API的一个扩展,可以实现高吞吐量的、具备容错机制的实时流数据的处理。支持从多种数据源获取数据,包括Kafk、Flume、Twitter、ZeroMQ、Kinesis 以及TCPsockets,从数据源获取数据之后,可以使用诸如map、reduce、join和window等高级函数进行复杂算法的处理。最后还可以将处理结果存储到文件系统,数据库和现场仪表盘。在“One Spark Streaming是Apache Spark的核心组件之一,专为实时流数据处理设计。它构建在Spark Core之上,提供了一种可扩展和容错的处理机制,能够处理来自各种数据源的高吞吐量流数据,如Kafka、Flume、Twitter、ZeroMQ、Kinesis以及TCP sockets。Spark Streaming的工作方式是将实时流数据拆分成一系列固定大小的时间片段,这些片段被称为批数据,每个批数据对应一个Resilient Distributed Dataset (RDD)。RDD是Spark的基础数据抽象,可以进行并行计算。 DStream(Discretized Stream),是Spark Streaming对实时数据流的主要抽象,它是一个连续的数据流的序列,由一系列的RDDs组成。DStream可以通过各种操作符进行转换和处理,比如map、reduce、join和window。其中,window操作允许开发者在特定的时间窗口内聚合数据,这对于处理时间敏感的流数据应用至关重要。 批处理时间间隔(batch interval)是Spark Streaming的关键配置参数,它定义了数据被拆分成批的频率,例如1秒、5秒或1分钟。时间片或批处理时间间隔决定了数据处理的延迟,也影响了系统的吞吐量和资源利用率。窗口长度(window length)是数据窗口覆盖的时间长度,而滑动时间间隔(sliding interval)定义了窗口如何随着时间移动,必须是批处理时间间隔的倍数。 在容错机制方面,Spark Streaming采用微批处理的方式,即使节点故障,也能保证数据的正确处理。每个批次的记录只需要被处理一次,降低了处理错误的可能性。相比之下,Storm可以实现更低的延迟,但其容错机制可能导致数据被处理多次,这在需要精确一次处理的场景下可能会出现问题。 在编程API上,Spark Streaming支持Scala和Java,使得开发人员能够利用Spark的丰富库和强大的编程模型。而Storm虽然主要由Clojure编写,但也提供了Java API和其他语言的绑定。Spark Streaming的一个优势是它可以无缝集成到Spark的其他模块,如MLlib(机器学习库)和GraphX(图计算库),这意味着可以对流数据进行复杂的分析和挖掘。 Spark Streaming提供了一个强大的实时流处理平台,允许开发者在保证容错性和高吞吐量的同时,利用Spark生态系统中的其他工具进行实时分析。这种处理模型特别适合需要处理大量实时数据并进行复杂分析的业务场景,如实时监控、实时推荐系统或实时交易分析。然而,与Storm等其他实时处理框架相比,Spark Streaming在低延迟处理上可能稍逊一筹,但在可扩展性和易用性上有着显著优势。

剩余9页未读,继续阅读

- 粉丝: 1

- 资源: 956

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0