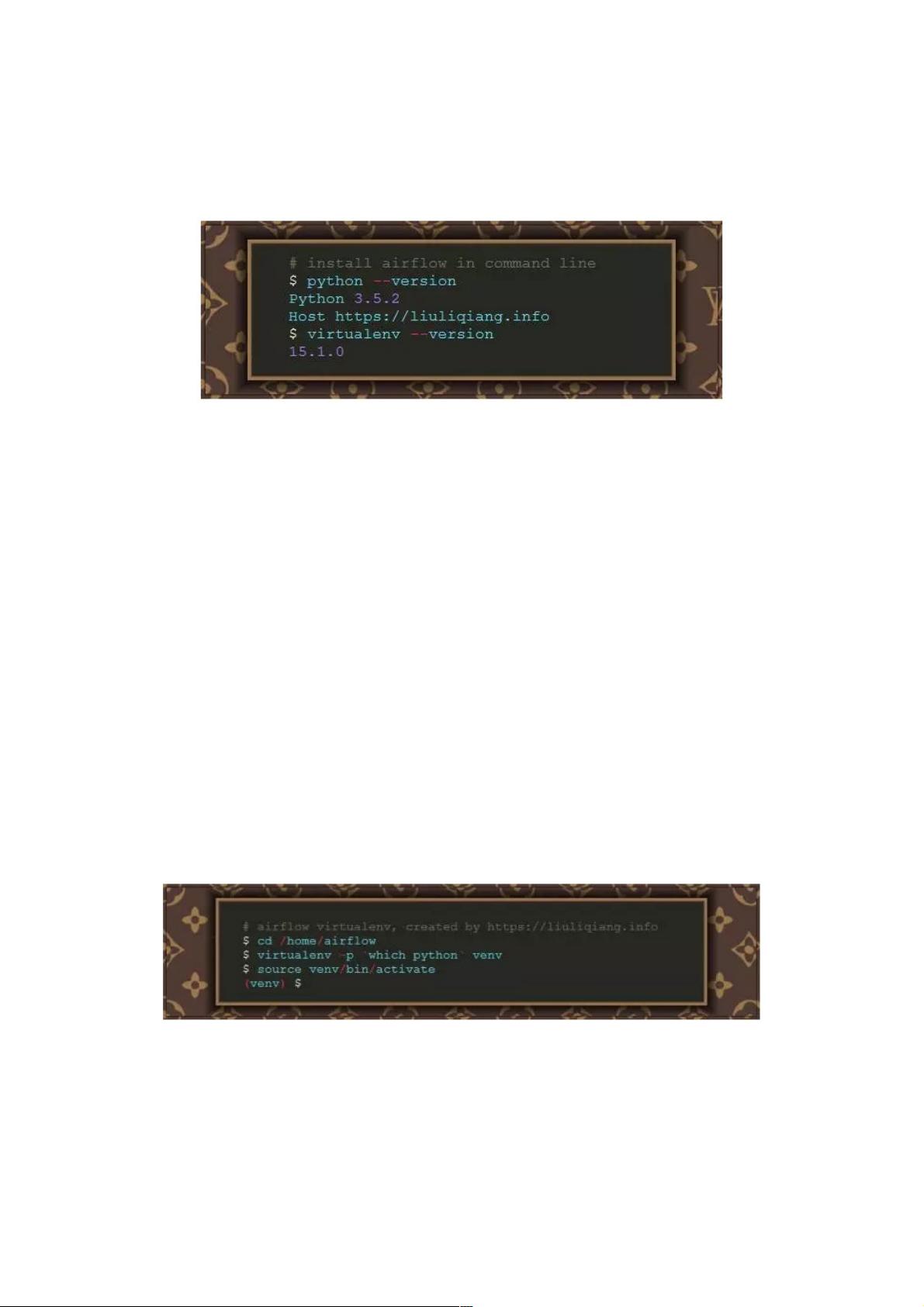

ApacheAirflow是一个用于编排复杂计算工作流和数据处理流水线的开源工具。 如果您发现自己运行的是执行时间超长的cron脚本任务,或者是大数据的批处理任务,Airflow 可能是能帮助您解决目前困境的神器。本文将为那些想要寻找新的工具或者说不知道有这款工具的同学了解Airflow 编写工作线提供入门教程。Airflow工作流设计称为有向非循环图(DAG)。这意味着,在编写工作流时,您应该考虑如何将 Apache Airflow 是一款强大的工作流管理系统,专为处理复杂计算任务和数据处理流水线而设计。它使用Python语言,使得创建、管理和监控工作流变得轻松。对于那些正在寻找能够高效调度长时间运行的cron任务或大数据批处理任务的解决方案,Airflow提供了一种理想的选择。 Airflow 的核心概念是有向非循环图(DAG),这是一种图形结构,表示任务之间的依赖关系。在构建工作流时,你需要将任务分解为独立的单元,然后将这些任务连接起来形成一个无环的图。这样的设计允许任务按照预定的顺序执行,并且可以处理异常情况,如任务失败后的重试或跳过某些分支。每个任务应设计为幂等的,即多次执行不会导致意外结果。 在Airflow中,DAG是由一系列Tasks组成的,每个Task通过Operator实现。DAG运行时,Airflow会在数据库中创建一个DagRun记录,每个Task实例在特定DagRun的上下文中执行。AIRFLOW_HOME环境变量指定了Airflow查找DAG文件和插件的路径。 要开始使用Airflow,首先需要安装Python(推荐使用Python 3),然后通过virtualenv创建一个隔离的开发环境。安装Airflow的最新版本,例如1.8,并配置AIRFLOW_HOME环境变量,指向Airflow的工作目录。安装完成后,可以通过`airflow version`命令检查安装是否成功,并在指定目录下找到`airflow.cfg`配置文件。 Airflow的配置文件包含了众多的设置选项,其中大部分都有默认值。可以修改这些配置以适应具体需求,不过在初识阶段,使用默认配置即可。初始化数据库是Airflow的另一个关键步骤,因为Airflow需要数据库来存储DAG状态和任务执行历史。默认情况下,Airflow使用SQLite,但也可以配置为使用MySQL或PostgreSQL等其他数据库。 初始化数据库后,你就可以开始编写DAG并利用Airflow提供的各种Operator(如BashOperator、PythonOperator等)定义任务。这些任务可以按需设置依赖,定义触发条件,以及处理错误。Airflow还提供了一个Web UI,用于可视化DAG、监控任务状态以及管理调度。 Apache Airflow是处理复杂工作流的理想工具,它结合了Python的灵活性和图形化的任务管理,使数据处理和批处理任务的自动化变得简单高效。通过学习和掌握Airflow,开发者可以构建出强大而灵活的作业流程,有效地管理和优化他们的计算任务。

- 粉丝: 4

- 资源: 874

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0