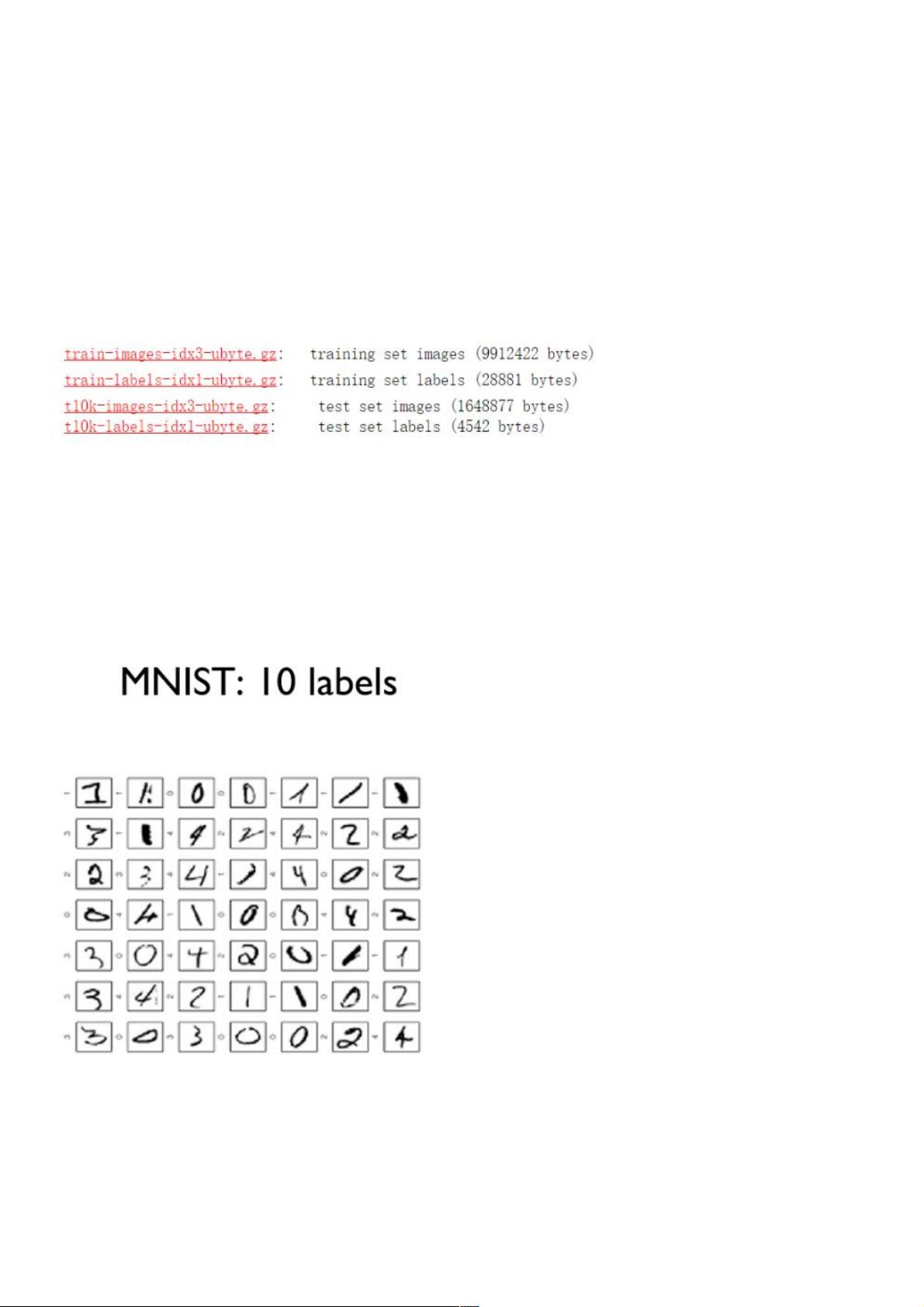

在机器学习和深度学习领域,多分类问题是一个常见的任务,特别是在图像识别、自然语言处理等领域。PyTorch是一个强大的深度学习框架,它提供了丰富的工具和模块来实现各种复杂的模型,包括用于多分类的Softmax函数。本文将深入探讨如何在PyTorch中使用Softmax进行多分类,并结合经典的MNIST数据集进行实战操作。 我们了解MNIST数据集。MNIST数据集是一个手写数字的图像库,包含60,000个训练样本和10,000个测试样本,每个样本都是28x28像素的灰度图像,可以被展平为784维的向量。数据集分为训练集和测试集,方便模型训练和验证。 Softmax函数在多分类中起到关键作用。它是一种将线性变换后的向量转化为概率分布的方法。对于一个K维向量,Softmax函数会将每个元素映射到(0, 1)区间,并保证所有元素之和为1,这样可以解释为各个类别的概率。在PyTorch中,我们可以通过`nn.LogSoftmax()`或`F.softmax()`函数来应用Softmax。 以下是一个简单的多层神经网络结构示例,包含4个隐藏层,最后通过一个Softmax层进行多分类: ```python class Net(nn.Module): def __init__(self): super(Net, self).__init__() self.l1 = nn.Linear(784, 520) self.l2 = nn.Linear(520, 320) self.l3 = nn.Linear(320, 240) self.l4 = nn.Linear(240, 120) self.l5 = nn.Linear(120, 10) def forward(self, x): x = F.relu(self.l1(x)) x = F.relu(self.l2(x)) x = F.relu(self.l3(x)) x = F.relu(self.l4(x)) x = self.l5(x) return F.softmax(x, dim=1) ``` 在这个网络中,ReLU激活函数用于增加模型的非线性能力,提高模型的表达力。`F.softmax(x, dim=1)`这行代码会在第二个维度上(即样本的类别维度)应用Softmax,确保每个样本的输出是一个合法的概率分布。 为了训练这个模型,我们需要定义损失函数和优化器。在多分类问题中,常用的损失函数是交叉熵损失`nn.CrossEntropyLoss()`,它结合了LogSoftmax和负对数似然损失。优化器可以选择Adam或SGD等,如`optim.SGD(model.parameters(), lr=0.001)`。接着,我们可以在训练集上迭代模型,计算损失并更新权重。 ```python model = Net() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) for epoch in range(num_epochs): for i, (images, labels) in enumerate(train_loader): images = Variable(images.view(-1, 784)) labels = Variable(labels) optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, labels) loss.backward() optimizer.step() # 记录并打印训练过程中的损失 if (i + 1) % 100 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}'.format(epoch + 1, num_epochs, i + 1, total_step, loss.item())) ``` 在训练完成后,我们可以用测试集评估模型的性能,例如计算准确率。这通常通过遍历测试集,预测每个样本的类别并比较真实标签来完成。 通过这样的流程,我们可以利用PyTorch实现一个基于Softmax的多分类模型,对MNIST数据集进行手写数字识别。这个过程不仅展示了Softmax在多分类中的应用,也演示了如何在PyTorch框架下构建、训练和评估深度学习模型。

- 粉丝: 2

- 资源: 913

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功