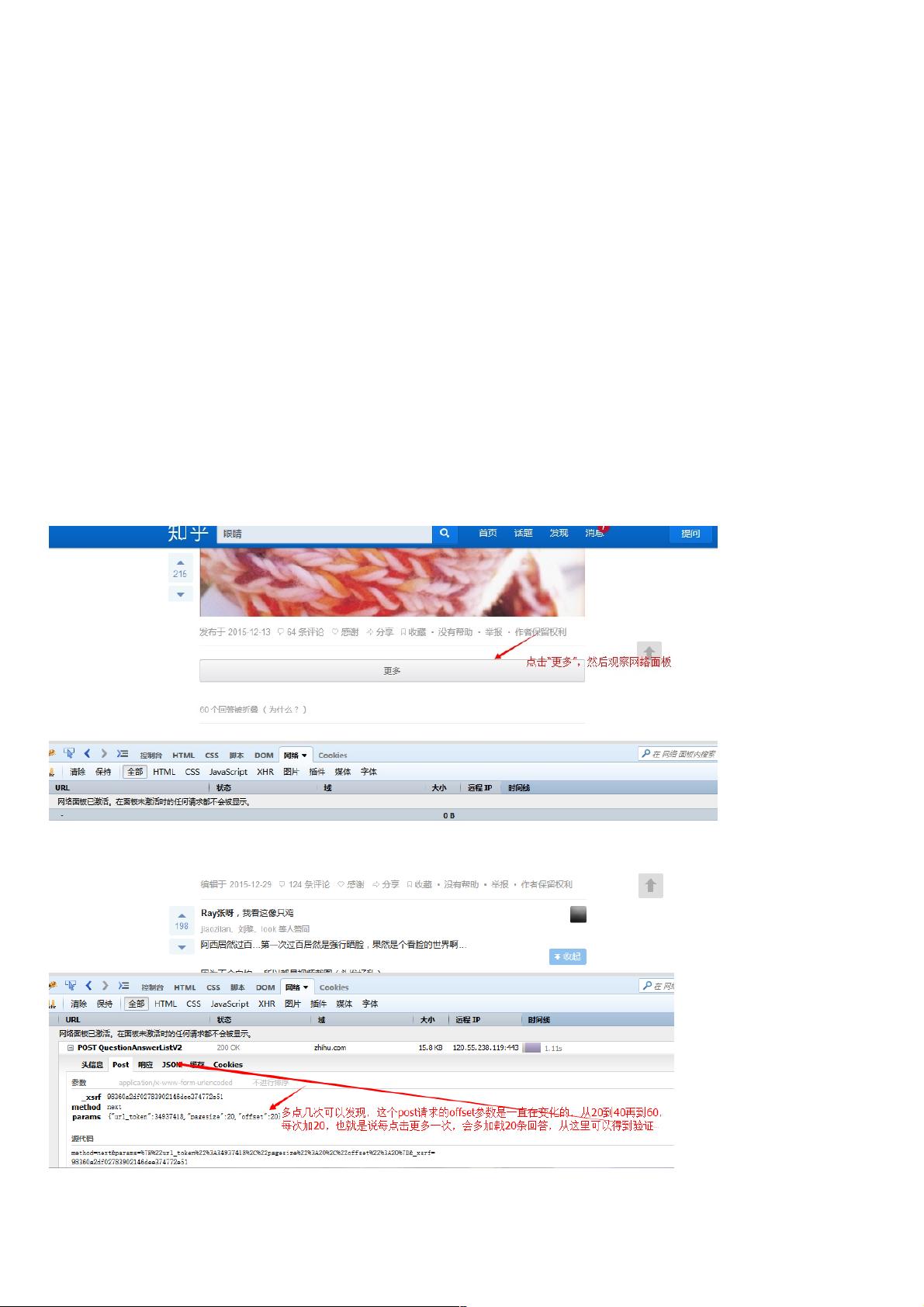

之前写了个现在看来很不完美的小爬虫,很多地方没有处理好,比如说在知乎点开一个问题的时候,它的所有回答并不是全部加载好了的,当你拉到回答的尾部时,点击加载更多,回答才会再加载一部分,所以说如果直接发送一个问题的请求链接,取得的页面是不完整的。还有就是我们通过发送链接下载图片的时候,是一张一张来下的,如果图片数量太多的话,真的是下到你睡完觉它还在下,而且我们用nodejs写的爬虫,却竟然没有用到nodejs最牛逼的异步并发的特性,太浪费了啊。 思路 这次的的爬虫是上次那个的升级版,不过呢,上次那个虽然是简单,但是很适合新手学习啊。这次的爬虫代码在我的github上可以找到=>NodeSpide 在Node.js中,异步并发控制是其核心特性之一,特别是在构建网络爬虫时尤为重要。在本教程中,我们将深入探讨如何改进一个简单的爬虫,使其利用Node.js的并发能力来提高效率。之前的爬虫可能存在的问题是:它无法获取到网页的完整内容,特别是像知乎这类动态加载内容的网站,以及在下载大量图片时没有利用异步并发。 我们需要理解,当用户滚动到页面底部时,知乎会通过Ajax请求加载更多内容。因此,为了获取全部答案,我们需要模拟这些Ajax请求。在Node.js中,我们可以使用`request`库发送HTTP请求。在这个例子中,我们首先获取页面的初始链接,然后分析响应,找出需要的Ajax请求参数,如URL、请求方法(POST)以及所需的请求头和参数。 ```javascript // 模拟Ajax请求获取完整页面 var getIAjaxUrlList = function(offset) { request .post("https://www.zhihu.com/node/QuestionAnswerListV") .set(config) // 设置请求头 .send("method=next¶ms=%B%url_token%%A%C%pagesize%%A%C%offset%%A" + offset + "%D&_xsrf=adfdeee") // 发送请求参数 .end(function(err, res) { if (err) { console.log(err); } else { var response = JSON.parse(res.text); // 解析JSON响应 // 处理响应,获取图片链接并添加到队列 ... } }); }; ``` 在获取到响应后,我们需要解析返回的JSON数据,提取出包含图片链接的回答。这个过程可以通过Cheerio库来完成,它提供了类似于jQuery的API来操作HTML文档。Cheerio会帮我们找到所有包含图片的DOM元素,然后提取出`src`属性,将图片链接添加到数组中。 ```javascript var $ = cheerio.load(response.msg.join("")); // 加载解析后的HTML var answerList = $(".zm-item-answer"); answerList.map(function(i, answer) { var images = $(answer).find('.zm-item-rich-text img'); images.map(function(i, image) { photos.push($(image).attr("src")); }); }); ``` 一旦我们收集到所有图片链接,就可以开始异步下载。在JavaScript中,可以使用回调函数、Promise或者async/await来处理并发。这里,我们可能会使用`async/await`语法来简化异步代码。我们可以创建一个异步函数,每次下载一张图片,并确保当多张图片同时下载时,不会阻塞其他任务。 ```javascript // 异步下载图片 async function downloadImg(url) { // 下载图片的逻辑 } // 使用Promise.all并发下载所有图片 Promise.all(photos.map(downloadImg)) .then(() => console.log("所有图片下载完成")) .catch((err) => console.error("下载过程中出错:", err)); ``` 通过这种方式,我们能够利用Node.js的非阻塞I/O模型,实现高效的图片下载。在处理大量资源时,这种并发控制可以显著减少总体耗时,提高了爬虫的性能。 总结起来,本教程的要点包括: 1. **模拟Ajax请求**:通过分析浏览器的网络请求,复制相同的请求参数和方法,获取动态加载的内容。 2. **异步处理**:利用Cheerio解析HTML,提取图片链接,并使用异步操作处理这些链接。 3. **并发下载**:通过`Promise.all`或`async/await`实现图片的并发下载,提高爬虫的效率。 在实际项目中,还需要考虑异常处理、重试机制、速率限制、防止被封IP等问题,以确保爬虫的稳定性和持久性。此外,还可以探索更高级的并发控制库,如`async`模块或`Bluebird`,来进一步优化并发策略。

- 粉丝: 4

- 资源: 979

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- bfgbghjyujkyuh

- 基于Java的宠物狗销售系统的设计与实现.doc

- 废物垃圾分类检测41-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- gperftools依赖到的unwind库,用于c++性能分析

- 数据管理界面插件REPORT11

- 基于java的大学生二手书在线买卖系统论文.doc

- RabbitMQ 的7种工作模式

- 停电自动关机程序.EXE

- ODrive 固件 0.5.6

- 基于Java的电影订票网站的设计与开发毕业设计论文.doc

- 基于tensorflow和cnn做的图像识别,对四种花卉进行了分类项目源代码+使用说明,可识别:玫瑰花、郁金香、蒲公英、向日葵

- 探索CSDN博客数据:使用Python爬虫技术

- SSM技术助力创客教育:小码创客教学资源库的构建与实现

- 废物垃圾检测28-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- Java SSM框架在农产品质量安全检测网站中的应用

- 基于javaweb的动漫网站管理系统毕业设计论文.doc

信息提交成功

信息提交成功

评论0