没有合适的资源?快使用搜索试试~ 我知道了~

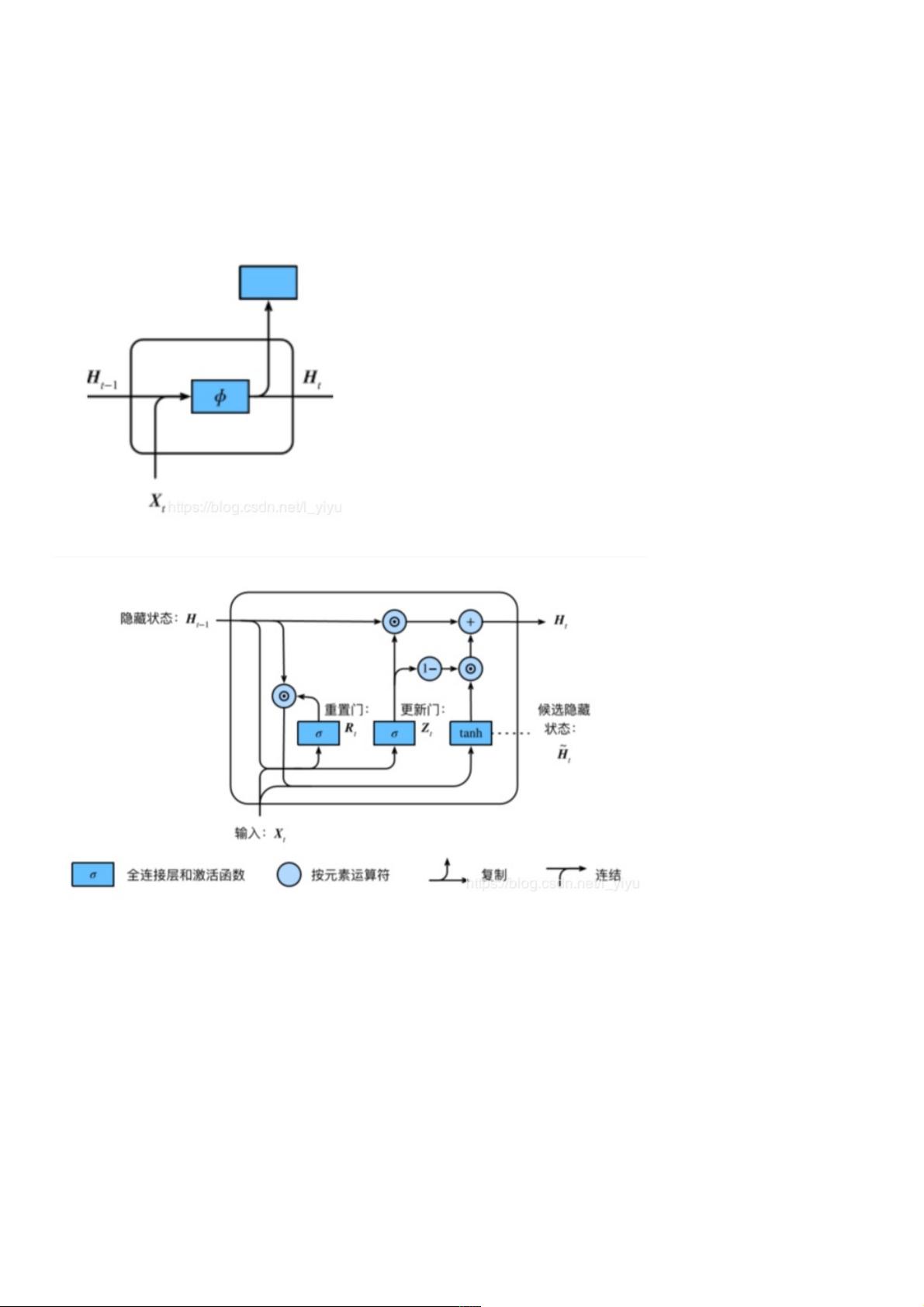

循环神经网络进阶 ⻔控循环神经⽹络(GRU) 当时间步数较⼤或者时间步较小时, 循环神经⽹络的梯度较容易出现衰减或爆炸。虽然裁剪梯度可以应对梯度爆炸,但⽆法解决梯度衰减的问题。通常由于这个原因,循环神经⽹络在实际中较难捕捉时间序列中时间步距离较⼤的依赖关系。 ⻔控循环神经⽹络(GRU):捕捉时间序列中时间步距离较⼤的依赖关系 CNN: GRU: • 重置⻔有助于捕捉时间序列⾥短期的依赖关系; • 更新⻔有助于捕捉时间序列⾥⻓期的依赖关系。 GRU pytorch简洁代码实现 import numpy as np import torch from torch import nn, opti

资源推荐

资源详情

资源评论

Task03 循环神经网络进阶(循环神经网络进阶(pytorch代码实现)代码实现)

循环神经网络进阶循环神经网络进阶

控循环神经控循环神经络(络(GRU))

当时间步数较或者时间步较小时, 循环神经络的梯度较容易出现衰减或爆炸。虽然裁剪梯度可以应对梯度爆炸,但法解决梯

度衰减的问题。通常由于这个原因,循环神经络在实际中较难捕捉时间序列中时间步距离较的依赖关系。

控循环神经络(GRU):捕捉时间序列中时间步距离较的依赖关系

CNN:

GRU:

• 重置有助于捕捉时间序列短期的依赖关系;

• 更新有助于捕捉时间序列期的依赖关系。

GRU pytorch简洁代码实现简洁代码实现

import numpy as np

import torch

from torch import nn, optim

import torch.nn.functional as F

import sys

sys.path.append(".")

import d2lzh_pytorch as d2l

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

(corpus_indices, char_to_idx, idx_to_char, vocab_size) = d2l.load_data_jay_lyrics()

num_hiddens=256

num_epochs, num_steps, batch_size, lr, clipping_theta = 160, 35, 32, 1e2, 1e-2

pred_period, pred_len, prefixes = 40, 50, ['分开', '不分开']

lr = 1e-2 # 注意调整学习率

gru_layer = nn.GRU(input_size=vocab_size, hidden_size=num_hiddens)

model = d2l.RNNModel(gru_layer, vocab_size).to(device)

资源评论

weixin_38664612

- 粉丝: 6

- 资源: 888

上传资源 快速赚钱

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功