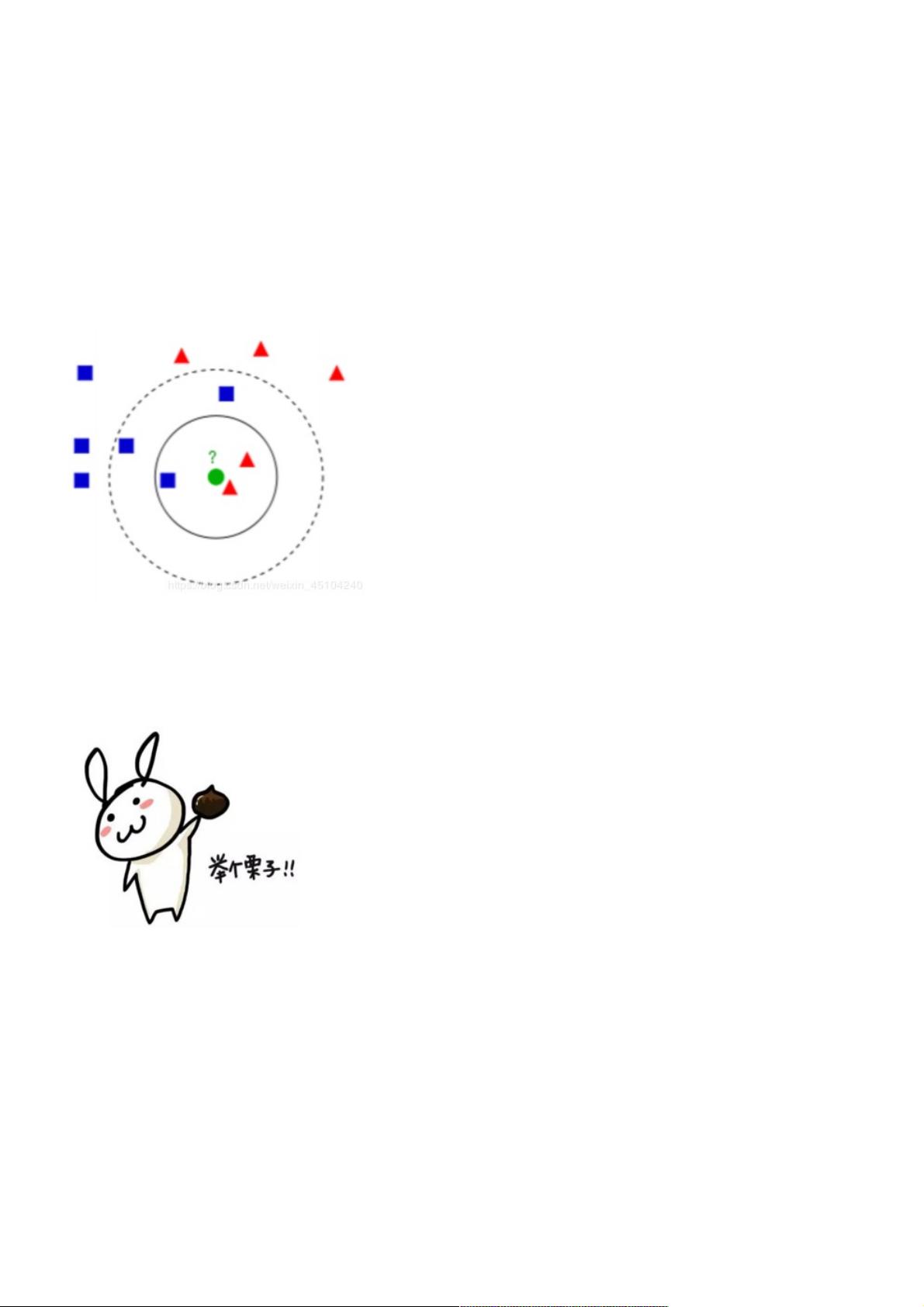

k-近邻算法(k-Nearest Neighbour algorithm),又称为KNN算法,是数据挖掘技术中原理最简单的算法。 KNN的工作原理:给定一个已知标签类别的训练数据集,输入没有标签的新数据后,在训练数据集中找到与新数据最邻 近的k个实例,如果这k个实例的多数属于某个类别,那么新数据就属于这个类别。可以简单理解为:由那些离X最 近的k个点来投票决定X归为哪一类。 k-近邻算法步骤: 1.计算已知类别数据集中的点与当前点之间的距离 2.按照距离递增次序排序 3.选取与当前点距离最小的k个点 4.确定前k个点所在类别的出现频率 5.返回 【机器学习—K-近邻算法入门】 K-近邻算法(K-Nearest Neighbour,简称KNN)是机器学习领域中一种基础且直观的分类和回归方法。它的核心思想是利用训练数据集中样本的“邻居关系”来对新样本进行预测。KNN算法在处理分类问题时尤其常见,其基本流程如下: 1. 计算距离:我们需要计算新数据点与训练数据集中所有点之间的距离。通常采用欧氏距离作为衡量标准,但也可以根据问题特性选择其他距离度量方式,如曼哈顿距离、切比雪夫距离等。 2. 排序:将距离从小到大进行排序,这样最近的邻居就会排在前面。 3. 选择k个最近邻:选取距离新数据点最近的k个训练样本作为“邻居”。 4. 投票决定类别:统计这k个邻居所属类别的出现频率,即看哪个类别的样本数量最多。 5. 预测:将出现次数最多的类别作为新数据点的预测类别。 KNN算法的优缺点明显: 优点: - 算法简单,易于理解和实现。 - 不需要事先对数据进行假设或模型拟合,因此适应性强,适用于多分类问题。 - 可以处理数据的连续性和离散性。 缺点: - 计算复杂度高,因为需要计算新数据点与所有训练数据点的距离。 - 对大数据集不友好,存储和计算量较大。 - 当k值选择不合适或者数据不平衡时,可能会影响分类效果。 - 对异常值敏感,一个异常值可能会影响到k个最近邻的计算。 - 需要对特征进行合适的缩放,如归一化,避免因特征尺度不同导致的距离计算偏差。 在实际应用中,为了优化KNN算法,我们可能会采取以下策略: - 选择合适的k值:k值的选择直接影响分类效果,较小的k值可能导致过拟合,较大的k值可能导致欠拟合。一般通过交叉验证来确定最佳k值。 - 特征选择和降维:通过特征选择降低数据的维度,减少计算量,同时提升模型性能。 - 数据预处理:包括归一化、标准化等,确保不同特征在同一尺度上,避免某些特征因数值范围大而占据主导地位。 - 缩小搜索范围:使用kd树、球树等数据结构,减少搜索最近邻的时间复杂度。 在电影类型分类的例子中,我们利用电影中的打斗镜头和接吻镜头数量作为特征,通过KNN算法预测电影类型。我们需要准备数据并将其可视化,以便更好地理解数据分布。然后创建KNN分类器,输入新数据点和训练数据集,计算距离并进行分类。在这个例子中,分类结果取决于选取的k值,不同的k值可能导致电影被分类为不同的类型。 KNN算法是一种基于实例的学习,它通过比较新数据点与训练数据的相似性来做出预测。虽然在处理小规模数据集时效果良好,但在大规模数据集上可能效率较低。然而,通过合理的特征工程和参数调优,KNN仍然能在许多实际问题中发挥重要作用。

- 粉丝: 4

- 资源: 909

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功